LLM - Data Tuning

LLM - Data Tuning 微调

Table of contents:

- LLM - Data Tuning 微调

- Instruction-Tuning (指示微调)

- Fine-Tuning (微调)

- LLM Evaluation

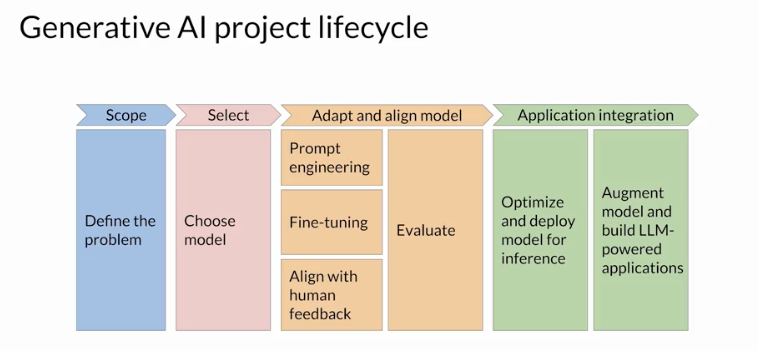

- Adapt and align large language models

- Traning Terms

ref:

- https://gitcode.csdn.net/65e93d1e1a836825ed78e986.html

overview

目前学术界一般将 NLP 任务的发展分为四个阶段,即 NLP 四范式: [^通俗易懂的LLM(上篇)]

- 第一范式: 基于「

传统机器学习模型」的范式,如 TF-IDF 特征+朴素贝叶斯等机器算法; 第二范式: 基于「

深度学习模型」的范式,如 word2vec 特征+LSTM 等深度学习算法,相比于第一范式,模型准确有所提高,特征工程的工作也有所减少;第三范式: 基于「

预训练模型+fine-tuning」的范式,如 Bert+fine-tuning 的 NLP 任务,相比于第二范式,模型准确度显著提高,模型也随之变得更大,但小数据集就可训练出好模型;- 第四范式: 基于「

预训练模型+Prompt+预测」的范式,如 Bert+Prompt 的范式相比于第三范式,模型训练所需的训练数据显著减少。

在整个 NLP 领域,你会发现整个发展是朝着精度更高 少监督,甚至无监督的方向发展的。下面我们对第三范式 第四范式进行详细介绍。

- 总的来说

- 基于 Fine-Tuning 的方法是让预训练模型去迁就下游任务。

- 基于 Prompt-Tuning 的方法可以让下游任务去迁就预训练模型。

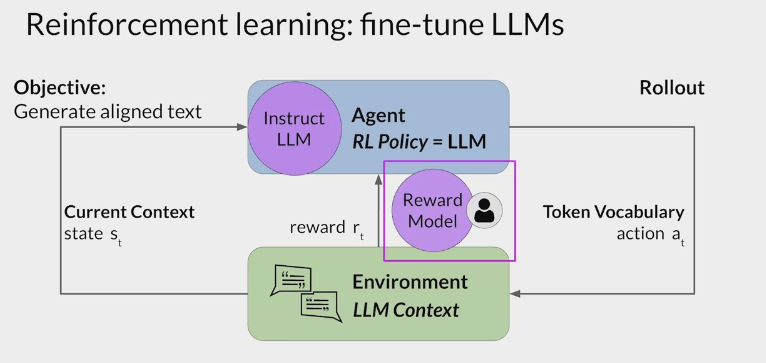

LLM 模型训练过程中的三个核心步骤

- 预训练语言模型 $LLM^{SSL}$ (self-supervised-learning)

- (指令)监督微调预训练模型 $LLM^{SFT}$ (supervised-fine-tuning)

- 基于人类反馈的强化学习微调 $LLM^{RL}$ (reinforcement-learning)

Summary:

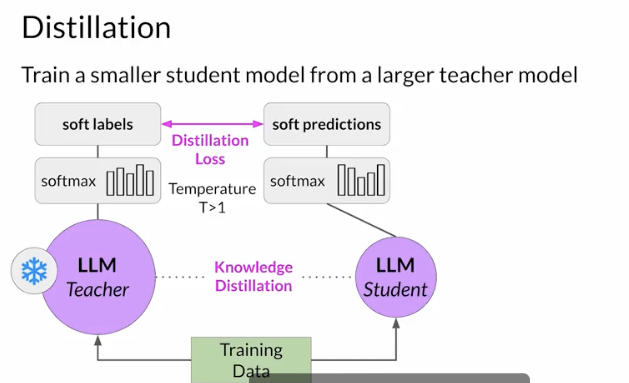

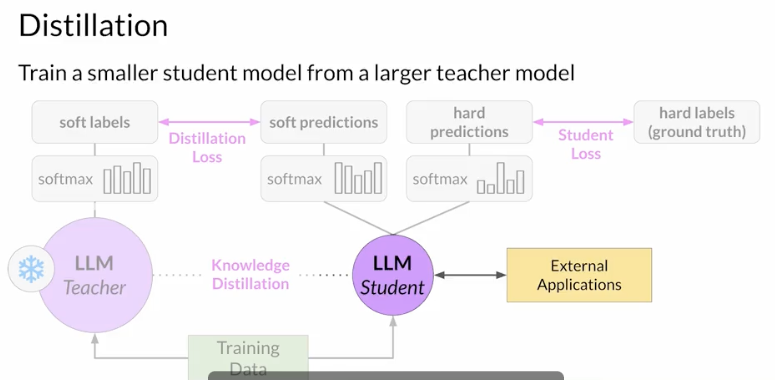

- Instruction fine-tuning updates model weights using labeled datasets, whereas in-context learning uses examples during inference.

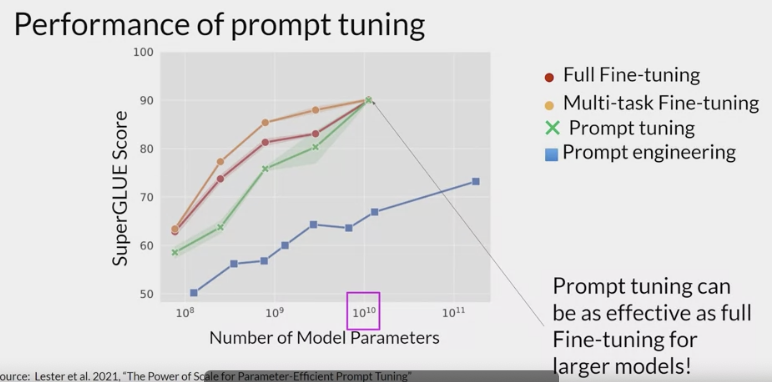

- Prompt tuning adjusts only a few parameters (tokens), not all hyperparameters of the model.

- Catastrophic forgetting occurs when fine-tuning on a single task degrades performance on other tasks.

- BLEU (Bilingual Evaluation Understudy) measures precision by comparing generated text to reference translations.

- FLAN-T5 used multi-task finetuning, which helps prevent catastrophic forgetting.

- Smaller LLMs struggle with few-shot learning as they have limited capacity to generalize from small examples.

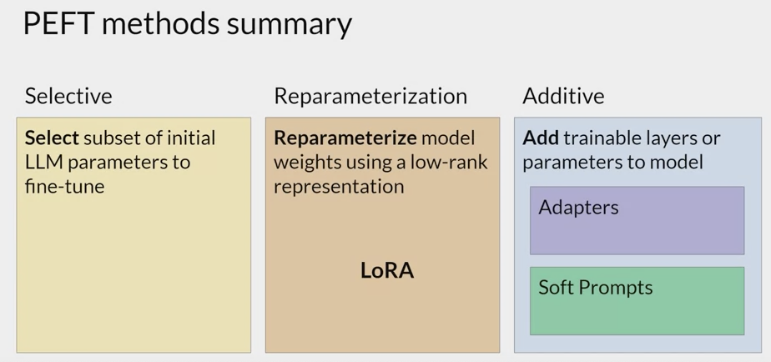

- Reparameterization and Additive are two PEFT methods that adjust or add parameters to efficiently fine-tune models.

- PEFT methods like LoRA can dramatically reduce memory needed for fine-tuning.

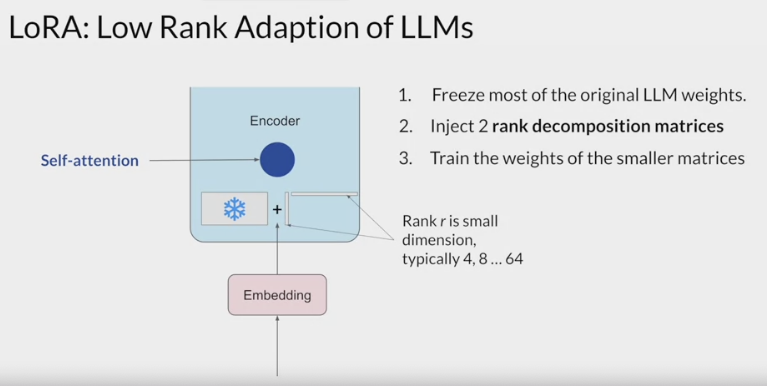

LoRA (Low-Rank Adaptation) optimizes by focusing on smaller matrices, reducing the computational load. it decomposes weights into two smaller rank matrices and trains those instead of the full model weights.

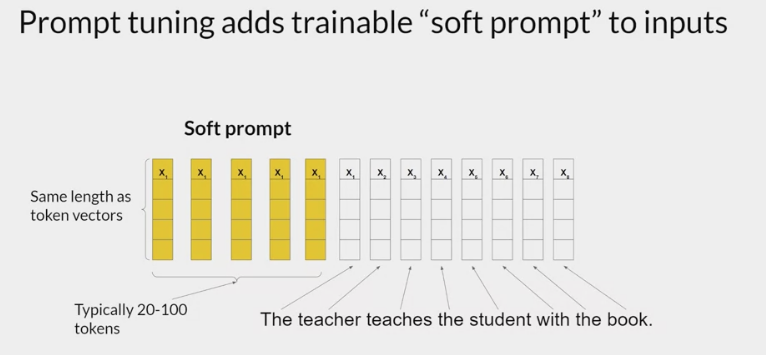

Soft prompts are trainable tokens used to guide the model’s performance on specific tasks. A set of trainable tokens that are added to a prompt and whose values are updated during additional training to improve performance on specific tasks.

- to prevent catastrophic forgetting it is important to fine-tune on multiple tasks with a lot of data.

改進 LLM

怎麼使用、使用哪個 LLM 來部屬產品? [^如何改進LLM]

- 用 GPT4 還是 GTP3.5?Llama 聽說不錯?

- 用 API 來服務還是要自己訓練、部屬模型?

- 需要 Finetune 嗎?

- 要做 prompt engineering 嗎?怎麼做?

- 要做 retrieval 嗎?,RAG(Retrieval Augmented Generation)架構對我的任務有幫助嗎?

- 主流模型就有十多個、Training 有數十種的方法,到底該怎麼辦?

- ……

FSDL 的課程:

- 李宏毅老師

- Deep Learning.ai 的 Andrew Ng 老師

- UCBerkeley 的 Full Stack Deep Learning

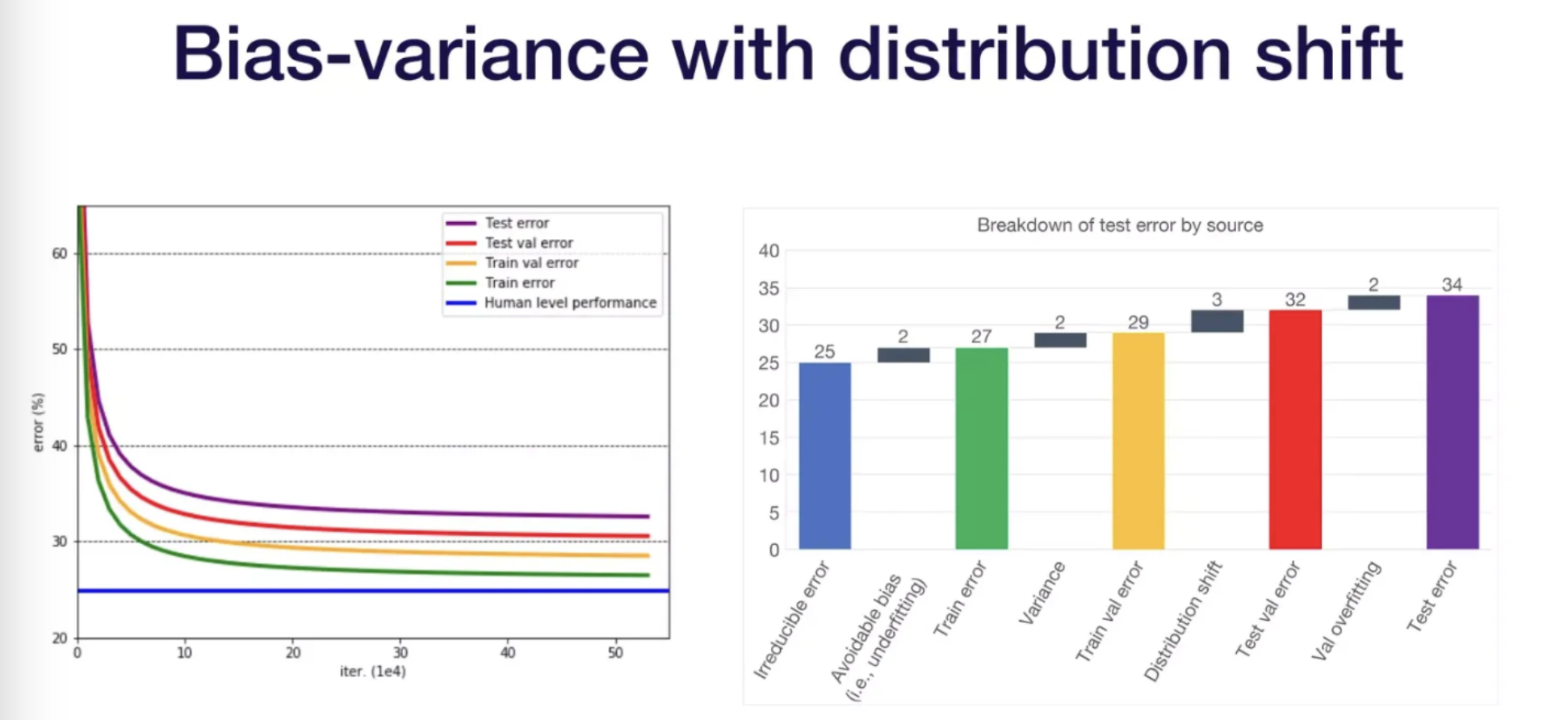

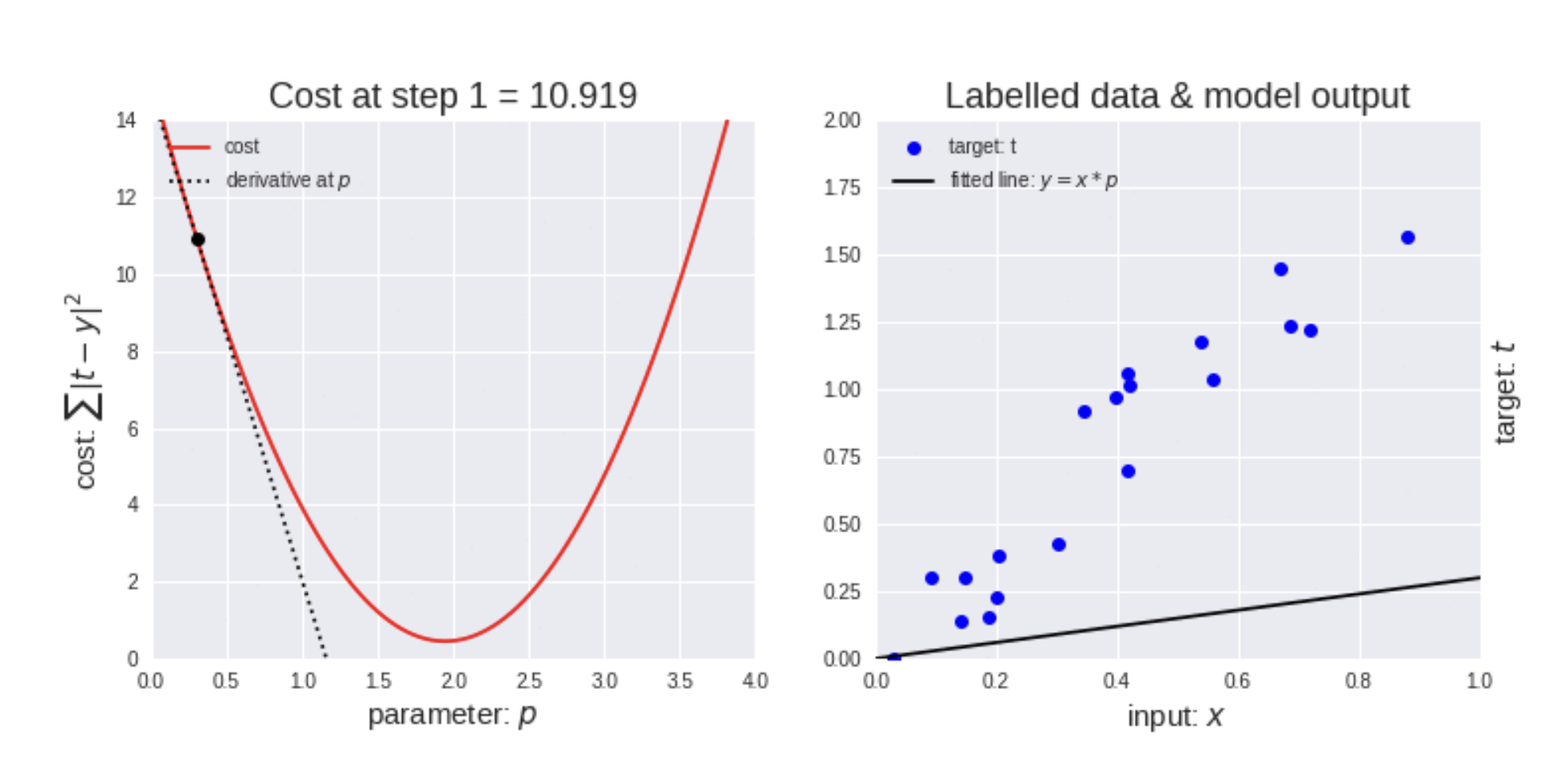

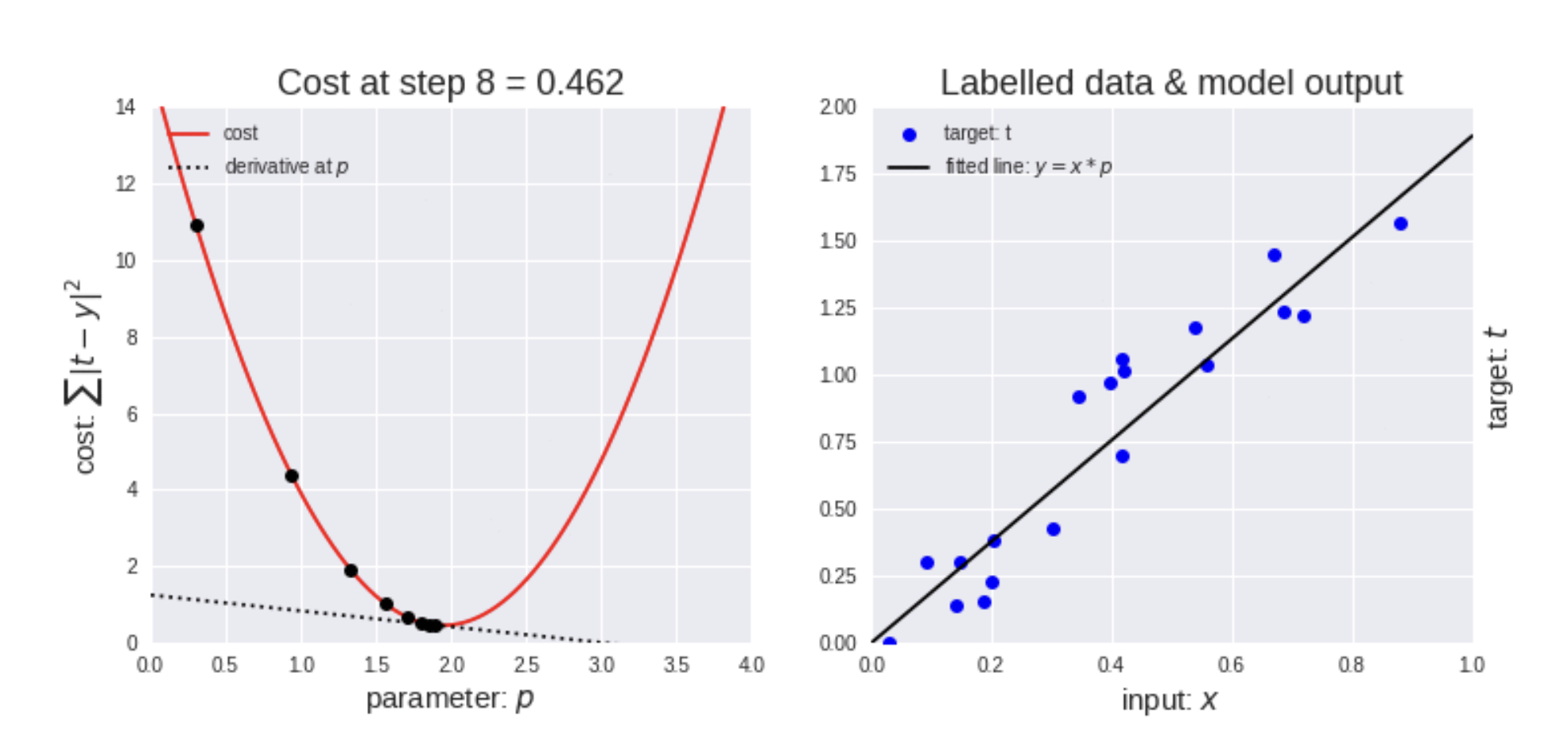

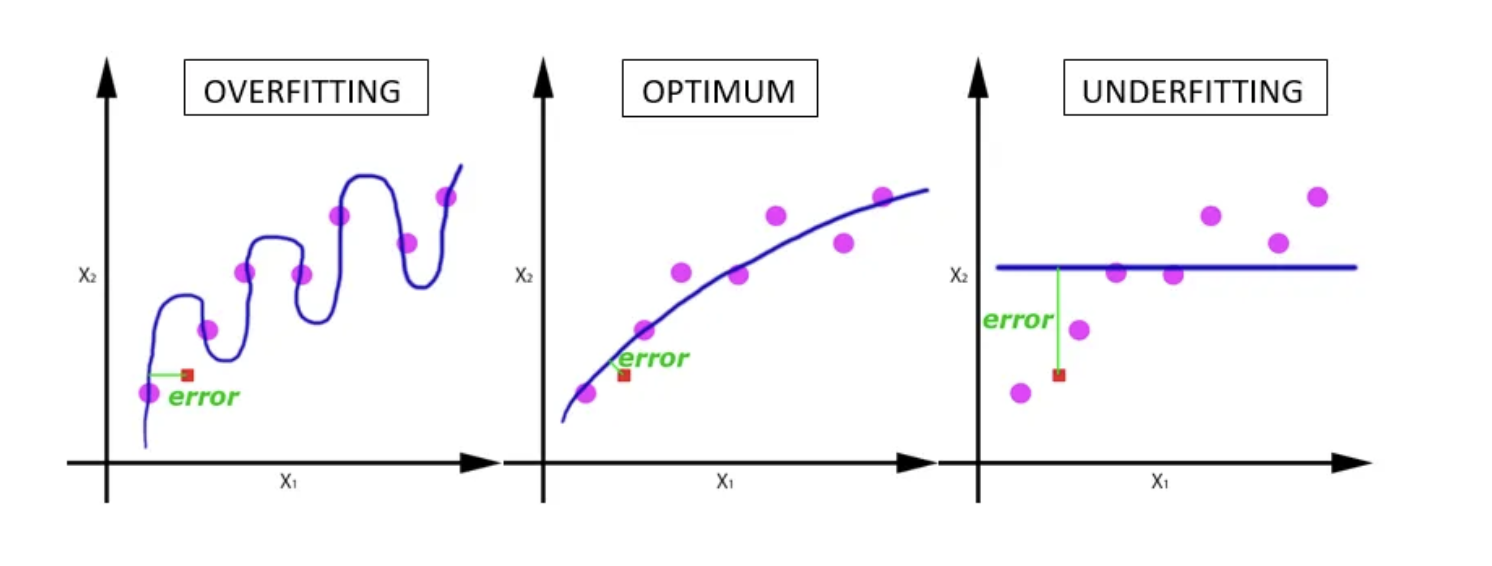

要選擇各種 ML DL 的技巧之前,先分清楚遇到的問題 + 哪些方法可以解決這個問題

- 如果 Training Error 比 Testing Error 低一截,那我們遇到的就是

Overfitting,各種類型的 regularization 或是縮小 model 都可以派上用場。 - 但是如果我們遇到的是 Training Error 跟 Human 的水平有一截差距,那變成我們是

Underfitting,反而是要加大 model 甚至是重新定義問題,找到一個更好 fit 的問題。

從能找到的最強 LLM(GPT4)開始

- 從手邊能找到的最強 LLM 開始產品

- 對於任何一個 AI 產品而言,同時要面對兩個不確定性:1. 需求的不確定,2. 技術的不確定 。

- 技術的不確定指的是: 我們沒辦法在訓練模型之前知道我們最後可以得到的 Performance 。因此很多 AI 產品投入了資源收集資料及訓練模型,最後卻發現模型遠沒有達到可接受的標準。

在 LLM 時期其實像是 GPT4 或是 Bard 這種模型,反倒提供給我們一個非常強的 Baseline,所以先使用能找到的最強模型來開始產品。

- 先用 GPT4 來做 MVP ,如果可行則確認 unit economics、尋找護城河跟盡量減低 cost。

- 分析錯誤來源

- 如果錯誤跟 factual 比較有關, 藉由跑「給定相關資訊來進行預測」的實驗測試 LLM 到底是不具備相關知識還是 Hallucination 。

- 如果錯誤跟 reasoning 比較有關,藉由 perplexity 區分 model 需要 language modeling finetuning 還是 supervised finetuning。

- 如果 finetuning 是可行的(有一定量資料、成本可接受),直接跑小範圍的 finetune 可以驗證很多事情。

如果 LLM 沒有達成標準

如果達成標準, 則思考更多商業上的問題

確認 unit economics :

- 確保每一次用戶使用服務時,你不會虧錢。

- Ex:用戶訂閱你服務一個月只要 120,但是他平均每個月會使用超過 120 元的 GPT-4 額度,這就會出現問題(除非你有更完備的商業規劃)。

找尋護城河 :

- 因為你目前是使用第三方提供的 LLM,所以你技術上不具備獨創性,請從其他方面尋找護城河。

在達成標準的前提下盡量降低 cost :

- 換小模型

- 在傳統 chatbot 中大多有一個功能是開發者提供 QA pairs,然後每次用戶問問題,就從這些 QA pairs 中找尋最佳的回答,而 GPT cache 其實就是把每次 GPT 的回答記起來,當成一個 QA pair,新問題進來時就可以先找有沒有相似的問題,減少訪問 GPT API 的次數。

- 限縮 LLM 使用場景。

如果 LLM 沒有達成標準

如果沒有達成標準,則需要思考技術上的改進策略。分析 LLM 失敗的原因。

通常來說,LLM 會失敗主流會有 4 種原因,兩種大的類別:

- Factual 事實相關

- Reasoning 推理相關

(Factual 相關)LLM 不具備這個知識 :

- 嘗試 RAG(Retrieval Augmented Generation)

- finetuning

(Factual 相關)LLM 在胡言亂語(Hallucination) :

- prompt engineering (CoT, Self Critique),

- finetuning

(Reasoning 相關)LLM 不適應這種類型語料 :

- finetuning: language modeling,

- 更換 LLM

(Reasoning 相關)LLM 無法正確推理這個問題 :

- finetuning: supervised finetuning,

- In-Context Learning

Factual 相關

- 如果 LLM 回答問題錯誤,

- 有可能是 LLM 根本不具備相關知識,導致他只能隨便回答,

- 也有可能試產生了 Hallucination(胡言亂語)的現象

而最好區分這兩者的方法,就是做以下實驗。

ICL + Retrieval Augmented Generation

- 選定 k 筆 LLM 答錯的資料

- 在 prompt 中加入能夠回答這題的相關資訊(也是你確定你未來可以取得的相關資訊),檢測是否有 明顯變好

- 如果有的話那就可以走 RAG(Retrieval Augmented Generation) 這條路

- 如果還是有一定比例的資料無法達成,那則加入像是 self critique 之類的 prompt engineering 的方法。

更直覺的思考方式:

- 你想要 LLM 完成的這個任務,會不會在網路上常常出現?

- 如果會常常出現,那高機率用 Prompt engineering 就可以,

- 如果是冷門資訊,甚至是網路上不會出現的資訊(機構內部資訊),那就一定要走 RAG。

- Ex:

- 開發銀行的客服機器人->RAG

- 開發一個每天誇獎對話機器人,高機率只要 prompr engineering,因為誇獎的用詞、知識、方法網路上出現很多次。

Reasoning 相關

- 如果 LLM 有相關知識,但是回答的時候錯誤率依舊很高,那就要考慮是不是 LLM 根本 不具備需要的推理能力 。

- 而這又分為兩種:

- LLM 對這種類型的文本不熟悉,

- LLM 對這種類型的推理、分類問題不熟悉。

- 兩者最直接的區分方法: 讓 LLM 在你對應的文本算 perplexity。

perplexity 是用來衡量「LLM 預測下一個詞的混亂程度」

如果 perplexity 高

- 代表 LLM 對這類型的文本領域(domain)根本不熟,可能是語言不熟悉,也有可能是內容領域不熟悉

- 這時候就一定要

language model finetuning,藉由unsupervised finetuning,加強 LLM 對文本領域的熟悉度。

如果 perplexity 很低,但是問題還是解決不好

- 則更需要訓練 LLM 處理特定的問題,因此則要

supervised finetuning,這就類似傳統finetune CNN,蒐集Label data,讓模型學會執行對應任務。

- 則更需要訓練 LLM 處理特定的問題,因此則要

如果是利用 GPT4 之類的 API,沒辦法取得 perplexity 的數值

- 可以從文本中找出你認為基礎的知識語句,找個 100 句,每一句拋棄後半段請 GPT4 自行接龍,再基於結果判斷 LLM 到底有沒有你這個領域的經驗。

perplexity 是高是低,其實是一個非常需要經驗的事情,所以只能當作參考指標。

- 如果一個 model 對文本的

embedding你可以取得,那可以對 embedding 去train linear classifier - 如果 non separable,則表示這個 model 無法足夠細緻的處理這類型的問題,則更需要 supervised finetuning。

- 如果一個 model 對文本的

只要 finetuning 對你而言是可以承擔的事情

- 建議對任何任務都先跑 100~1,000 筆資料、1 個 epoch 的 supervised finetuning,和 10,000 個 token 的 language modeling

- 這會更像是以前 DL 我們直接用訓練來觀測模型是否會有顯著改善。

Instruction-Tuning (指示微调)

目前最火的研究范式,性能超过包括 ICL 在内的 prompt learning

一种特别适合改进模型在多种任务上表现的策略

提出的动机:

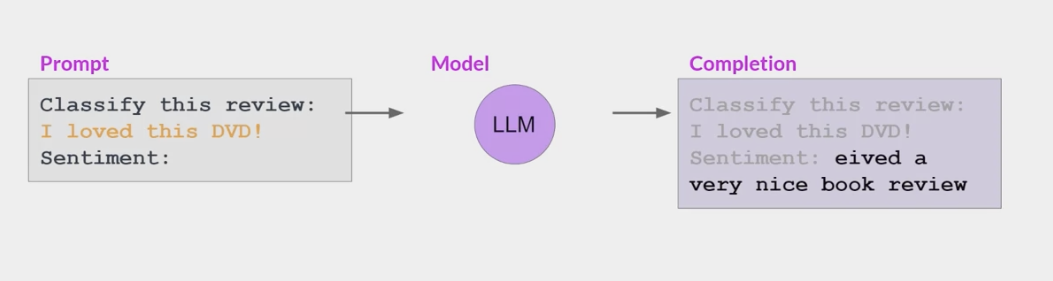

大规模的语言模型 如 GPT-3 在 zero-shot 上不那么成功, 但却可以非常好地学习 few-shot

一些模型能够识别提示中包含的指令并正确进行 zero-shot 推理,而较小的 LLM 可能在执行任务时失败,

包含一个或多个你希望模型执行的示例(称为一次或几次推理)足以帮助模型识别任务并生成良好的完成结果。

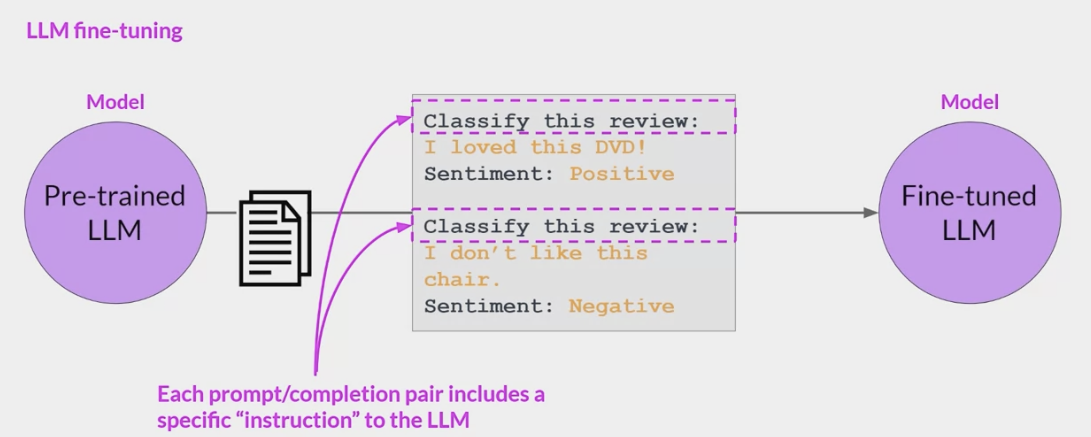

Google2021 年的 FLAN 模型《FINETUNED LANGUAGE MODELS ARE ZERO-SHOT LEARNERS》,这篇文章明确提出 Instruction-Tuning(指令微调)的技术,

本质目的:

- 将 NLP 任务转换为自然语言指令,再将其投入模型进行训练

- 通过给模型提供指令和选项的方式,使其能够提升 Zero-Shot 任务的性能表现。

作者认为一个潜在的原因是,如果在没有少量示例的 zero-shot 条件下,模型很难在 prompts 上表现很好,因为 prompts 可能和预训练数据的格式相差很大。

- 既然如此,那么为什么不直接用自然语言指令做输入呢?

通过设计 instruction,让大规模语言模型理解指令,进而完成任务目标,而不是直接依据演示实例做文本生成。

Instruction-Tuning 也是 ICL 的一种,只是 Instruction-Tuning 是将大模型在多种任务上进行微调,提升大模型的自然语言理解能力,最终实现在新任务上的 zero-shot

这些提示完成示例允许模型学习生成遵循

给定指令的响应。所有模型权重都会更新的指令微调过程称为全微调- 该过程生成了一个具有更新权重的模型的新版本

- 需要注意的是,与预训练一样,全微调需要足够的内存和计算预算来存储和处理所有梯度、优化器和其他在训练过程中被更新的组件

采用了 Instruction-Tuning 技术的大规模语言模型

- instructGPT

- Finetuned Language Net(FLAN)

Finetuned Language Net(FLAN) 的具体训练流程:

- FLAN 模型将 62 个 NLP 任务分为 12 个簇,同一个簇内是相同的任务类型

对于每个 task,将为其手动构建 10 个独特 template,作为以自然语言描述该任务的 instructions。

- 最后基于 LaMDA-PT 模型进行微调。

- LaMDA-PT 是一个包含 137B 参数的自回归语言模型,这个模型在 web 文档(包括代码) 对话数据和维基百科上进行了预训练,同时有大约 10%的数据是非英语数据。然后 FLAN 混合了所有构造的数据集在 128 核的 TPUv3 芯片上微调了 60 个小时。

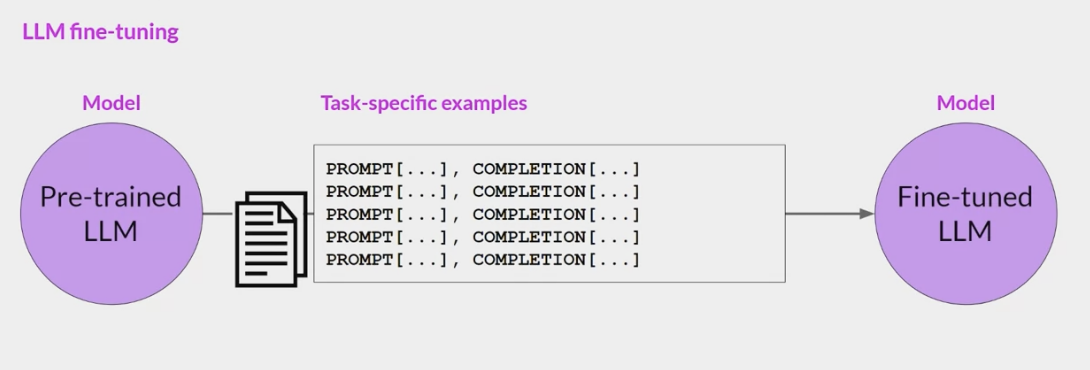

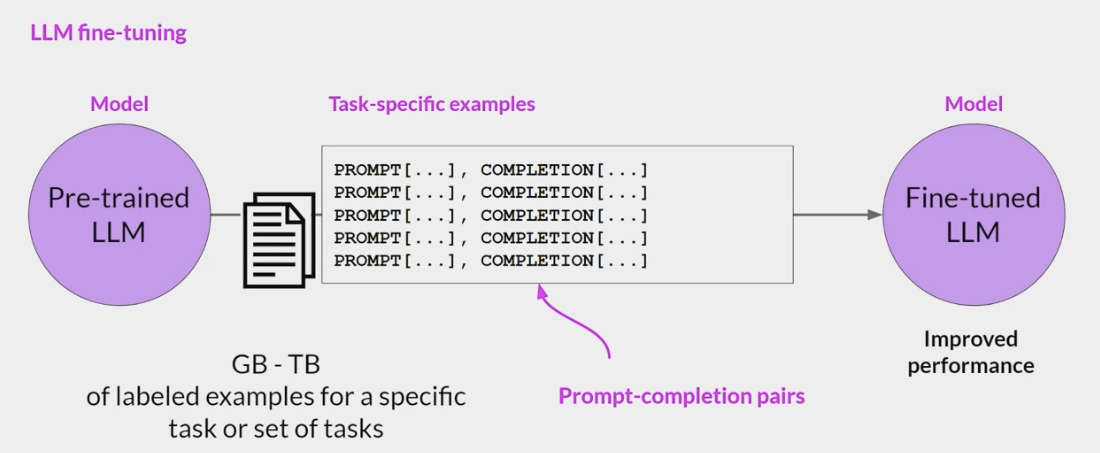

Fine-Tuning (微调)

Fine-Tuning 是一种迁移学习,在自然语言处理(NLP)中,Fine-Tuning 是用于将预训练的语言模型适应于特定任务或领域。

基本思想是采用已经在大量文本上进行训练的预训练语言模型,然后在小规模的任务特定文本上继续训练它。

Fine-Tuning 的概念已经存在很多年,并在各种背景下被使用。

- Fine-Tuning 在 NLP 中最早的已知应用是在神经机器翻译(NMT)的背景下,其中研究人员使用预训练的神经网络来初始化一个更小的网络的权重,然后对其进行了特定的翻译任务的微调。

经典的 Fine-Tuning 方法包括将预训练模型与少量特定任务数据一起继续训练。

- 在这个过程中,预训练模型的权重被更新,以更好地适应任务。

- 所需的 Fine-Tuning 量取决于预训练语料库和任务特定语料库之间的相似性。

- 如果两者相似,可能只需要少量的 Fine-Tuning,如果两者不相似,则可能需要更多的 Fine-Tuning。

Bert 模型 2018 年横空出世之后,将 Fine-Tuning 推向了新的高度。不过目前来看,Fine-Tuning 逐渐退出了 tuning 研究的舞台中心: LLM 蓬勃发展,Fine-Tuning 这种大规模更新参数的范式属实无法站稳脚跟。而更适应于 LLM 的 tuning 范式,便是接下来我们要介绍的 Prompt-Tuning Instruction-Tuning 等。

Full Fine-tuning

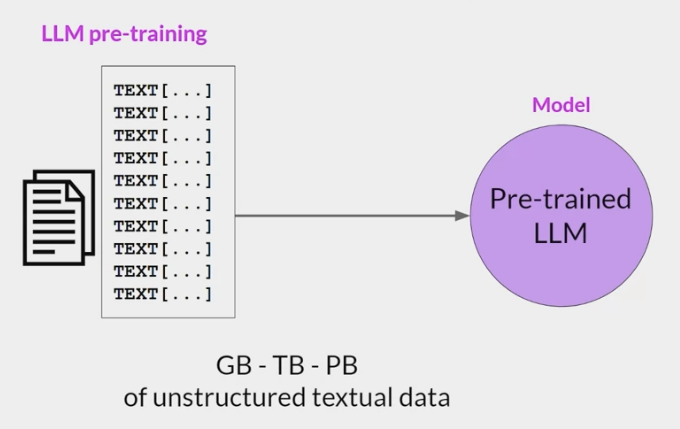

Self-supervised-learning 预训练阶段

- 从互联网上收集海量的文本数据,通过自监督的方式训练语言模型,根据上下文来预测下个词。

- token 的规模大概在 trillion 级别,这个阶段要消耗很多资源,海量的数据采集 清洗和计算,

- 该阶段的目的是:通过海量的数据,让模型接触不同的语言模式,让模型拥有理解和生成上下文连贯的自然语言的能力。

训练过程大致如下:

| name | des |

|---|---|

| Training data | 来自互联网的开放文本数据,整体质量偏低 |

| Data scale | 词汇表中的 token 数量在 trillion 级别 |

| $LLM^{SSL}_ϕ$ | 预训练模型 |

| $V$ | 词汇表的大小 |

| $[T_1,T_2,…,T_V]$ | vocabulary 词汇表,训练数据中词汇的集合 |

| $f(x)$ | 映射函数把词映射为词汇表中的索引即:token. |

| . | if $x$ is $T_k$ in vocab, $f(x) = k$ |

| $(x_1,x_2,…,x_n)$ | 根据文本序列生成训练样本数据: |

| . | Input: $x=(x_1,x_2,…,x_{i−1})$ |

| . | Output(label) : $x_i$ |

| $(x,xi)$ | 训练样本: |

| . | Let $k = f(x_i), word→token$ |

| . | Model’s output: $LLM^{SSL}(x)=[\bar{y_1},\bar{y2},…,\bar{yV}]$ |

| . | 模型预测下一个词的概率分布,Note : $∑_j \bar{y_j} = 1$ |

| . | The loss value:$CE(x,x_i;ϕ)= −log(\overline{y}_k)$ |

Goal : find $ϕ$, Minimize $CE(\phi) = -E_x log(\overline{y}_k)$

预先训练阶段 $LLM^{SSL}$ 还不能正确的响应用户的提示

- 例如,如果提示“法国的首都是什么?”这样的问题,模型可能会回答另一个问题的答案,例如,模型响应的可能是“意大利的首都是什么?”

- 因为模型可能没有“理解”/“对齐 aligned”用户的“意图”,只是复制了从训练数据中观察到的结果。

为了解决这个问题,出现了一种称为监督微调或者也叫做指令微调的方法。

- 通过在少量的示例数据集上采用监督学习的方式对 $LLM^{SSL}$ 进行微调,经过微调后的模型,可以更好地理解和响应自然语言给出的指令。

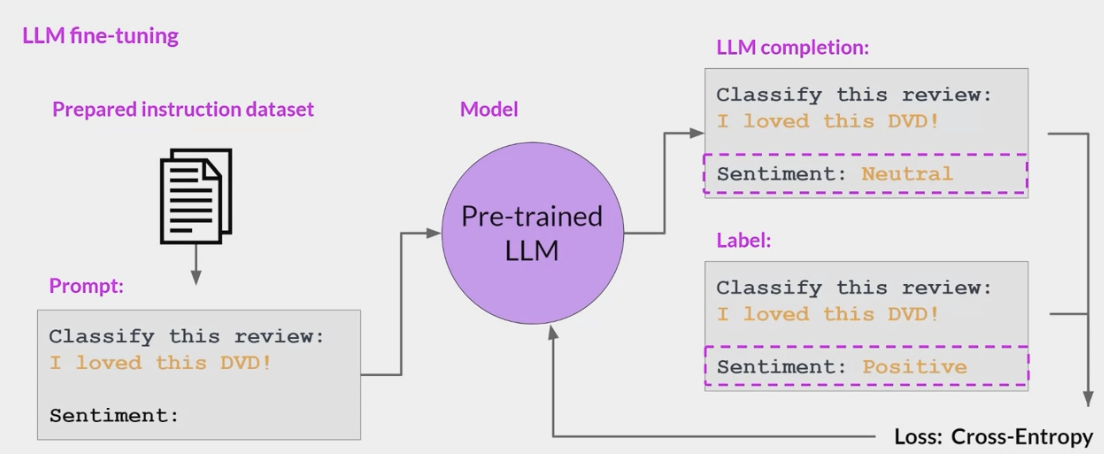

SFT - Supervised Fine-Tuning (监督微调阶段)

Overview

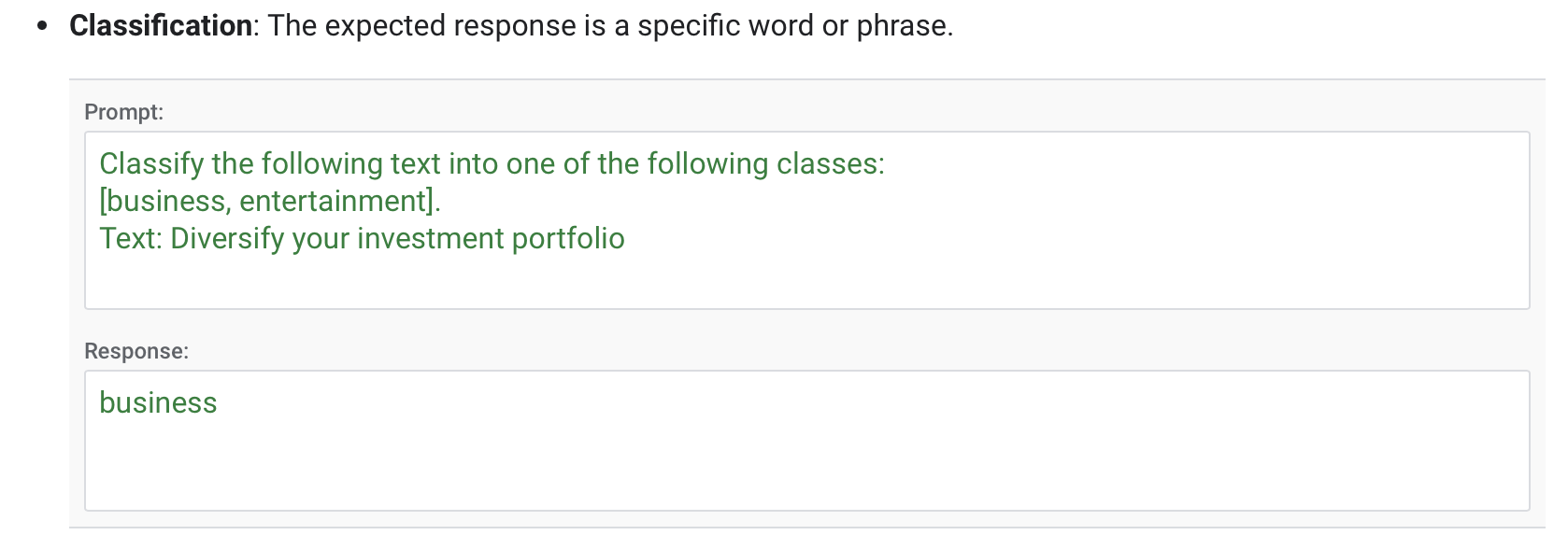

good option when you have a well-defined task with available labeled data.

particularly effective for domain-specific applications where the language or content significantly differs from the data the large model was originally trained on.

Supervised fine-tuning adapts model behavior with a labeled dataset.

- This process adjusts the model’s weights to

minimize the difference between its predictions and the actual labels.

For example, it can improve model performance for the following types of tasks:

- Classification

- Summarization

- Extractive question answering

- Chat

SFT(Supervised Fine-Tuning)阶段的目标是

优化预训练模型,使模型生成用户想要的结果。- 在该阶段,给模型展示

如何适当地响应不同的提示 (指令) (例如问答,摘要,翻译等)的示例。 - 这些示例遵循 (prompt response)的格式,称为演示数据。

- 通过基于示例数据的监督微调后,模型会模仿示例数据中的响应行为,学会问答 翻译 摘要等能力,

- OpenAI 称为:监督微调行为克隆 。

- 在该阶段,给模型展示

- 基于 LLM 指令微调的突出优势在于,对于任何特定任务的专用模型,只需要在通用大模型的基础上通过特定任务的指令数据进行微调,就可以解锁 LLM 在特定任务上的能力

- 不需要从头去构建专用的小模型。

- 事实也证明,经过微调后的小模型可以生成比没有经过微调的大模型更好的结果:

指令微调过程如下:

1

2

3

4

5

6

7

8

9

10

11

12

13

- Training Data : 高质量的微调数据,由人工产生。

- Data Scale : 10000~100000

- InstructGPT : ~14500 个人工示例数据集。

- Alpaca : 52K ChatGPT 指令数据集。

- Model input and output

- Input : 提示 (指令)。

- Output : 提示对应的答案(响应)

- Goal : 最小化交叉熵损失,只计算出现在响应中的 token 的损失。

Implementation in GCP

Recommended configurations

- The following table shows the recommended configurations for tuning a foundation model by task:

| Task | No. of examples in dataset | Number of epochs |

|---|---|---|

| Classification | 500+ | 2-4 |

| Summarization | 1000+ | 2-4 |

| Extractive QA | 500+ | 2-4 |

| Chat | 1000+ | 2-4 |

- import lib

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

import time

from typing import Dict, List

# For data handling.

import pandas as pd

# For visualization.

import plotly.graph_objects as go

# For fine tuning Gemini model.

import vertexai

# For extracting vertex experiment details.

from google.cloud import aiplatform

from google.cloud.aiplatform.metadata import context

from google.cloud.aiplatform.metadata import utils as metadata_utils

from plotly.subplots import make_subplots

# For evaluation metric computation.

from rouge_score import rouge_scorer

from tqdm import tqdm

from vertexai.generative_models import (

GenerationConfig,

GenerativeModel,

HarmBlockThreshold,

HarmCategory,

)

from vertexai.preview.tuning import sft

- setup env

1

2

3

PROJECT_ID = "the_id" # @param

LOCATION = "us-central1" # @param

vertexai.init(project=PROJECT_ID, location=LOCATION)

- Dataset

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

33

34

35

36

37

38

39

40

41

42

43

44

45

46

47

48

49

# ++++++++ Dataset Citation ++++++++

@inproceedings{

ladhak-wiki-2020,

title={WikiLingua: A New Benchmark Dataset for Multilingual Abstractive Summarization},

author={Faisal Ladhak, Esin Durmus, Claire Cardie and Kathleen McKeown},

booktitle={Findings of EMNLP, 2020},

year={2020}

}

# Dataset for model tuning.

training_data_path = "gs://github-repo/generative-ai/gemini/tuning/summarization/wikilingua/sft_train_samples.jsonl"

# Dataset for model evaluation.

validation_data_path = "gs://github-repo/generative-ai/gemini/tuning/summarization/wikilingua/sft_val_samples.jsonl"

# Dataset for model testing.

testing_data_path = "gs://github-repo/generative-ai/gemini/tuning/summarization/wikilingua/sft_test_samples.csv"

# Provide a bucket name

BUCKET_NAME = "the_bucket_id" # @param {type:"string"}

BUCKET_URI = f"gs://{BUCKET_NAME}"

# Copy the tuning and evaluation data to the bucket.

!gsutil cp $training_data_path {BUCKET_URI}/sft_train_samples.jsonl

!gsutil cp $validation_data_path {BUCKET_URI}/sft_val_samples.jsonl

# ++++++++ Test dataset ++++++++

# Load the test dataset using pandas as it's in the csv format.

test_data = pd.read_csv(testing_data_path)

test_data.head()

test_data.loc[0, "input_text"]

# Article summary stats

stats = test_data["output_text"].apply(len).describe()

stats

print(f"Total `{stats['count']}` test records")

print(f"Average length is `{stats['mean']}`")

print(f"Max is `{stats['max']}` characters")

# Get ceil value of the tokens required.

print("Considering 1 token = 4 chars")

tokens = (stats["max"] / 4).__ceil__()

print(

f"Set max_token_length = stats['max']/4 = {stats['max']/4} ~ {tokens} characters"

)

print(f"Let's keep output tokens up to `{tokens}`")

# Maximum number of tokens that can be generated in the response by the LLM.

# Experiment with this number to get optimal output.

max_output_tokens = tokens

- Test Pre-performance

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

test_doc = test_data.loc[0, "input_text"]

prompt = f"""

Article: {test_doc}

"""

generation_model = GenerativeModel("gemini-1.0-pro-002")

generation_config = GenerationConfig(

temperature=0.1,

max_output_tokens=max_output_tokens,

)

response = generation_model.generate_content(

contents=prompt,

generation_config=generation_config

).text

print(response)

# Ground truth

test_data.loc[0, "output_text"]

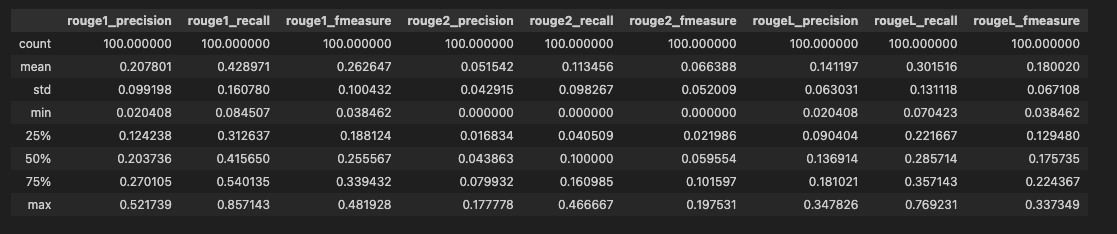

- Evaluation before tuning

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

33

34

35

36

37

38

39

40

41

42

43

44

45

46

47

48

49

50

51

52

53

54

55

56

57

58

59

60

61

62

63

64

65

66

67

68

69

70

71

72

73

74

75

76

77

78

79

80

81

82

83

84

85

86

87

88

89

90

91

92

# Convert the pandas dataframe to records (list of dictionaries).

corpus = test_data.to_dict(orient="records")

# Check number of records.

len(corpus)

# Create rouge_scorer object for evaluation

scorer = rouge_scorer.RougeScorer(

["rouge1", "rouge2", "rougeL"],

use_stemmer=True

)

def run_evaluation(model: GenerativeModel, corpus: List[Dict]) -> pd.DataFrame:

"""Runs evaluation for the given model and data.

Args:

model: The generation model.

corpus: The test data.

Returns:

A pandas DataFrame containing the evaluation results.

"""

records = []

for item in tqdm(corpus):

document = item.get("input_text")

summary = item.get("output_text")

# Catch any exception that occur during model evaluation.

try:

response = model.generate_content(

document,

generation_config=generation_config,

safety_settings={

HarmCategory.HARM_CATEGORY_HARASSMENT: HarmBlockThreshold.BLOCK_NONE,

HarmCategory.HARM_CATEGORY_HATE_SPEECH: HarmBlockThreshold.BLOCK_NONE,

HarmCategory.HARM_CATEGORY_SEXUALLY_EXPLICIT: HarmBlockThreshold.BLOCK_NONE,

HarmCategory.HARM_CATEGORY_DANGEROUS_CONTENT: HarmBlockThreshold.BLOCK_NONE,

},

)

# Check if response is generated by the model, if response is empty then continue to next item.

if not (

response

and response.candidates

and response.candidates[0].content.parts

):

print(

f"Model has blocked the response for the document.\n Response: {response}\n Document: {document}"

)

continue

# Calculates the ROUGE score for a given reference and generated summary.

scores = scorer.score(target=summary, prediction=response.text)

# Append the results to the records list

records.append(

{

"document": document,

"summary": summary,

"generated_summary": response.text,

"scores": scores,

"rouge1_precision": scores.get("rouge1").precision,

"rouge1_recall": scores.get("rouge1").recall,

"rouge1_fmeasure": scores.get("rouge1").fmeasure,

"rouge2_precision": scores.get("rouge2").precision,

"rouge2_recall": scores.get("rouge2").recall,

"rouge2_fmeasure": scores.get("rouge2").fmeasure,

"rougeL_precision": scores.get("rougeL").precision,

"rougeL_recall": scores.get("rougeL").recall,

"rougeL_fmeasure": scores.get("rougeL").fmeasure,

}

)

except AttributeError as attr_err:

print("Attribute Error:", attr_err)

continue

except Exception as err:

print("Error:", err)

continue

return pd.DataFrame(records)

# Batch of test data.

corpus_batch = corpus[:100]

# Run evaluation using loaded model and test data corpus

evaluation_df = run_evaluation(generation_model, corpus_batch)

evaluation_df.head()

# Statistics of the evaluation dataframe.

evaluation_df_stats = evaluation_df.dropna().describe()

evaluation_df_stats

print("Mean rougeL_precision is", evaluation_df_stats.rougeL_precision["mean"])

| count | document | summary | generated_summary | scores | rouge1_precision | rouge1_recall | rouge1_fmeasure | rouge2_precision | rouge2_recall | rouge2_fmeasure | rougeL_precision | rougeL_recall | rougeL_fmeasure |

|---|---|---|---|---|---|---|---|---|---|---|---|---|---|

| 0 | Hold the arm out flat in front of you with yo… | Squeeze a line of lotion onto the tops of both… | This article provides instructions on how to a… | {‘rouge1’: (0.29508196721311475, 0.58064516129… | 0.295082 | 0.580645 | 0.391304 | 0.133333 | 0.266667 | 0.177778 | 0.213115 | 0.419355 | 0.282609 |

| 1 | As you continue playing, surviving becomes pai… | Make a Crock Pot for better food. Create an Al… | This article provides a guide on how to surviv… | {‘rouge1’: (0.14814814814814814, 0.66666666666… | 0.148148 | 0.666667 | 0.242424 | 0.062500 | 0.294118 | 0.103093 | 0.123457 | 0.555556 | 0.202020 |

Fine-tune the Model

source_model: Specifies the base model version you want to fine-tune.train_dataset: Path to the training data in JSONL format.- Optional parameters

validation_dataset: If provided, this data is used to evaluate the model during tuning.epochs: The number of training epochs to run.learning_rate_multiplier: A value to scale the learning rate during training.

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

# Tune a model using `train` method.

sft_tuning_job = sft.train(

source_model="gemini-1.0-pro-002",

train_dataset=f"{BUCKET_URI}/sft_train_samples.jsonl",

# Optional:

validation_dataset=f"{BUCKET_URI}/sft_val_samples.jsonl",

epochs=3,

learning_rate_multiplier=1,

)

# Get the tuning job info.

sft_tuning_job.to_dict()

# Get the resource name of the tuning job

sft_tuning_job_name = sft_tuning_job.resource_name

sft_tuning_job_name

%%time

# Wait for job completion

while not sft_tuning_job.refresh().has_ended:

time.sleep(60)

# tuned model name

tuned_model_name = sft_tuning_job.tuned_model_name

tuned_model_name

# tuned model endpoint name

tuned_model_endpoint_name = sft_tuning_job.tuned_model_endpoint_name

tuned_model_endpoint_name

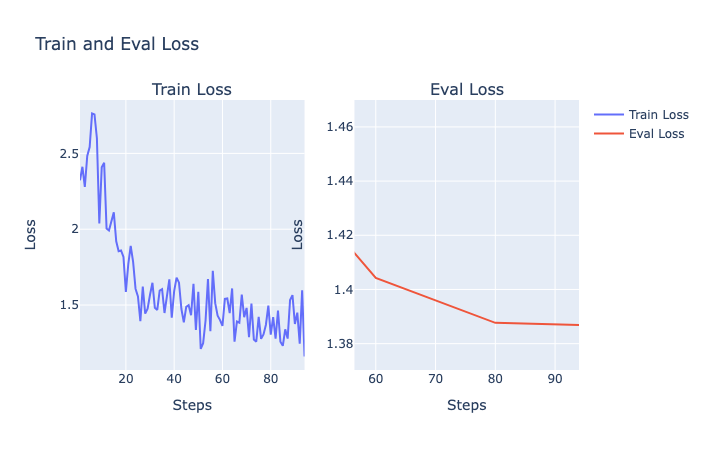

- Tuning and evaluation metrics

Model tuning metrics

/train_total_loss: Loss for the tuning dataset at a training step./train_fraction_of_correct_next_step_preds:- The token accuracy at a training step.

- A single prediction consists of a sequence of tokens.

- This metric measures the accuracy of the predicted tokens when compared to the ground truth in the tuning dataset.

/train_num_predictions: Number of predicted tokens at a training step

Model evaluation metrics:

/eval_total_loss: Loss for the evaluation dataset at an evaluation step./eval_fraction_of_correct_next_step_preds:- The token accuracy at an evaluation step.

- A single prediction consists of a sequence of tokens.

- This metric measures the accuracy of the predicted tokens when compared to the ground truth in the evaluation dataset.

/eval_num_predictions: Number of predicted tokens at an evaluation step.

The metrics visualizations are available after the model tuning job completes. If you don’t specify a validation dataset when you create the tuning job, only the visualizations for the tuning metrics are available.

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

# Get resource name from tuning job.

experiment_name = sft_tuning_job.experiment.resource_name

# Locate Vertex Experiment and Vertex Experiment Run

experiment = aiplatform.Experiment(experiment_name=experiment_name)

filter_str = metadata_utils._make_filter_string(

schema_title="system.ExperimentRun",

parent_contexts=[experiment.resource_name],

)

experiment_run = context.Context.list(filter_str)[0]

# Read data from Tensorboard

tensorboard_run_name = f"{experiment.get_backing_tensorboard_resource().resource_name}/experiments/{experiment.name}/runs/{experiment_run.name}"

tensorboard_run = aiplatform.TensorboardRun(tensorboard_run_name)

metrics = tensorboard_run.read_time_series_data()

- Plot the metrics

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

33

34

35

36

37

38

39

40

41

42

43

44

45

46

47

48

49

50

51

52

def get_metrics(metric: str = "/train_total_loss"):

"""

Get metrics from Tensorboard.

Args:

metric: metric name, eg. /train_total_loss or /eval_total_loss.

Returns:

steps: list of steps.

steps_loss: list of loss values.

"""

loss_values = metrics[metric].values

steps_loss = []

steps = []

for loss in loss_values:

steps_loss.append(loss.scalar.value)

steps.append(loss.step)

return steps, steps_loss

# Get Train and Eval Loss

train_loss = get_metrics(metric="/train_total_loss")

eval_loss = get_metrics(metric="/eval_total_loss")

# Plot the train and eval loss metrics using Plotly python library

fig = make_subplots(

rows=1, cols=2,

shared_xaxes=True,

subplot_titles=("Train Loss", "Eval Loss")

)

# Add traces

fig.add_trace(

go.Scatter(

x=train_loss[0], y=train_loss[1],

name="Train Loss", mode="lines"),

row=1, col=1,

)

fig.add_trace(

go.Scatter(

x=eval_loss[0], y=eval_loss[1],

name="Eval Loss", mode="lines"),

row=1, col=2,

)

# Add figure title

fig.update_layout(title="Train and Eval Loss", xaxis_title="Steps", yaxis_title="Loss")

# Set x-axis title

# Set y-axes titles

fig.update_xaxes(title_text="Steps")

fig.update_yaxes(title_text="Loss")

# Show plot

fig.show()

- Load the Tuned Model

1

2

3

4

5

6

7

8

if sft_tuning_job.has_succeeded:

tuned_genai_model = GenerativeModel(tuned_model_endpoint_name)

# Test with the loaded model.

print("***Testing***")

print(tuned_genai_model.generate_content(contents=prompt))

else:

print("State:", sft_tuning_job.state)

print("Error:", sft_tuning_job.error)

We can clearly see the difference between summary generated pre and post tuning, as tuned summary is more inline with the ground truth format (Note: Pre and Post outputs, might vary based on the set parameters.)

- Pre:

This article provides instructions on how to apply lotion to the back using the forearms. The method involves squeezing a line of lotion onto the forearms, bending the elbows, and reaching behind the back to rub the lotion on. The article also notes that this method may not be suitable for people with shoulder pain or limited flexibility. - Post:

Dispense a line of lotion onto the forearms. Place the forearms behind you. Rub the forearms up and down the back. - Ground Truth:

Squeeze a line of lotion onto the tops of both forearms and the backs of the hands. Place the arms behind the back. Move the arms in a windshield wiper motion.

- Pre:

- Evaluation post model tuning

1

2

3

4

5

6

# Run evaluation using loaded model and test data corpus

evaluation_df = run_evaluation(generation_model, corpus_batch)

evaluation_df.head()

# Statistics of the evaluation dataframe.

evaluation_df_stats = evaluation_df.dropna().describe()

evaluation_df_stats

1

2

3

4

5

6

7

# run evaluation

evaluation_df_post_tuning = run_evaluation(tuned_genai_model, corpus_batch)

evaluation_df_post_tuning.head()

# Statistics of the evaluation dataframe post model tuning.

evaluation_df_post_tuning_stats = evaluation_df_post_tuning.dropna().describe()

evaluation_df_post_tuning_stats

1

2

3

4

5

6

7

8

9

10

11

print(

"Mean rougeL_precision is",

evaluation_df_stats.rougeL_precision["mean"]

)

# Mean rougeL_precision is 0.14326482896213358

print(

"Mean rougeL_precision is",

evaluation_df_post_tuning_stats.rougeL_precision["mean"]

)

# Mean rougeL_precision is 0.42774974724224635

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

improvement = round(

(

(

evaluation_df_post_tuning_stats.rougeL_precision["mean"]

- evaluation_df_stats.rougeL_precision["mean"]

)

/ evaluation_df_stats.rougeL_precision["mean"]

)

* 100,

2,

)

print(

f"Model tuning has improved the rougeL_precision by {improvement}% (result might differ based on each tuning iteration)"

)

# Model tuning has improved the rougeL_precision by 198.57% (result might differ based on each tuning iteration)

Prompt-Oriented Fine-Tuning

需要更新全部参数(包括预训练模型参数)的 Prompt-Tuning 方法。

- 训练方法的本质是

将目标任务转换为适应预训练模型的预训练任务,以适应预训练模型的学习体系。

例如我们在 Bert 模型上做情感分类任务,

正常的 Fine-Tuning 流程,是将

训练文本经过 Bert 编码后,生成向量表征,再利用该向量表征,连接全连接层,实现最终的情感类别识别。- 这种方式存在一个显式的弊端:

预训练任务与下游任务存在gap

- 这种方式存在一个显式的弊端:

Bert 的预训练任务包括两个:

MLM与NSP(具体可参考Bert 预训练的任务 MLM 和 NSP)

MLM任务是通过分类模型识别被MASK掉的词,类别大小即为整个词表大小;NSP任务是预测两个句子之间的关系;

Prompt-Oriented Fine-Tuning 训练方法,是将情感分类任务转换为类似于

MLM任务的[Mask]预测任务:- 构建如下的 prompt 文本:

prompt = It was [MASK]. - 将 prompt 文本与输入 text 文本

text = The film is attractive.进行拼接生成It was [MASK].The film is attractive. - 输入至预训练模型中,训练任务目标和

MLM任务的目标一致,即识别被[Mask]掉的词。

- 构建如下的 prompt 文本:

通过这种方式,可以将下游任务转换为和预训练任务较为一致的任务,已有实验证明,Prompt-Oriented Fine-Tuning 相对于常规的 Fine-Tuning,效果确实会得到提升(Prompt 进行情感分类)。

- 通过以上描述我们可以知道,Prompt-Oriented Fine-Tuning 方法中,预训练模型参数是可变的。

- 其实将 Prompt-Oriented Fine-Tuning 方法放在 Prompt-Tuning 这个部分合理也不合理,因为它其实是

Prompt-Tuning+Fine-Tuning的结合体,将它视为 Fine-Tuning 的升级版是最合适的。 Prompt-Oriented Fine-Tuning 方法在 Bert 类相对较小的模型上表现较好,但是随着模型越来越大,如果每次针对下游任务,都需要更新预训练模型的参数,资源成本及时间成本都会很高,因此后续陆续提出了不更新预训练模型参数,单纯只针对 prompt 进行调优的方法,例如Hard Prompt和Soft Prompt。

- 这里再给出一些常见下游任务的 prompt 设计:

Not Full fine-tuning

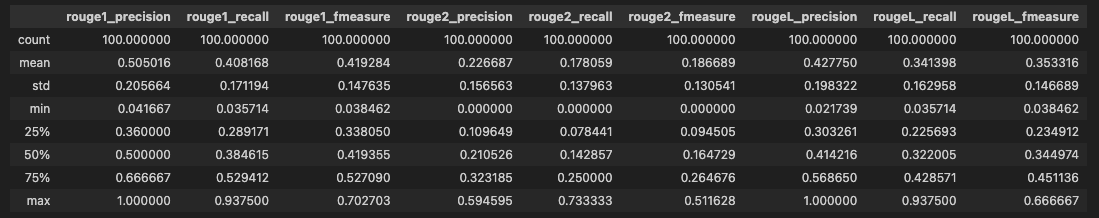

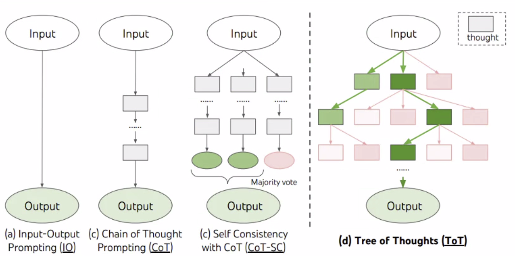

XXX-of-Thoughts

CoT (Chain of Thoughts) approach

- LLMs tend to progress linearly in their thinking towards problem solving, and if an error occurs along the way, they tend to proceed along that erroneous criterion.

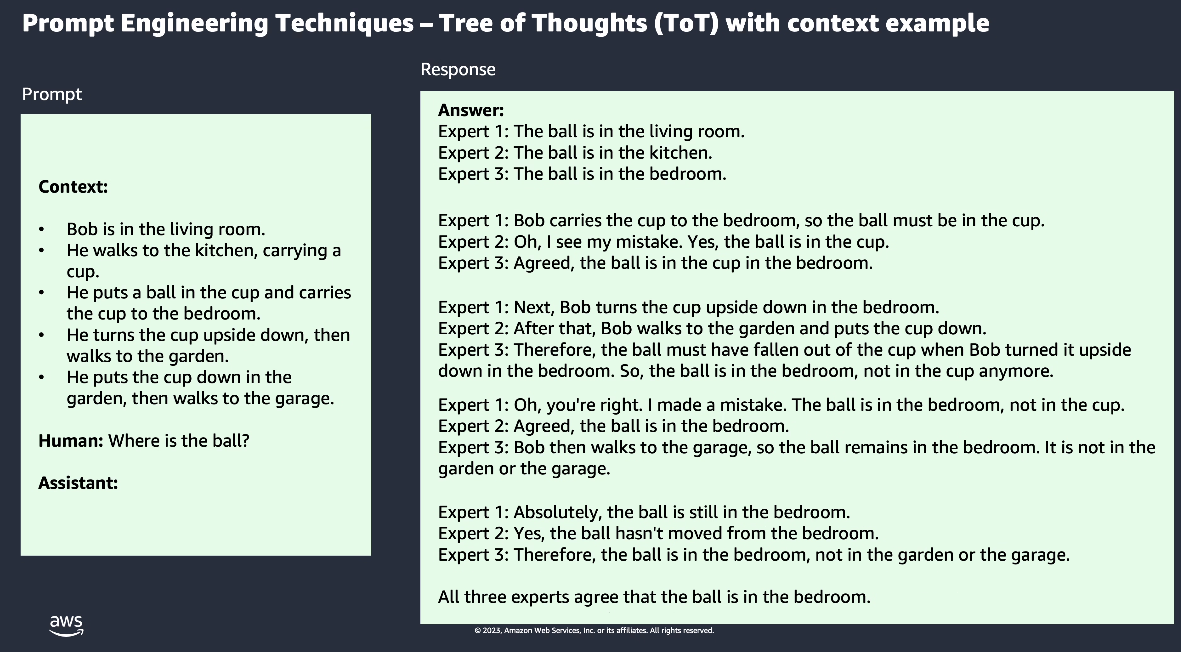

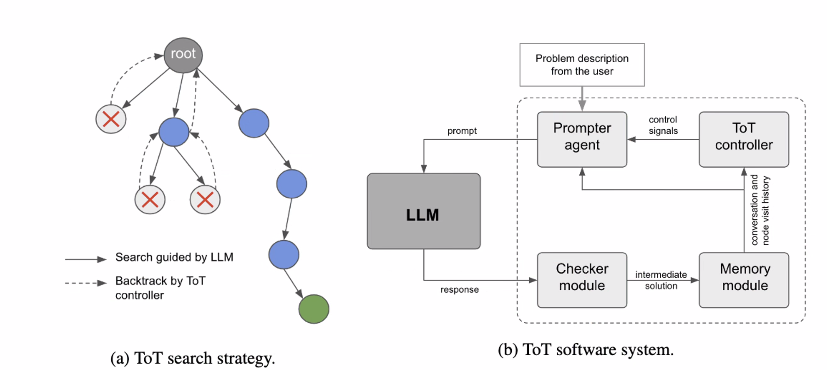

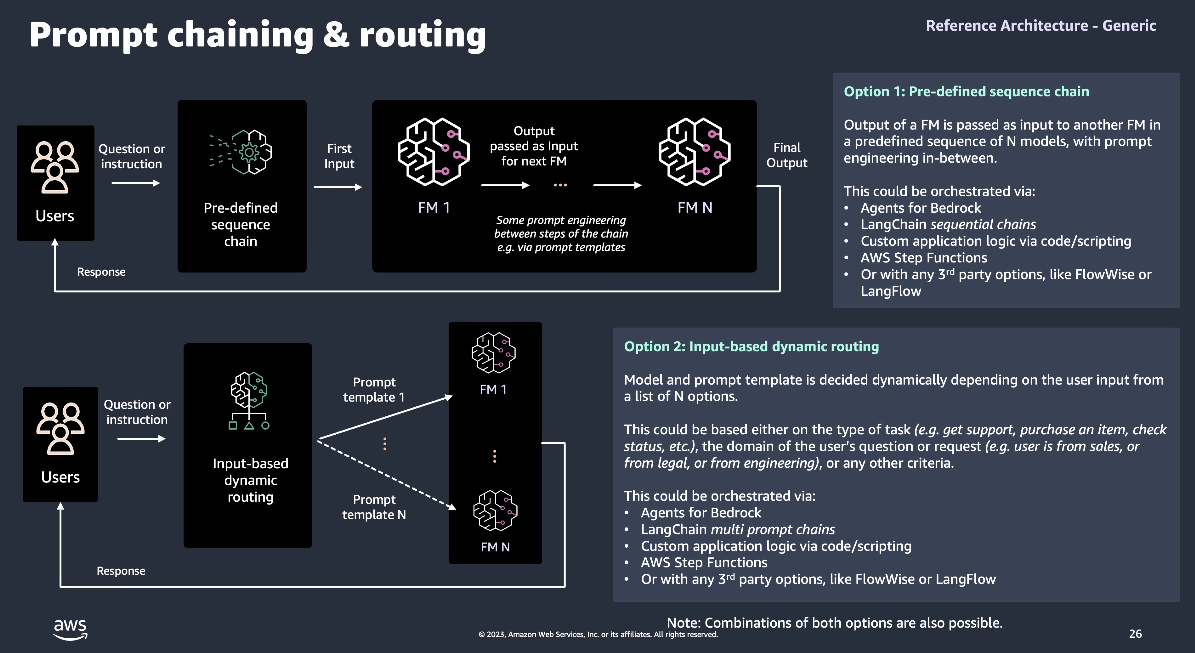

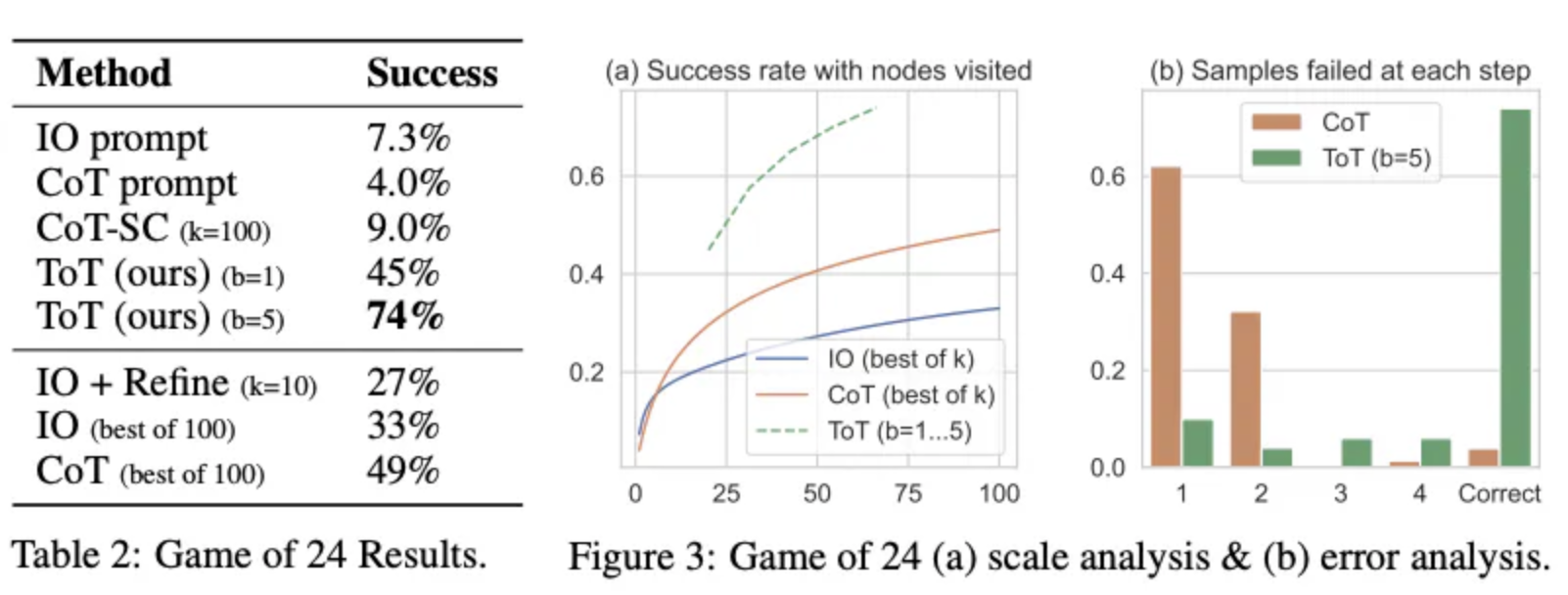

ToT (Tree of Thoughts) approach

- LLMs evaluate themselves at each stage of thought and stop inefficient approaches early, switching to alternative methods.

Chain-of-Thought(思维链)

随着 LLM 的越来越大,以及 tuning 技术的快速发展,LLM 在包括情感分析在内的传统自然语言任务上表现越来越好,但是单纯的扩大 LLM 模型的参数量无法让模型在算术推理/常识推理/符号推理等推理任务上取得理想的效果。 如何提升 LLM 在这些推理任务上性能呢?在此前关于 LLM 的推理任务中,有两种方法:

- 针对下游任务对模型进行微调;

- 为模型提供少量的输入输出样例进行学习。

但是这两种方法都有着局限性,前者微调计算成本太高,后者采用传统的输入输出样例在推理任务上效果很差,而且不会随着语言模型规模的增加而有实质性的改善。此时,Chain-of-Thought 应运而生。下面我们根据三篇比较有代表性的论文,详细介绍 CoT 的发展历程。

Manual-CoT(人工思维链)

Manual-CoT 是 Chain-of-Thought 技术的开山之作,由 Google 在 2022 年初提出《Chain-of-Thought Prompting Elicits Reasoning in Large Language Models》。其旨在进一步提高超大规模模型在一些复杂任务上的推理能力。其认为现有的超大规模语言模型可能存在下面潜在的问题:

- 增大模型参数规模对于一些具有挑战的任务(例如算术 常识推理和符号推理)的效果并未证明有效;

- 期望探索如何对大模型进行推理的简单方法。

针对这些问题,作者提出了 chain of thought (CoT)这种方法来利用大语言模型求解推理任务。

下面这个例子可以很好的说明思维链到底在做什么。左图是传统的 one-shot prompting,就是拼接一个例子在 query 的前面。右图则是 CoT 的改进,就是将 example 中的 Answer 部分的一系列的推理步骤(人工构建)写出来后,再给出最终答案。逻辑就是希望模型学会一步一步的输出推理步骤,然后给出结果。

论文中首先在算数推理(arithmetic reasoning)领域做了实验,使用了 5 个数学算术推理数据集: GSM8K / SVAMP / ASDiv / AQuA / MAWPS,具体的实验过程这里不再赘述,感兴趣的同学可以直接参考论文,这里直接给出实验结论(如下图):

- CoT 对小模型作用不大: 模型参数至少达到 10B 才有效果,达到 100B 效果才明显。并且作者发现,在较小规模的模型中产生了流畅但不符合逻辑的 CoT,导致了比 Standard prompt 更低的表现;

- CoT 对复杂的问题的性能增益更大: 例如,对于 GSM8K(baseline 性能最低的数据集),最大的 GPT (175B GPT)和 PaLM (540B PaLM)模型的性能提高了一倍以上。而对于 SingleOp(MAWPS 中最简单的子集,只需要一个步骤就可以解决),性能的提高要么是负数,要么是非常小;

- CoT 超越 SOTA: 在 175B 的 GPT 和 540B 的 PaLM 模型下,CoT 在部分数据集上超越了之前的 SOTA(之前的 SOTA 采用的是在特定任务下对模型进行微调的模式)。

除此之外,论文中为了证明 CoT 的有效性,相继做了消融实验(Ablation Study) 鲁棒性实验( Robustness of Chain of Thought) 常识推理(Commonsense Reasoning)实验 符号推理(Symbolic Reasoning)实验,下面分别做以简单介绍:

消融实验: 通过研究移除某个组件之后的性能,证明该组件的有效性。

论文中通过引入 CoT 的三个变种,证明 CoT 的有效性

结果如下图所示:

Equation only: 把 CoT 中的文字去掉,只保留公式部分。结论: 效果对于原始 prompt 略有提升,对简单任务提升较多,但和 CoT 没法比,特别是对于复杂任务,几乎没有提升。

Variable compute only: 把 CoT 中的 token 全换成点(…)。 这是为了验证额外的计算量是否是影响模型性能的因素。结论: 全换成点(…)后效果和原始 prompt 没什么区别,这说明计算量用的多了对结果影响很小(几乎没有影响),也说明了人工构建的 CoT(token sequence)对结果影响很大。

Chain of thought after answer: 把思维链放到生成结果之后。 这样做的原因是: 猜测 CoT 奏效的原因可能仅仅是这些 CoT 简单的让模型更好的访问了预训练期间获得的相关知识,而与推理没啥太大关系。结论: CoT 放到生成的答案之后的效果和 benchmark 没太大区别,说明 CoT 的顺序逻辑推理还是起到了很大作用的(不仅仅是激活知识),换句话说,模型确实是依赖于生成的思维链一步一步得到的最终结果。

鲁棒性实验: 论文中通过 annotators(标注者),exemplars(样例选择)和 models(模型)三个方面对 CoT 进行了鲁棒性分析。如下图所示,总体结论是思维链普遍有效,但是不同的 CoT 构建方式/exemplars 的选择/exemplars 的数量/exemplars 的顺序,在一定程度上影响着 CoT 的效果。

- 不同人构建 CoT: 尽管每个人构建的 CoT 都不相同,但都对模型性能产生了正面的影响,说明 CoT 确实有效。但是另一方面,不同人给出的不同的 CoT 对最终结果的影响程度还是有很大不同的,说明如何更好的构建 CoT 是一个研究方向;

- Exemplars 样本的选择: 不同的选择都会有提升,但是差异明显。特别是,在一个数据集上选择的 exemplars 可以用在其他数据集上,比如论文中的实验设置,对于同一种类型的问题,如算术推理,尽管在多个不同的数据集进行实验,但使用的是 8 个相同的 exemplars,结果没有特别大的差异,说明 exemplars 不需要满足和 test set 有相同的分布;

- Exemplars 样本的顺序: 整体影响不大,除了 coin flip task,可能的原因是: 同一个类别的多个 exemplars 连续输入模型使其输出产生了偏差(bias),例如把 4 个负样本放到 4 个正样本的后面输入到模型中,可能导致模型更加倾向于输出负 label;

- Exemplars 样本的数量: 对于标准 prompt,增加 exemplars 的数量对最终结果的影响不大。对于 CoT,增加 exemplars 对模型有影响(在某些数据集上),同时也不是越大越好;

- 不同 LLM 上的效果: 对于一个 LLM 效果好的 CoT exemplars set 换到其他 LLM 上效果不一定好,也就是说 CoT 对模型的提升是无法在不同的 LLM 上传递的,这是一个局限。

关于鲁棒性实验,论文中最后指出: Prompt Engineering仍然很重要,不同的 prompt(CoT)的设计/数量/顺序都会对模型产生不同的影响,且方差还是很大的。 因此未来的一个方向可能是探索一种能够获取稳健 CoT(Prompts)的范式。 或许可以用一个 LLM 自动生成 CoT 用于 Prompting,后面我们将介绍这种技术: Auto-CoT。

常识推理实验 & 符号推理实验: 此处我们不做过多介绍,这里给出三种推理模式的 exemplars 示例(绿色: 算数推理,橙色: 常识推理,蓝色: 符号推理),供大家参考:

这篇 CoT 开山之作首次提出思维链(CoT)的概念,思维链简单的说就是一系列中间推理步骤。这篇论文最大的贡献就是发现了在 LLM 生成推理任务的结果之前,先生成思维链,会使模型的推理性能有大幅度的提升,特别是在复杂的推理任务上,但是有个前提就是 LLM 的规模要大于 10B,否则 CoT 没用甚至起副作用。CoT 的一大好处是无需微调模型参数,仅仅是改变输入就可以改进模型的性能。随着 LLM 越来越大,高校和小企业可能无法承担训练 LLM 的成本,因此无法参与其中进行科研与实践,但 CoT 这个研究方向仍然可以做。对于 CoT 的更多细节,大家可参考《Chain-of-Thought Prompting Elicits Reasoning in Large Language Models》和思维链(Chain-of-Thought, CoT)的开山之作

Zero-shot-CoT(零示例思维链)

2022 年 6 月东京大学和谷歌共同发表了一篇论文《Large Language Models are Zero-Shot Reasoners》,这是一篇关于预训练大型语言模型(Pretrained Large Language Models, LLMs)推理能力的探究论文。

目前,LLMs 被广泛运用在很多 NLP 任务上。同时,在提供了特定任务的示例之后,LLMs 是一个非常优秀的学习者。

随着思考链的提示方式(chain of thought prompting, CoT)被提出,对 LLMs 推理能力的探究上升到一个新的高度,这种提示方式可以引导模型通过示例中一步一步的推理方式,去解决复杂的多步推理,在数学推理(arithmetic reasoning)和符号推理(symbolic reasoning)中取得了 SOTA 的成果。

作者在研究中发现,对拥有 175B 参数的 GPT-3,通过简单的添加”Let’s think step by step“,可以提升模型的 zero-shot 能力。

Zero-shot-CoT 的具体格式如下图所示,需要注意一点的是,同等条件下,Zero-shot-CoT 的性能是不及 Manual-CoT 的。

Auto-CoT(自动思维链)

传统 CoT 的一个未来研究方向: 可以用一个 LLM 自动生成 CoT 用于 Prompting

- 李沐老师团队在 2022 年 10 月发表的论文《AUTOMATIC CHAIN OF THOUGHT PROMPTING IN LARGE LANGUAGE MODELS》证明了这一技术方向的有效性,称为Auto-CoT。

目前较为流行的 CoT 方法有两种,一种是 Manual-CoT,一种是 Zero-shot-CoT,两种方式的输入格式如下图所示。

- Manual-CoT 的性能是要优于 Zero-shot-CoT 的,关键原因在于 Manual-CoT 包含一些人工设计的问题 推理步骤及答案,但是这部分要花费一定的人工成本

- 通过多样性选取有代表性的问题;

- 对于每一个采样的问题拼接上“Let’s think step by step”(类似于 Zero-shot-CoT )输入到语言模型,让语言模型生成中间推理步骤和答案,然后把这些所有采样的问题以及语言模型生成的中间推理步骤和答案全部拼接在一起,构成少样本学习的样例,最后再拼接上需要求解的问题一起输入到语言模型中进行续写,最终模型续写出了中间的推理步骤以及答案。

Auto-CoT 是 Manual-CoT 和 Zero-shot-CoT 的结合体

Tree-of-Thought (ToT)

an algorithm that combines Large Language Models (LLMs) and heuristic search, as presented in this paper by Princeton University and Google DeepMind.

It appears that this algorithm is being implemented into Gemini, a multimodal generative AI that is currently under development by Google.

Image Source: Yao et el. (2023)

Implementation

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

33

34

35

36

37

38

39

40

41

42

43

44

45

46

47

48

49

50

51

52

53

54

55

56

57

58

59

60

61

62

63

64

65

66

67

68

69

70

71

72

73

74

75

76

77

78

79

80

81

82

83

84

85

86

87

88

89

90

91

92

93

94

95

from langchain.chains import LLMChain

from langchain.llms import OpenAI

from langchain.prompts import PromptTemplate

from langchain.chat_models import ChatOpenAI

template ="""

Step1 :

I have a problem related to {input}. Could you brainstorm three distinct solutions? Please consider a variety of factors such as {perfect_factors}

A:

"""

prompt = PromptTemplate(

input_variables=["input","perfect_factors"],

template = template

)

chain1 = LLMChain(

llm=ChatOpenAI(temperature=0, model="gpt-4"),

prompt=prompt,

output_key="solutions"

)

template ="""

Step 2:

For each of the three proposed solutions, evaluate their potential. Consider their pros and cons, initial effort needed, implementation difficulty, potential challenges, and the expected outcomes. Assign a probability of success and a confidence level to each option based on these factors

{solutions}

A:"""

prompt = PromptTemplate(

input_variables=["solutions"],

template = template

)

chain2 = LLMChain(

llm=ChatOpenAI(temperature=0, model="gpt-4"),

prompt=prompt,

output_key="review"

)

template ="""

Step 3:

For each solution, deepen the thought process. Generate potential scenarios, strategies for implementation, any necessary partnerships or resources, and how potential obstacles might be overcome. Also, consider any potential unexpected outcomes and how they might be handled.

{review}

A:"""

prompt = PromptTemplate(

input_variables=["review"],

template = template

)

chain3 = LLMChain(

llm=ChatOpenAI(temperature=0, model="gpt-4"),

prompt=prompt,

output_key="deepen_thought_process"

)

template ="""

Step 4:

Based on the evaluations and scenarios, rank the solutions in order of promise. Provide a justification for each ranking and offer any final thoughts or considerations for each solution

{deepen_thought_process}

A:"""

prompt = PromptTemplate(

input_variables=["deepen_thought_process"],

template = template

)

chain4 = LLMChain(

llm=ChatOpenAI(temperature=0, model="gpt-4"),

prompt=prompt,

output_key="ranked_solutions"

)

# We connect the four chains using ‘SequentialChain’. The output of one chain becomes the input to the next chain.

from langchain.chains import SequentialChain

overall_chain = SequentialChain(

chains=[chain1, chain2, chain3, chain4],

input_variables=["input", "perfect_factors"],

output_variables=["ranked_solutions"],

verbose=True

)

print(overall_chain({"input":"human colonization of Mars", "perfect_factors":"The distance between Earth and Mars is very large, making regular resupply difficult"}))

Output:

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

33

34

35

36

37

38

39

40

41

42

43

44

45

{

"input": "human colonization of Mars",

"perfect_factors": "The distance between Earth and Mars is very large, making regular resupply difficult",

"ranked_solutions": {

"Ranking_1": {

"Justification": "Using In-Situ Resource Utilization is the most promising solution due to its potential to provide the necessary resources for a Mars colony and reduce the need for resupply missions from Earth. The medium initial effort, implementation difficulty, and potential challenges are outweighed by the high probability of success and 70% confidence level.",

"In_Situ_Resource_Utilization_ISRU": {

"Pros": "This solution could provide the necessary resources for a Mars colony and reduce the need for resupply missions from Earth.",

"Cons": "ISRU is technically challenging and would require significant investment in research and development.",

"Initial_Effort": "Medium. This would require the development of new technology and the establishment of infrastructure on Mars.",

"Implementation_Difficulty": "Medium. ISRU is a complex task that requires advanced technology.",

"Potential_Challenges": "Technical difficulties, high costs.",

"Expected_Outcomes": "If successful, ISRU could provide a steady supply of resources for a Mars colony.",

"Probability_of_Success": "High. ISRU is already being tested by NASA and other space agencies.",

"Confidence_Level": "70%"

}

},

"Ranking_2": {

"Justification": "Building a self-sustaining colony is a promising solution due to its potential to make the Mars colony self-sufficient. However, the high initial effort, implementation difficulty, and potential challenges make it less promising than the first solution. The medium probability of success and 60% confidence level also contribute to its ranking.",

"Building_a_Self_Sustaining_Colony": {

"Pros": "This solution could make the Mars colony self-sufficient, reducing the need for resupply missions from Earth.",

"Cons": "Building a self-sustaining colony is a complex task that requires advanced technology and a lot of resources.",

"Initial_Effort": "High. This would require the development of new technology and the establishment of infrastructure on Mars.",

"Implementation_Difficulty": "High. Building a self-sustaining colony is a complex task that requires advanced technology.",

"Potential_Challenges": "Technical difficulties, high costs.",

"Expected_Outcomes": "If successful, a self-sustaining colony could reduce the need for resupply missions from Earth.",

"Probability_of_Success": "Medium. While there are significant challenges, there is also a lot of interest in building a self-sustaining colony on Mars.",

"Confidence_Level": "60%"

}

},

"Ranking_3": {

"Justification": "While asteroid mining has the potential to provide a steady supply of resources for a Mars colony, the high initial effort, implementation difficulty, and potential challenges make it a less promising solution compared to others. The medium probability of success and 50% confidence level also contribute to its lower ranking.",

"Terraforming_Mars": {

"Pros": "This solution could make Mars more habitable for humans, reducing the need for life support systems and making the colony more self-sufficient.",

"Cons": "Terraforming is a long-term process that could take centuries or even millennia. It would also require a massive amount of resources and energy.",

"Initial_Effort": "Extremely High. Terraforming would require a massive amount of resources and energy.",

"Implementation_Difficulty": "Extremely High. Terraforming is a long-term process that could take centuries or even millennia.",

"Potential_Challenges": "Technical difficulties, high costs, time scale.",

"Expected_Outcomes": "If successful, terraforming could make Mars more habitable for humans.",

"Probability_of_Success": "Low. Terraforming is a theoretical concept and has never been attempted before.",

"Confidence_Level": "20%"

}

}

}

}

From the results reported in the figure below, ToT substantially outperforms the other prompting methods:

Image Source: Yao et el. (2023)

At a high level, the main ideas of Yao et el. (2023) and Long (2023) are similar.

Both enhance LLM’s capability for complex problem solving through tree search via a

multi-round conversation.One of the main difference is that Yao et el. (2023) leverages DFS/BFS/beam search, while the tree search strategy (i.e. when to backtrack and backtracking by how many levels, etc.) proposed in Long (2023) is driven by a “ToT Controller” trained through reinforcement learning.

DFS/BFS/Beam search are generic solution search strategies with no adaptation to specific problems.

In comparison, a ToT Controller trained through RL might be able learn from new data set or through self-play (AlphaGo vs brute force search), and hence the RL-based ToT system can continue to evolve and learn new knowledge even with a fixed LLM.

Hulbert (2023) has proposed Tree-of-Thought Prompting, which applies the main concept from ToT frameworks as a simple prompting technique, getting the LLM to evaluate intermediate thoughts in a single prompt.

- A sample ToT prompt is:

1

2

3

4

5

6

Imagine three different experts are answering this question.

All experts will write down 1 step of their thinking,

then share it with the group.

Then all experts will go on to the next step, etc.

If any expert realises they are wrong at any point then they leave.

The question is...

Sun (2023) benchmarked the Tree-of-Thought Prompting with large-scale experiments, and introduce PanelGPT — an idea of prompting with Panel discussions among LLMs.

PEFT - Parameter-Efficient Fine-Tuning (参数有效性微调)

总体来说 PEFT 可分为三个类别:

- Selective

- There are several approaches that you can take to identify which parameters you want to update.

- You have the option to train only certain components of the model or specific layers, or even individual parameter types.

- Researchers have found that the performance of these methods is mixed and there are significant trade-offs between parameter efficiency and compute efficiency

- Reparameterization

- LoRA:

- 通过学习小参数的低秩矩阵来近似模型权重矩阵的参数更新,训练时只优化低秩矩阵参数。

- LoRA:

- Additive

- keeping all of the original LLM weights frozen and introducing new trainable components.

Adapter-Tuning:

- 将较小的神经网络层或模块插入预训练模型的每一层,这些新插入的神经模块称为 adapter(适配器),下游任务微调时也只训练这些适配器参数

- add new trainable layers to the architecture of the model, typically

inside the encoder or decoder componentsafter the attention or feed-forward layers.

Soft prompt methods

- keep the model architecture fixed and frozen, and focus on manipulating the input to achieve better performance.

This can be done by adding trainable parameters to the

prompt embeddings or keeping the input fixed and retraining the embedding weights- Prompt-Tuning:

- 在模型的输入或隐层添加个额外可训练的前缀 tokens(这些前缀是连续的伪 tokens,不对应真实的 tokens),只训练这些前缀参数,包括 prefix-tuning parameter-efficient Prompt Tuning P-Tuning 等

Additive

Soft prompts / Prompt-Tuning

Prompt Learning

prompt learning:

Prompt-Tuning 和 In-context learning 是 prompt learning 的两种模式。

- In-context learning

- 指在大规模预训练模型上进行推理时,不需要提前在下游目标任务上进行微调,即不改变预训练模型参数就可实现推理,

- 其认为超大规模的模型只要配合好合适的模板就可以极大化地发挥其推理和理解能力。

常用的 In-context learning 方法有

few-shot one-shot zero-shot;Prompt-Tuning

- 指在下游目标任务上进行推理前,需要对全部或者部分参数进行更新

- 全部/部分的区别就在于预训练模型参数是否改变(其实本质上的 Prompt-Tuning 是不更新预训练模型参数的,这里有个特例方法称为 Prompt-Oriented Fine-Tuning,其实该方法更适合称为升级版的 Fine-Tuning,后面会详细介绍这个方法)。

- 无论是 In-context learning 还是 Prompt-Tuning,它们的目标都是将下游任务转换为预训练模型的预训练任务,以此来广泛激发出预训练模型中的知识。

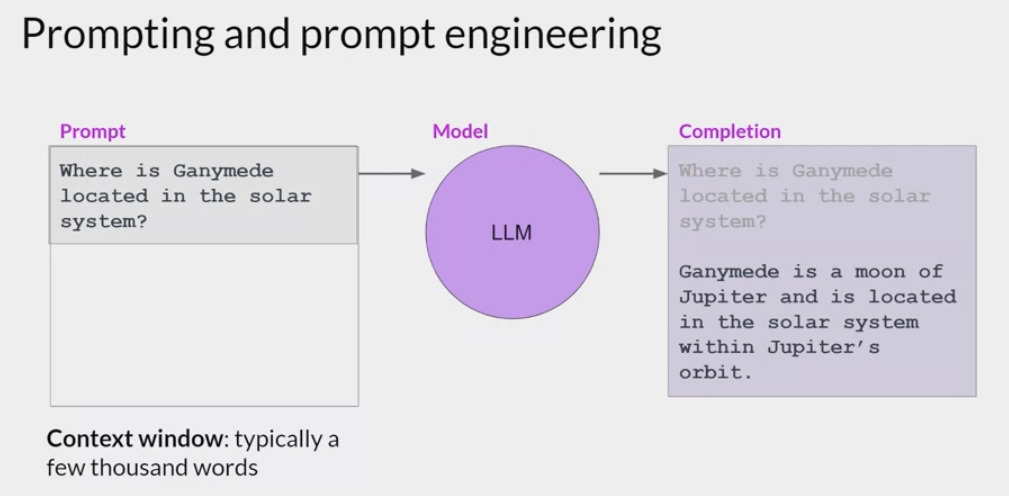

Prompting and prompt engineering:

- 如何设计输入的 prompt 是很重要的一点

- failed with 5-6 example, fune tune the model

- Typically, above five or six shots, so full prompt and then completions, you really don’t gain much after that. Either the model can do it or it can’t do it

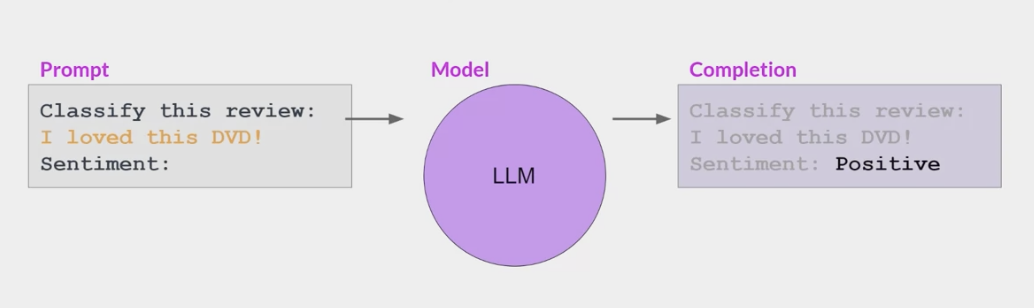

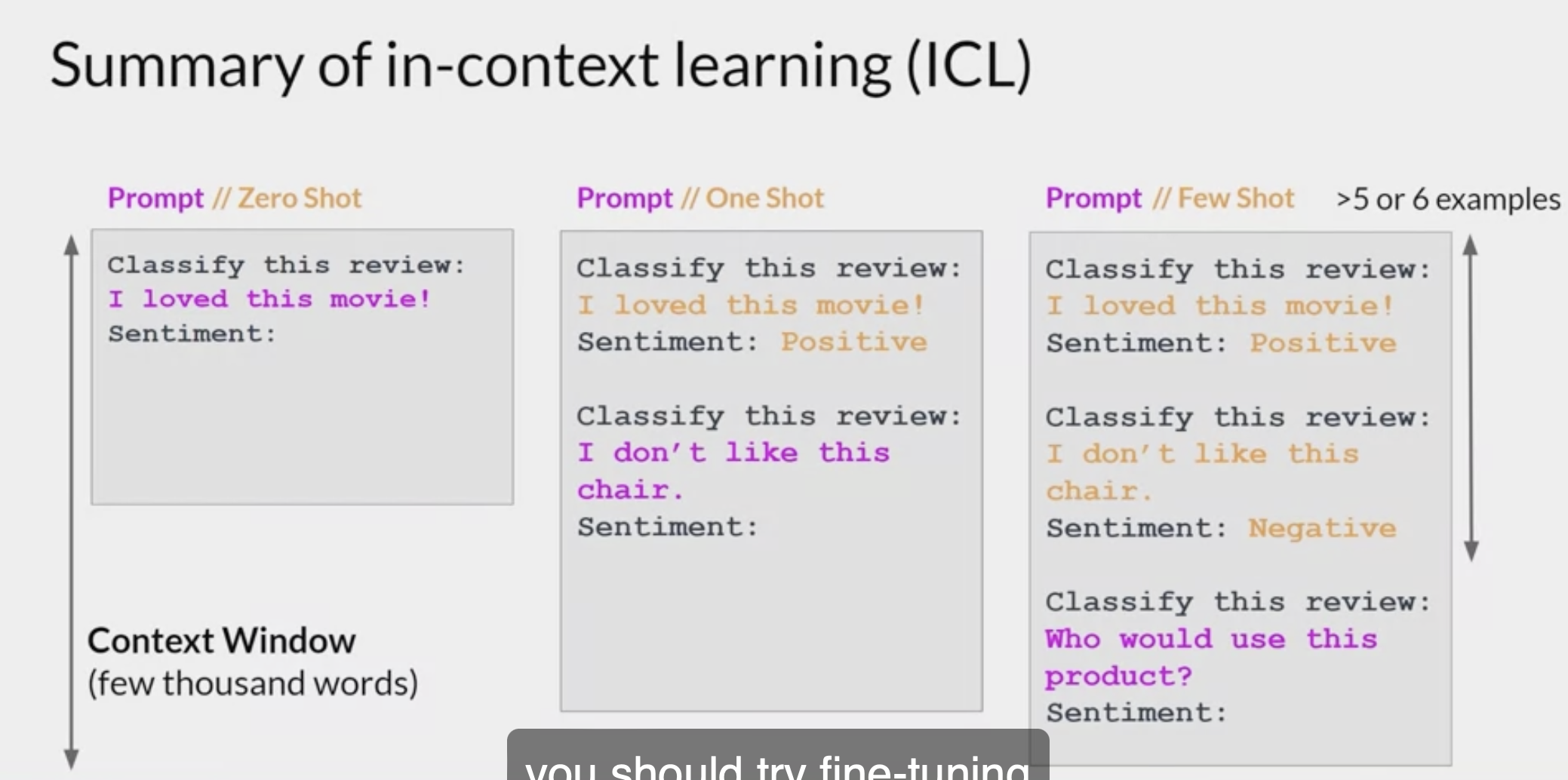

ICL - In-context learning (上下文学习)

- ICL 又称为上下文学习,最早是在 GPT-3《Language Models are Few-Shot Learners》中被提出来的。

ICL 的关键思想是从类比中学习。

下图给出了一个描述语言模型如何使用 ICL 进行决策的例子。

- 首先,ICL 需要一些示例来形成一个演示上下文。这些示例通常是用自然语言模板编写的。

- 然后 ICL 将查询的问题(即你需要预测标签的 input)和一个上下文演示(一些相关的 cases)连接在一起,形成带有提示的输入(可称之为 prompt),并将其输入到语言模型中进行预测。

- 值得注意的是,与需要使用反向梯度更新模型参数的训练阶段的监督学习不同,ICL 不需要参数更新,并直接对预先训练好的语言模型进行预测(这是与 Prompt-Tuning 不同的地方,ICL 不需要在下游任务中 Prompt-Tuning 或 Fine-Tuning)。

- 它希望模型能自动学习隐藏在演示中的模式,并据此做出正确的预测。

use LLMs off the shelf (i.e., without any fine-tuning), then control their behavior through clever prompting and conditioning on private “contextual” data.

it’s usually easier than the alternative: training or fine-tuning the LLM itself.

It also tends to outperform fine-tuning for relatively small datasets—since a specific piece of information needs to occur at least ~10 times in the training set before an LLM will remember it through fine-tuning—and can incorporate new data in near real time.

- Example:

- building a chatbot to answer questions about a set of legal documents.

naive approach: paste all the documents into a ChatGPT or GPT-4 prompt, then ask a question about them at the end. This may work for very small datasets, but it doesn’t scale. The biggest GPT-4 model can only process ~50 pages of input text, and performance (measured by inference time and accuracy) degrades badly when approach the limitcontext window.In-context learning: instead of sending all the documents with each LLM prompt, it sends only a handful of the most relevant documents. And the most relevant documents are determined with the help of . . . you guessed it . . . LLMs.

- building a chatbot to answer questions about a set of legal documents.

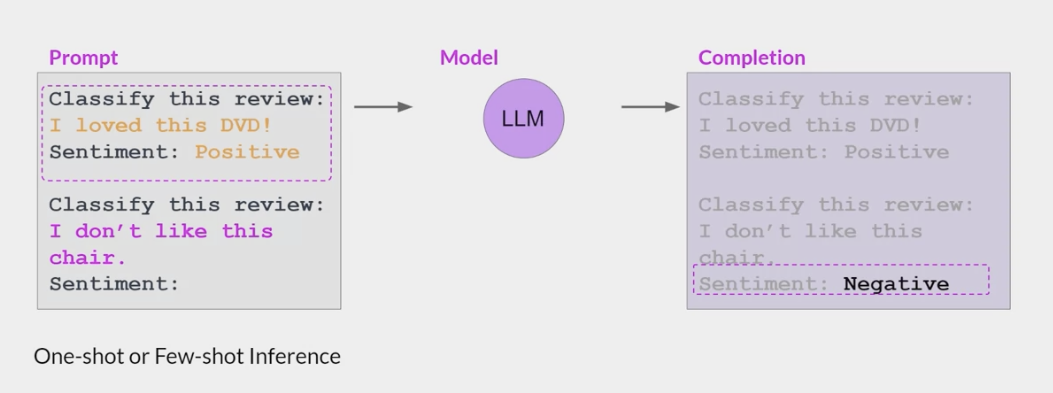

in-context learning method

One shot: creating an initial prompt that states the task to be completed and includes a single example question with answer followed by a second question to be answered by the LLM

In-context learning 的优势:

- 若干示例组成的演示是用自然语言撰写的,这提供了一个跟 LLM 交流的可解释性手段,通过这些示例跟模版让语言模型更容易利用到人类的知识;

- 类似于人类类比学习的决策过程,举一反三;

- 相比于监督学习,它不需要模型训练,减小了计算模型适配新任务的计算成本,更容易应用到更多真实场景。

In-context learning 的流程:

In-context learning 可以分为两部分,分为作用于 training 跟 inference 阶段:

Training:

在推理前,通过持续学习让语言模型的 ICL 能力得到进一步提升,这个过程称之为model warmup(模型预热),model warmup 会优化语言模型对应参数或者新增参数,区别于传统的 Fine-Tuning,Fine-Tuning 旨在提升 LLM 在特定任务上的表现,而 model warmup 则是提升模型整体的 ICL 性能。

Supervised in-context training: 为了增强 ICL 的能力,研究人员提出了

通过构建 in-context 训练数据,进而进行一系列有监督 in-context 微调以及多任务训练。由于预训练目标对于 In-context learning 并不是最优的,Sewon Min 等人提出了一种方法

MetaICL《MetaICL: Learning to Learn In Context》,以消除预训练和下游 ICL 使用之间的差距。预训练 LLM 在具有演示样例的广泛的任务上进行训练,这提高了其 few-shot 能力,例如,MetaICL获得的性能与在 52 个独力数据集上进行有监督微调相当。此外,还有一个研究方向,即有监督指令微调,也就是后面要讲到的 Instruction-Tuning。指令微调通过对任务指令进行训练增强了 LLM 的 ICL 能力。例如 Google 提出的

FLAN方法《FINETUNED LANGUAGE MODELS ARE ZERO-SHOT LEARNERS》: 通过在由自然语言指令模板构建的 60 多个 NLP 数据集上调整 137B 参数量的 LaMDA-PT 模型,FLAN 方法可以改善 zero-shot 和 few-shot ICL 性能(具体可参考Finetuned Language Models are Zero-shot Learners 笔记 - Instruction Tuning 时代的模型)。与 MetaICL 为每个任务构建若干演示样例相比,指令微调主要考虑对任务的解释,并且易于扩展。

Self-supervised in-context training:

Supervised Learning 指的是有一个 model,输入是 $x$ ,输出是 $y$ ,要有 label(标签)才可以训练 Supervised Learning,

比如让机器看一篇文章,决定文章是正面的还是负面的,得先找一大堆文章,标注文章是正面的还是负面的,正面负面就是 label。

- Self-Supervised Learning 就是机器自己在没有 label 的情况下,想办法做 Supervised Learning。

- 比如把没有标注的语料分成两部分,一部分作为模型的输入,一部分作为模型的输出,模型的输出和 label 越接近越好,具体参见2022 李宏毅机器学习深度学习学习笔记第四周–Self-Supervised Learning。

- 引申到 self-supervised in-context training,是根据 ICL 的格式将原始数据转换成 input-output 的 pair 对数据后利用四个自监督目标进行训练,包括掩

[Mask]预测,分类任务等。

Supervised ICT跟self-supervised ICT旨在通过引入更加接近于ICT的训练目标从而缩小预训练跟ICL之间的差距。- 比起需要示例的 In-context learning,只涉及任务描述的 Instruction-Tuning 更加简单且受欢迎。

- 另外,在 model warmup 这个阶段,语言模型只需要从少量数据训练就能明显提升 ICL 能力,不断增加相关数据并不能带来 ICL 能力的持续提升。

- 从某种角度上看,这些方法通过更新模型参数可以提升 ICL 能力也表明了原始的 LLM 具备这种潜力。

- 虽然 ICL 不要求 model warmup,但是一般推荐在推理前增加一个 model warmup 过程

- ICL 最初的含义指的是大规模语言模型涌现出一种能力: 不需要更新模型参数,仅仅修改输入 prompt 即添加一些例子就可以提升模型的学习能力。ICL 相比之前需要对模型在某个特定下游任务进行 Fine-Tuning 大大节省了成本。之后 ICL 问题演变成研究怎么提升模型以具备更好更通用的 ICL 能力,这里就可以用上之前 Fine-Tuning 的方式,即指 model warmup 阶段对模型更新参数

Inference:

很多研究表明 LLM 的 ICL 性能严重依赖于演示示例的格式,以及示例顺序等等,在使用目前很多 LLM 模型时我们也会发现,在推理时,同一个问题如果加上不同的示例,可能会得到不同的模型生成结果。

Demonstration Selection: 对于 ICL 而言,哪些样本是好的?语言模型的输入长度是有限制的,如何从众多的样本中挑选其中合适的部分作为示例这个过程非常重要。按照选择的方法主要可以分为无监督跟有监督两种。

无监督方法: 首先就是根据句向量距离或者互信息等方式选择跟当前输入 x 最相似的样本作为演示示例,另外还有利用自适应方法去选择最佳的示例排列,有的方法还会考虑到演示示例的泛化能力,尽可能去提高示例的多样性。除了上述这些从人工撰写的样本中选择示例的方式外,还可以利用语言模型自身去生成合适的演示示例。

监督方法: 第一种是先利用无监督检索器召回若干相似的样本,再通过监督学习训练的 Efficient Prompt Retriever 进行打分,从而筛选出最合适的样本。此外还有基于 Prompt Tuning 跟强化学习的方式去选择样本。

Demonstration Ordering: 挑选完演示示例后,如何对其进行排序也非常重要。排序的方法既有不需要训练的,也有根据示例跟当前输入距离远近进行排序的,也可以根据自定义的熵指标进行重排。

Demonstration Formatting:

- 如何设计演示示例的格式?最简单的方式就是将示例们的 $(x,y)$ 对按照顺序直接拼接到一起。

- 但是对于复杂的推理问题,语言模型很难直接根据 $x$ 推理出 $y$ ,这种格式就不适用了。

- 另外,有的研究旨在设计更好的任务指令 instruction 作为演示内容(即 Instruction-Tuning)。

- 对于这两类场景,除了人工撰写的方式外,还可以利用语言模型自身去生成对应的演示内容。

In-context learning 的模式:

- In-context learning 包括三种模式,分别称作 few-shot one-shot 以及 zero-shot,

- 三者的主要区别是 prompt 中包含的样本示例数量

- Few-Shot: 对下游任务,提供多条数据样例,论文中指出一般是 10-100 条;

- One-Shot: few-shot 的一种特殊情况,对下游任务,只提供一条数据样例;

- Zero-Shot: 是一种极端情况,对下游任务,不提供数据样例,只提供任务描述。

参考论文:

Prefix-Tuning

- Prefix-Tuning 也是一种 Prompt-Tuning

是最早提出 soft-prompt 的论文之一《Prefix-Tuning: Optimizing Continuous Prompts for Generation》,斯坦福大学于 2021 年发表。

Prefix-Tuning 在模型输入前添加一个连续的且任务特定的向量序列(continuous task-specific vectors),称之为前缀(prefix)。

前缀同样是一系列“虚拟 tokens”,即没有真实语义。

与更新所有 PLM 参数的全量微调不同,Prefix-Tuning 固定 PLM 的所有参数,只更新优化特定任务的 prefix。

Prefix-Tuning 与传统 Fine-Tuning 的对比图如下所示:

Prefix-Tuning 有两种模式,

- 一种是自回归模型(例如 GPT-2),在输入前添加一个前缀得到 $[PREFIX;x;y]$;

- 另一种是 encoder-decoder 模型(例如 Bart),在编码器和解码器前加前缀得到 $[PREFIX;x;PREFIX^{‘};y]$ m

Prefix-Tuning 的流程, 以 GPT-2 的自回归语言模型为例:

对于传统的 GPT-2 模型来说,将输入 $x$ 和输出 $y$ 拼接为 $z=[x;y]$,

- 其中 $X_{idx}$ 和 $Y_{idx}$ 分别为输入和输出序列的索引,

- h i ∈ R d h*{i} \in R^{d} hi∈Rd 是每个时间步 i i i 下的激活向量(隐藏层向量),

- h i = [ h i ( 1 ) ; … … ; h i ( n ) ] h*{i}=[h_{i}^{(1)}; ……;h_{i}^{(n)}] hi=[hi(1);……;hi(n)]表示在当前时间步的所有激活层的拼接,

- h i ( j ) h*{i}^{(j)} hi(j) 是时间步 i i i 的第 j j j 层激活层。

自回归模型通过如下公式计算 $h*{i}$ ,其中 ϕ \phi ϕ 是模型参数:

- h i = L M ϕ ( z i , h < i )

- h{i} =LM{\phi}(z{i},h{<i})\

- hi=LMϕ(zi,h<i)

- $h_{i}$ 的最后一层,用来计算下一个 token 的概率分布:

- p ϕ ( z i + 1 ∣ h ≤ i ) = s o f t m a x ( W ϕ h i ( n ) )

p{\phi}(z{i+1} h{≤i}) =softmax(W{\phi}h*{i}^{(n)})\ - pϕ(zi+1∣h≤i)=softmax(Wϕhi(n))

- 其中 W ϕ W{\phi} Wϕ 是将 h i ( n ) h{i}^{(n)} hi(n) 根据词表大小进行映射。

在采用 Prefix-Tuning 技术后,则在输入前添加前缀,

- 即将 prefix 和输入以及输出进行拼接得到 z = [ P R E F I X ; x ; y ] z=[PREFIX;x;y] z=[PREFIX;x;y],

- P i d x P*{idx} Pidx 为前缀序列的索引,

∣ P i d x ∣ P*{idx} ∣Pidx∣ 为前缀序列的长度, - 这里需要注意的是,Prefix-Tuning 是在模型的每一层都添加 prefix(注意不是只有输入层,中间层也会添加 prefix,目的增加可训练参数)。

前缀序列索引对应着由 θ \theta θ 参数化的向量矩阵 $P*{\theta}$ ,维度为 ∣ P i d x ∣ × d i m ( h i ) P*{idx} \times dim(h*{i}) ∣Pidx∣×dim(hi)。 - 隐层表示的计算如下式所示,若索引为前缀索引 P i d x P{idx} Pidx,直接从 $P{\theta}$ 复制对应的向量作为 $h_{i}$ (在模型每一层都添加前缀向量);否则直接通过 LM 计算得到,同时,经过 LM 计算的 $h_{i}$ 也依赖于其左侧的前缀参数 $P_{\theta}$ ,即通过前缀来影响后续的序列激活向量值(隐层向量值)。

- h i = { P θ [ i , : ] if i ∈ P i d x L M ϕ ( z i , h < i ) otherwise h{i}= \begin{cases} P{\theta}[i,:]& \text{if} \ \ \ i\in P{idx}\ LM{\phi}(z{i},h{<i})& \text{otherwise} \end{cases} hi={Pθ[i,:]LMϕ(zi,h<i)if i∈Pidxotherwise

- 在训练时,Prefix-Tuning 的优化目标与正常微调相同,但只需要更新前缀向量的参数。

- 在论文中,作者发现直接更新前缀向量的参数会导致训练的不稳定与结果的略微下降,因此采用了重参数化的方法,通过一个更小的矩阵 $P_{\theta}^{‘}$ 和一个大型前馈神经网络 $\text{MLP}{\theta}$ 对 $P{\theta}$ 进行重参数化: P θ [ i , : ] = MLP θ ( P θ ′ [ i , : ] ) P{\theta}[i,:]=\text{MLP}{\theta}(P{\theta}^{‘}[i,:]) Pθ[i,:]=MLPθ(Pθ′[i,:]),可训练参数包括 $P{\theta}^{‘}$ 和 $\text{MLP}_{\theta}$ 的参数

- 其中, $P_{\theta}$ 和 $P_{\theta}^{‘}$ 有相同的行维度(也就是相同的 prefix length), 但不同的列维度。

- 在训练时,LM 的参数 ϕ \phi ϕ 被固定,只有前缀参数 $P_{\theta}^{‘}$ 和 $\text{MLP}_{\theta}$ 的参数为可训练的参数。

- 训练完成后, $P_{\theta}^{‘}$ 和 $\text{MLP}{\theta}$ 的参数被丢掉,只有前缀参数 $P{\theta}$ 被保存。

Prefix-Tuning 的主要训练流程结论:

方法有效性:

- 作者采用了 Table-To-Text 与 Summarization 作为实验任务,在 Table-To-Text 任务上,Prefix-Tuning 在优化相同参数的情况下结果大幅优于 Adapter,并与全参数微调几乎相同。

- 而在 Summarization 任务上,Prefix-Tuning 方法在使用 2%参数与 0.1%参数时略微差于全参数微调,但仍优于 Adapter 微调;

Full vs Embedding-only:

- Embedding-only 方法只在 embedding 层添加前缀向量并优化,而 Full 代表的 Prefix-Tuning 不仅在 embedding 层添加前缀参数,还在模型所有层添加前缀并优化。

- 实验得到一个不同方法的表达能力增强链条: discrete prompting < embedding-only < Prefix-Tuning。同时,Prefix-Tuning 可以直接修改模型更深层的表示,避免了跨越网络深度的长计算路径问题;

Prefix-Tuning vs Infix-Tuning:

- 通过将可训练的参数放置在 $x$ 和 $y$ 的中间来研究可训练参数位置对性能的影响,即 $[x;Infix;y]$ ,这种方式成为 infix-tuning。

- 实验表明 Prefix-Tuning 性能好于 infix-tuning,因为 prefix 能够同时影响 $x$ 和 $y$ 的隐层向量,而 infix 只能够影响 $y$ 的隐层向量。

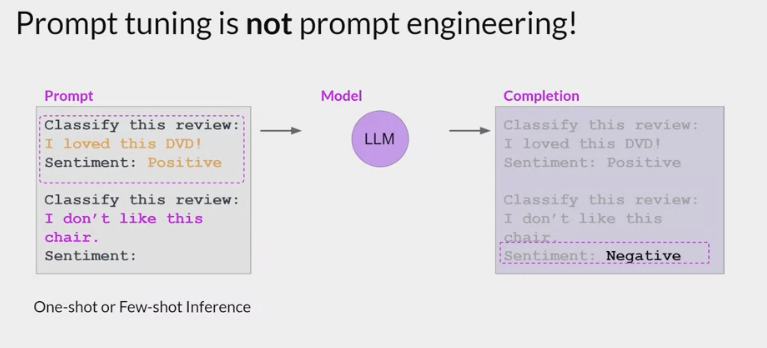

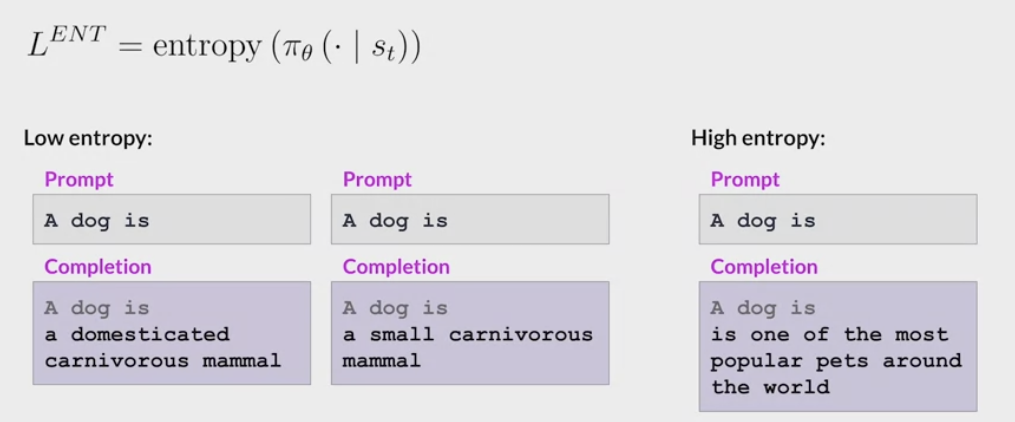

Prompt-Tuning (提示微调)

Not Prompt Engineering:

- some limitations to prompt engineering

- require a lot of manual effort to write and try different prompts

- limited by the length of the context window

- may still not achieve the performance at the end of the day

With prompt tuning

- add additional trainable tokens to the prompt and leave it up to the supervised learning process to determine their optimal values.

- The set of trainable tokens is called a soft prompt, and it gets prepended to

embedding vectorsthat represent the input text. - The soft prompt vectors have the same length as the embedding vectors of the language tokens.

- including somewhere between 20 and 100 virtual tokens can be sufficient for good performance.

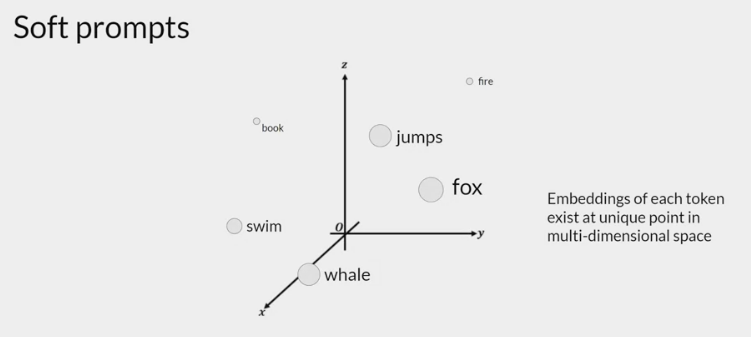

The tokens that represent natural language are hard in the sense that they each correspond to a fixed location in the embedding vector space.

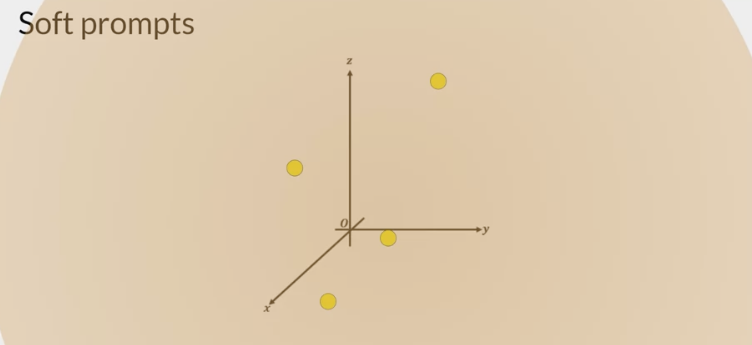

- the soft prompts are not fixed discrete words of natural language, but virtual tokens that can take on any value within the continuous multidimensional embedding space.

- And through supervised learning, the model learns the values for these virtual tokens that maximize performance for a given task.

full fine tuning & prompt tuning

- In full fine tuning

- the training data set consists of

input prompts and output completions or labels. - The weights of the llm are updated during supervised learning.

- the training data set consists of

- prompt tuning

- the weights of the llm are frozen and the underlying model does not get updated.

- Instead, the embedding vectors of the soft prompt gets updated over time to optimize the model’s completion of the prompt.

Prompt tuning

- very parameter efficient strategy

- only a few parameters are being trained.

- can train a different set of soft prompts for each task and then easily swap them out at inference time. You can train a set of soft prompts for one task and a different set for another, simply change the soft prompt.

- Soft prompts are very small on disk, so this kind of fine tuning is extremely efficient and flexible.

how well does prompt tuning perform?

- once models have around 10 billion parameters, prompt tuning can be as effective as full fine tuning and offers a significant boost in performance over prompt engineering alone.

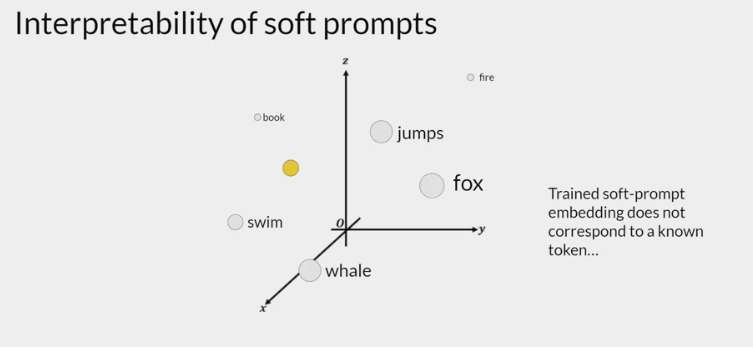

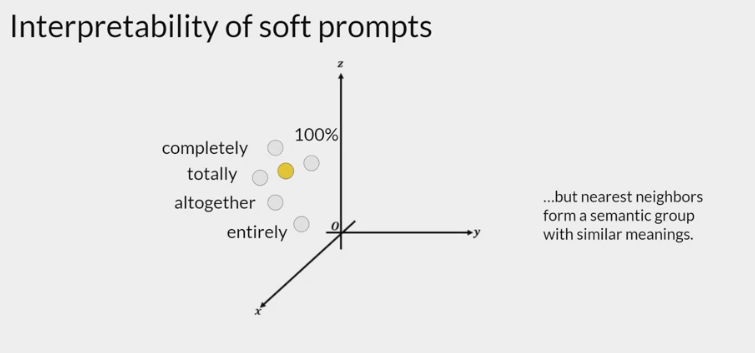

interpretability of learned virtual tokens

- because the soft prompt tokens can take any value within the continuous embedding vector space. The trained tokens don’t correspond to any known token, word, or phrase in the vocabulary of the LLM. However, an analysis of the nearest neighbor tokens to the soft prompt location shows that they form tight semantic clusters. In other words, the words closest to the soft prompt tokens have similar meanings. The words identified usually have some meaning related to the task, suggesting that the prompts are learning word like representations.

以二分类的情感分析作为例子:

给定一个句子

[CLS]I like the Disney films very much.[SEP],传统的 Fine-Tuning 方法:

- 将其通过 Bert 获得

[CLS]表征之后再喂入新增加的MLP分类器进行二分类,预测该句子是积极的(positive)还是消极的(negative) - 因此需要一定量的训练数据来训练。

- 将其通过 Bert 获得

而 Prompt-Tuning 则执行如下步骤:

构建模板(Template Construction):

- 通过人工定义 自动搜索 文本生成等方法,生成与给定句子相关的一个含有

[Mask]标记的模板。例如 It was[Mask] - 并拼接到原始的文本中,获得 Prompt-Tuning 的输入:

[CLS]I like the Disney films very much. It was[Mask].[SEP]。 - 将其喂入 B 模型中,并复用预训练好的 MLM 分类器(在 huggingface 中为 BertForMaskedLM),即可直接得到

[Mask]预测的各个 token 的概率分布;

- 通过人工定义 自动搜索 文本生成等方法,生成与给定句子相关的一个含有

标签词映射(Label Word Verbalizer):

- 因为

[Mask]部分我们只对部分词感兴趣,因此需要建立一个映射关系。 - 例如如果

[Mask]预测的词是“great”,则认为是 positive 类,如果是“terrible”,则认为是 negative 类; - 不同的句子应该有不同的 template 和 label word,因为每个句子可能期望预测出来的 label word 都不同,因此如何最大化的寻找当前任务更加合适的 template 和 label word 是 Prompt-Tuning 非常重要的挑战;

- 因为

训练:

- 根据 Verbalizer,则可以获得指定 label word 的预测概率分布,并采用交叉信息熵进行训练。

- 此时因为只对预训练好的 MLM head 进行微调,所以避免了过拟合问题。

parameter-efficient prompt tuning(下面简称为 Prompt Tuning)可以看作是 Prefix-Tuning 的简化版。

两者的不同点:

- 参数更新策略不同: Prompt Tuning 只对输入层(Embedding)进行微调,而 Prefix-Tuning 是对每一层全部进行微调。因此 parameter-efficient prompt tuning 的微调参数量级要更小(如下图),且不需要修改原始模型结构;

- 参数生成方式不同: Prompt Tuning 与 Prefix-Tuning 及 P-Tuning 不同的是,没有采用任何的 prompt 映射层(即 Prefix-Tuning 中的重参数化层与 P-Tuning 中的 prompt encoder),而是直接对 prompt token 对应的 embedding 进行了训练;

- 面向任务不同: Pompt Tuning P-Tuning 以及后面要介绍的 P-Tuning v2 都是面向的 NLU 任务进行效果优化及评测的,而 Prefix-Tuning 针对的则是 NLG 任务。

P-Tuning v2: P-Tuning v2 是 2022 年发表的一篇论文《P-Tuning v2: Prompt Tuning Can Be Comparable to Fine-tuning Universally Across Scales and Tasks》,总结来说是在 Prefix-Tuning 和 P-Tuning 的基础上进行的优化。下面我们简单介绍下 P-Tuning v2 方法。

P-Tuning v2 针对 Prefix-Tuning P-Tuning 解决的问题:

- Prefix-Tuning 是针对于生成任务而言的,不能处理困难的序列标注任务 抽取式问答等,缺乏普遍性;

- 当模型规模较小,特别是小于 100 亿个参数时,它们仍然不如 Fine-Tuning。

P-Tuning v2 的优点:

- P-Tuning v2 在不同的模型规模(从 300M 到 100B 的参数)和各种困难的 NLU 任务(如问答和序列标注)上的表现与 Fine-Tuning 相匹配;

- 与 Fine-Tuning 相比,P-Tuning v2 每个任务的可训练参数为 0.1%到 3%,这大大降低了训练时间的内存消耗和每个任务的存储成本。

P-Tuning v2 的核心点:

- NLU 任务优化: 主要针对 NLU 任务进行微调,提升 P-Tuning v2 在 NLU 任务上的效果;

- 深度提示优化: 参考 Prefix-Tuning,不同层分别将 prompt 作为前缀 token 加入到输入序列中,彼此相互独立(注意,这部分 token 的向量表征是互不相同的,即同 Prefix-Tuning 一致,不是参数共享模式),如下图所示。通过这种方式,一方面,P-Tuning v2 有更多的可优化的特定任务参数(从 0.01%到 0.1%-3%),以保证对特定任务有更多的参数容量,但仍然比进行完整的 Fine-Tuning 任务参数量小得多;另一方面,添加到更深层的提示,可以对输出预测产生更直接的影响。

P-Tuning v2 的其他优化及实施点:

- 重参数化: 以前的方法利用重参数化功能来提高训练速度 鲁棒性和性能(例如,MLP 的 Prefix-Tuning 和 LSTM 的 P-Tuning)。然而,对于 NLU 任务,论文中表明这种技术的好处取决于任务和数据集。对于一些数据集(如 RTE 和 CoNLL04),MLP 的重新参数化带来了比嵌入更稳定的改善;对于其他的数据集,重参数化可能没有显示出任何效果(如 BoolQ),有时甚至更糟(如 CoNLL12)。需根据不同情况去决定是否使用;

- 提示长度: 提示长度在提示优化方法的超参数搜索中起着核心作用。论文中表明不同的理解任务通常用不同的提示长度来实现其最佳性能,比如一些简单的 task 倾向比较短的 prompt(less than 20),而一些比较难的序列标注任务,长度需求比较大;

- 多任务学习: 多任务学习对 P-Tuning v2 方法来说是可选的,但可能是有帮助的。在对特定任务进行微调之前,用共享的 prompts 去进行多任务预训练,可以让 prompts 有比较好的初始化;

- 分类方式选择: 对标签分类任务,用原始的 CLS+linear head 模式替换 Prompt-Tuning 范式中使用的 Verbalizer+LM head 模式,不过效果并不明显,如下图。

Adapter-Tuning

Adapter-Tuning: 《Parameter-Efficient Transfer Learning for NLP》这项 2019 年的工作第一次提出了 Adapter 方法。

- Prefix-Tuning 和 Prompt Tuning: 在输入前添加

可训练 prompt embedding 参数来以少量参数适配下游任务 Adapter-Tuning: 在预训练模型内部的网络层之间

添加新的网络层或模块来适配下游任务。- 假设预训练模型函数表示为 $\phi_{w}(x)$

- 对于 Adapter-Tuning,添加适配器之后模型函数更新为: $\phi{w,w{0}}(x)$

- $w$ 是预训练模型的参数,

- $w_{0}$ 是新添加的适配器的参数,

- 在训练过程中, $w$ 被固定,只有 $w_{0}$ 被更新。

$ w_{0} \ll w $, 这使得不同下游任务只需要添加少量可训练的参数即可,节省计算和存储开销,同时共享大规模预训练模型。 在对预训练模型进行微调时,我们可以冻结在保留原模型参数的情况下对已有结构添加一些额外参数,对该部分参数进行训练从而达到微调的效果。

- 论文中采用 Bert 作为实验模型,Adapter 模块被添加到每个 transformer 层两次。适配器是一个 bottleneck(瓶颈)结构的模块,由一个两层的前馈神经网络(由向下投影矩阵 非线性函数和向上投影矩阵构成)和一个输入输出之间的残差连接组成。其总体结构如下(跟论文中的结构有些出入,目前没有理解论文中的结构是怎么构建出来的,个人觉得下图更准确的刻画了 adapter 的结构,有不同见解可在评论区沟通):

Adapter 结构有两个特点:

- 较少的参数

- q在初始化时与原结构相似的输出。

在实际微调时,由于采用了 down-project 与 up-project 的架构,在进行微调时,Adapter 会先将特征输入通过 down-project 映射到较低维度,再通过 up-project 映射回高维度,从而减少参数量。

Adapter-Tuning 只需要训练原模型 0.5%-8%的参数量,若对于不同的下游任务进行微调,只需要对不同的任务保留少量 Adapter 结构的参数即可。由于 Adapter 中存在残差连接结构,采用合适的小参数去初始化 Adapter 就可以使其几乎保持原有的输出,使得模型在添加额外结构的情况下仍然能在训练的初始阶段表现良好。在 GLUE 测试集上,Adapter 用了更少量的参数达到了与传统 Fine-Tuning 方法接近的效果。

Reparameterization

LoRA

Low-rank Adaptatio

a parameter-efficient fine-tuning technique that falls into the re-parameterization category

微软于 2022 年发表《LORA: LOW-RANK ADAPTATION OF LARGE LANGUAGE MODELS》。

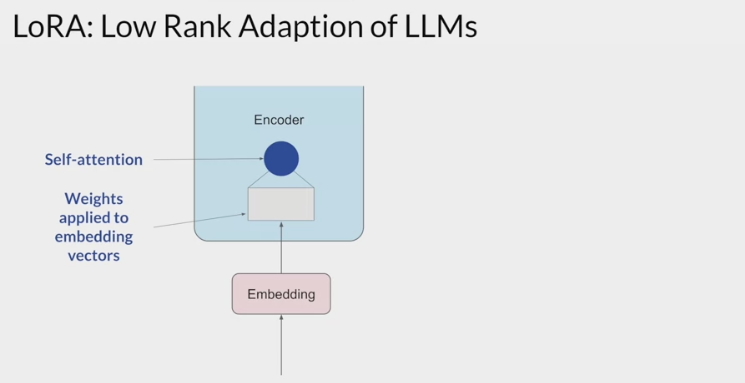

LoRA 的实现原理:

在模型的 Linear 层的旁边,增加一个“旁支”

- 这个“旁支”的作用,就是代替原有的参数矩阵 $W$ 进行训练。

输入 $x\in R^{d}$

举个例子,在普通的 transformer 模型中:

- $x$ 可能是 embedding 的输出,也有可能是上一层 transformer layer 的输出

- $d$ 一般就是 768 或者 1024。

按照原本的路线,它应该只走左边的部分,也就是原有的模型部分。

而在 LoRA 的策略下,增加了右侧的“旁支”

先用一个 Linear 层 $A$ ,将数据从 $d$ 维降到 $r$

- $r$

- 也就是 LoRA 的秩,是 LoRA 中最重要的一个超参数。

- 一般会远远小于 $d$

- 尤其是对于现在的大模型, $d$ 已经不止是 768 或者 1024,

- 例如 LLaMA-7B,每一层 transformer 有 32 个 head,这样一来 $d$ 就达到了 4096。

- $r$

接着再用第二个 Linear 层 $B$,将数据从 $r$ 变回 $d$ 维。

最后再将左右两部分的结果相加融合,就得到了输出的 $hidden*state$

对于左右两个部分,右侧看起来像是左侧原有矩阵 $W$ 的分解,将参数量从 $d\times d$ 变成了 $d\times r +d\times r$

在 $r\ll d$ 的情况下,参数量就大大地降低了。

熟悉各类预训练模型的同学可能会发现,这个思想其实与 Albert 的思想有异曲同工之处

- Albert 通过两个策略降低了训练的参数量,其一是 Embedding 矩阵分解,其二是跨层参数共享。

- Albert 考虑到词表的维度很大,所以

将 Embedding 矩阵分解成两个相对较小的矩阵,用来模拟 Embedding 矩阵的效果,这样一来需要训练的参数量就减少了很多。

LoRA 也是类似的思想,并且它不再局限于 Embedding 层,而是所有出现大矩阵的地方,理论上都可以用到这样的分解。

与 Albert 不同的是:

- Albert 直接用两个小矩阵替换了原来的大矩阵,

- LoRA 保留了原来的矩阵 $W$ ,但是不让 $W$ 参与训练

- Fine-Tuning 是更新权重矩阵 $W$

- LoRA 中的 $W=W*{0}+BA$,但是 $W_{0}$ 不参与更新,只更新 $A$ 和 $B$

所以需要计算梯度的部分就只剩下旁支的 $A$ 和 $B$两个小矩阵。

- 用随机高斯分布初始化 A,用 0 矩阵初始化 B,保证训练的开始此旁路矩阵是 0 矩阵,使得模型保留原有知识,在训练的初始阶段仍然表现良好。

- A 矩阵不采用 0 初始化主要是因为如果矩阵 A 也用 0 初始化,那么矩阵 B 梯度就始终为 0(对 B 求梯度,结果带有 A 矩阵,A 矩阵全 0,B 的梯度结果必然是 0),无法更新参数。

从论文中的公式来看,在加入 LoRA 之前,模型训练的优化表示为:

$max{\Phi} \sum{(x,y \in Z)}\sum*{t=1}^{ y }log(P{\Phi}(y{t} x,y*{<t}))$ - 其中,模型的参数用 $\Phi$ 表示。

而加入了 LoRA 之后,模型的优化表示为:

$max{\Theta} \sum{(x,y \in Z)}\sum*{t=1}^{ y }log(P{\Phi{0}+\Delta\Phi(\Theta)}(y*{t} x,y*{<t}))$ 其中

- 模型原有的参数是 $\Phi*{0}$

- LoRA 新增的参数是 $\Delta\Phi(\Theta)$

尽管参数看起来增加了 $\Delta\Phi(\Theta)$,但是从前面的 max 的目标来看,需要优化的参数只有 $\Theta$,而根 $ \Theta \ll \Phi*{0} $, 这就使得训练过程中,梯度计算量少了很多 - 所以就在低资源的情况下,我们可以只消耗 $\Theta$ 这部分的资源,在单卡低显存的情况下训练大模型了。

通常在实际使用中,一般 LoRA 作用的矩阵是注意力机制部分的 $W{Q}$ $W{K}$ $W*{V}$ 矩阵

- 即与输入相乘获取 $Q K V$ 的权重矩阵。

- 这三个权重矩阵的数量正常来说,分别和 heads 的数量相等

- 但在实际计算过程中,是将多个头的这三个权重矩阵分别进行了合并

- 因此每一个 transformer 层都只有一个 $W{Q}$ $W{K}$ $W_{V}$ 矩阵

LoRA 架构的优点:

全量微调的一般化:

- 不要求权重矩阵的累积梯度更新在适配过程中具有满秩。

- 当对所有权重矩阵应用 LoRA 并训练所有偏差时,将 LoRA 的秩 $r$ 设置为预训练权重矩阵的秩,就能大致恢复了全量微调的表现力。

- 随着增加可训练参数的数量,训练 LoRA 大致收敛于训练原始模型;

没有额外的推理延时:

- 在生产部署时,可以明确地计算和存储 $W=W*{0}+BA$,并正常执行推理。

- 当需要切换到另一个下游任务时,可以通过减去 $BA$ 来恢复 $W*{0}$ ,然后增加一个不同的 $B^{‘}A^{‘}$,这是一个只需要很少内存开销的快速运算。

- 最重要的是,与 Fine-Tuning 的模型相比,LoRA 推理过程中没有引入任何额外的延迟(将 $BA$ 加到原参数 $W_{0}$ 上后,计算量是一致的);

减少内存和存储资源消耗:

- 对于用 Adam 训练的大型 Transformer,若 $r\ll d_{model}$,LoRA 减少 2/3 的显存用量(训练模型时,模型参数往往都会存储在显存中)

- 因为不需要存储已固定的预训练参数的优化器状态,可以用更少的 GPU 进行大模型训练。

- 在 175B 的 GPT-3 上,训练期间的显存消耗从 1.2TB 减少到 350GB。

- 在有且只有 query 和 value 矩阵被调整的情况下,checkpoint 的大小大约减少了 10000 倍(从 350GB 到 35MB)。

- 另一个好处是,可以在部署时以更低的成本切换任务,只需更换 LoRA 的权重,而不是所有的参数。

- 可以创建许多定制的模型,这些模型可以在将预训练模型的权重存储在显存中的机器上进行实时切换。

- 在 175B 的 GPT-3 上训练时,与完全微调相比,速度提高了 25%,因为我们不需要为绝大多数的参数计算梯度;

更长的输入:

- 相较 P-Tuning 等 soft-prompt 方法,LoRA 最明显的优势,就是不会占用输入 token 的长度。

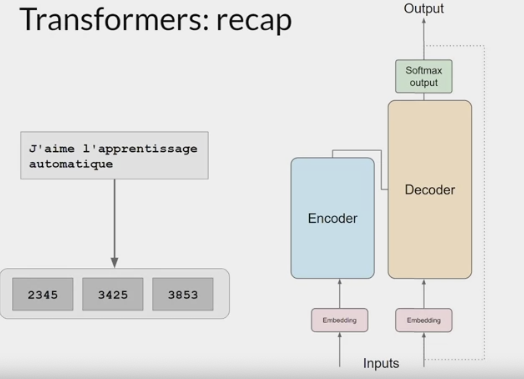

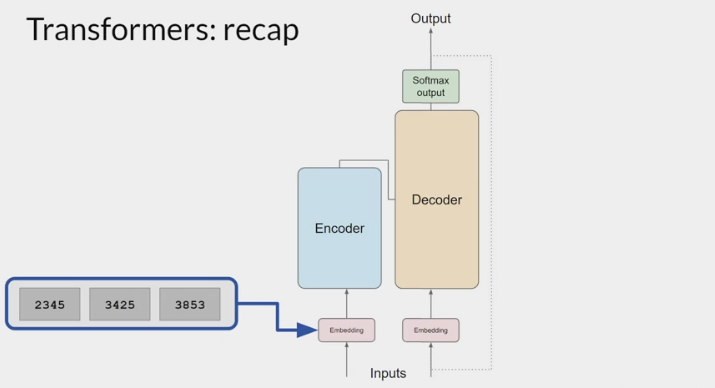

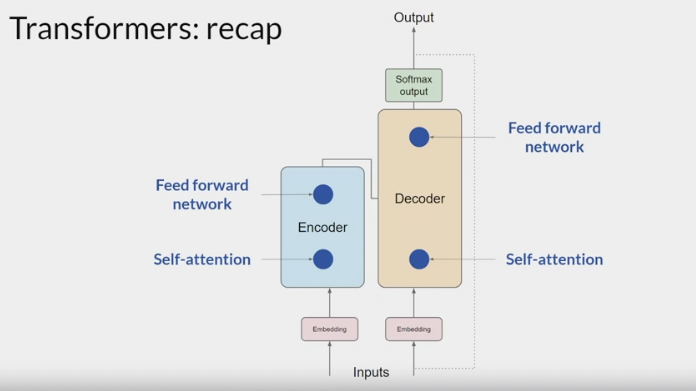

Transformer architecture:

The input prompt is turned into tokens

tokens are then converted to embedding vectors and passed into the encoder and/or decoder parts of the transformer.

In both of these components, there are two kinds of neural networks; self-attention and feedforward networks.

After the embedding vectors are created, they’re fed into the self-attention layers where a series of weights are applied to calculate the attention scores.

During full fine-tuning, every parameter in these layers is updated.

- LoRA reduces the number of parameters to be trained during fine-tuning by freezing all of the original model parameters and then injecting a pair of rank decomposition matrices alongside the original weights.

- You can keep the original weights of the LLM frozen and train the smaller matrices using the same supervised learning process

- The dimensions of the smaller matrices are set so their product is a matrix with the same dimensions as the weights been modifying. the two low-rank matrices are multiplied together to create a matrix with the same dimensions as the frozen weights.

- You then add this to the original weights and replace them in the model with these updated values.

- You now have a LoRA fine-tuned model that can carry out the specific task.

Because this model has the same number of parameters as the original, there is little to no impact on inference latency.

- Researchers have found that applying LoRA to just the self-attention layers of the model is often enough to fine-tune for a task and achieve performance gains.

- you can also use LoRA on other components like the feed-forward layers.

- But since most of the parameters of LLMs are in the attention layers, you get the biggest savings in trainable parameters by applying LoRA to these weights matrices.

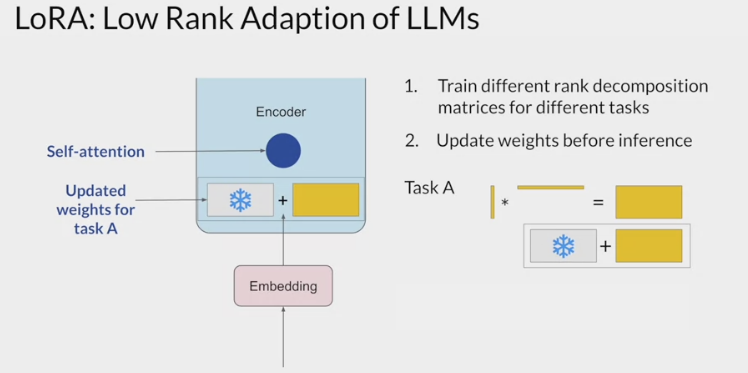

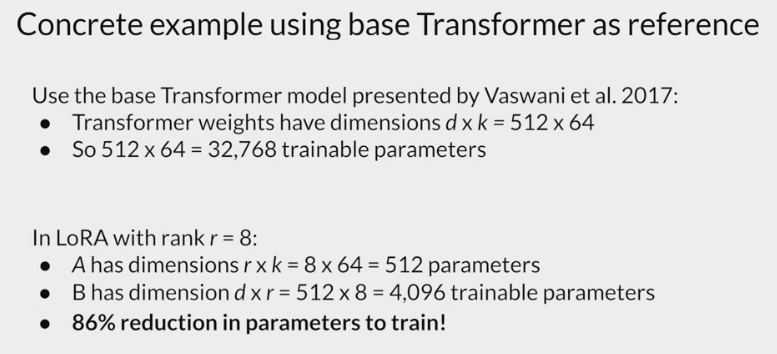

A practical example using the transformer architecture described in the Attention is All You Need paper.

- The paper specifies that the transformer weights have dimensions of 512 by 64.

- each weights matrix has 32,768 trainable parameters.

- If use LoRA as a fine-tuning method with the rank 8

- you will train 2 small rank decomposition matrices whose small dimension is eight.

- Matrix A will have dimensions of 8 by 64, resulting in 512 total parameters.

- Matrix B will have dimensions of 512 by 8, or 4,096 trainable parameters.

By updating the weights of these new low-rank matrices instead of the original weights, you’ll be training 4,608 parameters instead of 32,768 and 86% reduction.

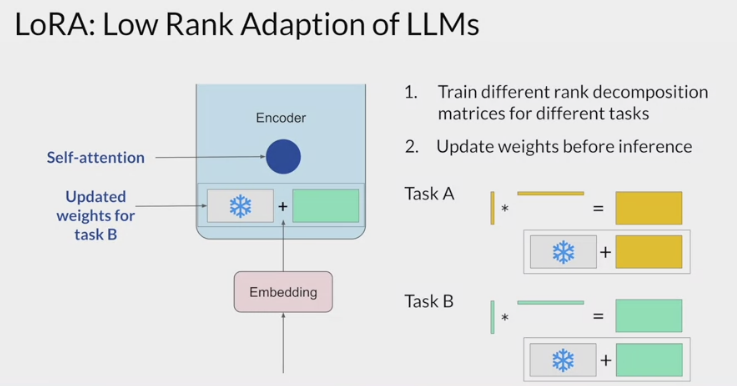

Because LoRA allows you to significantly reduce the number of trainable parameters, you can often perform this method of parameter efficient fine tuning

with a single GPU and avoid the need for a distributed cluster of GPUs.Since the rank-decomposition matrices are small, you can fine-tune a different set for each task and then switch them out at inference time by updating the weights.

- Suppose you train a pair of LoRA matrices for a specific task; Task A. To carry out inference on this task, you would multiply these matrices together and then add the resulting matrix to the original frozen weights. You then take this new summed weights matrix and replace the original weights where they appear in the model. You can then use this model to carry out inference on Task A.

- If you want to carry out a different task, Task B, you simply take the LoRA matrices you trained for this task, calculate their product, and then add this matrix to the original weights and update the model again.

- The memory required to store these LoRA matrices is very small. So you can use LoRA to train for many tasks. Switch out the weights when you need to use them, and avoid having to store multiple full-size versions of the LLM.

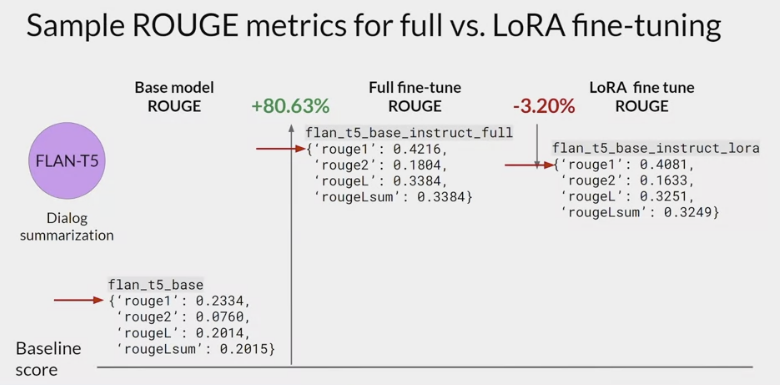

How good are these models?

- fine-tuning the FLAN-T5 for dialogue summarization

- baseline score for the FLAN-T5 base model and the summarization data set, the scores are fairly low. Next,

- full fine-tuning on dialogue summarization

- With full fine-tuning, you update every way in the model during supervised learning.

- results in a much higher ROUGE 1 score increasing over the base FLAN-T5 model by 0.19.

- The additional round of fine-tuning has greatly improved the performance of the model on the summarization task.

- LoRA fine-tune model.

- also resulted in a big boost in performance.

- a little lower than full fine-tuning, but not much.

- using LoRA for fine-tuning trained a much smaller number of parameters than full fine-tuning using significantly less compute, so this small trade-off in performance may well be worth it.

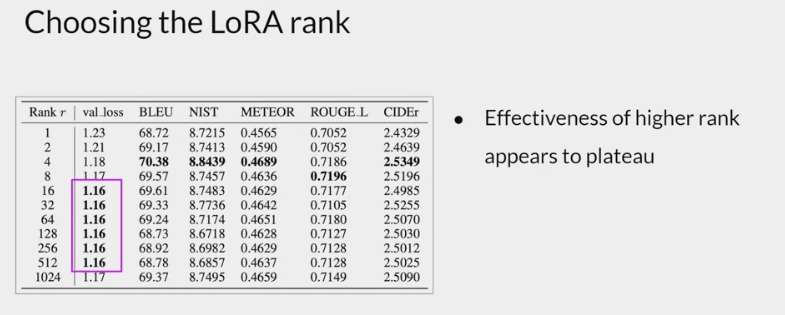

how to choose the rank of the LoRA matrices.

- the smaller the rank, the smaller the number of trainable parameters, and the bigger the savings on compute.

- plateau in the loss value for ranks greater than 16. using larger LoRA matrices didn’t improve performance.

- ranks in the range of 4-32 can provide you with a good trade-off between reducing trainable parameters and preserving performance.

AdaLoRA

- 发表于 2023 年 3 月《ADAPTIVE BUDGET ALLOCATION FOR PARAMETEREFFICIENT FINE-TUNING》

- 论文中发现对不同类型权重矩阵或者不同层的权重矩阵应用 LoRA 方法,产生的效果是不同的

- 在参数预算有限的情况下(例如限定模型可微调参数的数量),如何智能的选取更重要的参数进行更新,显得尤为重要。

论文中提出的解决办法,是先对 LoRA 对应的权重矩阵进行 SVD 分解,即:

$W=W{0}+\Delta=W{0}+BA=W_{0}+P\Lambda Q$

- 其中: $\Delta$ 称为增量矩阵,

- $W\in R^{d1 \times d2}$

- $P\in R^{d1 \times r}$

- $Q\in R^{r \times d2}$

- $\Lambda\in R^{r \times r}$

- $r\ll min(d1,d2)$

- 再根据重要性指标动态地调整每个增量矩阵中奇异值的大小。

- 这样可以使得在微调过程中只更新那些对模型性能贡献较大或必要的参数,从而提高了模型性能和参数效率。

- 论文简介ADAPTIVE BUDGET ALLOCATION FOR PARAMETER- EFFICIENT FINE-TUNING

BitFit

BitFit

- Bias-term Fine-tuning

- 发表于 2022 年BitFit: Simple Parameter-efficient Fine-tuning for Transformer-based Masked Language-models的思想更简单,其不需要对预训练模型做任何改动,只需要指定神经网络中的偏置(Bias)为可训练参数即可,BitFit 的参数量只有不到 2%,但是实验效果可以接近全量参数。

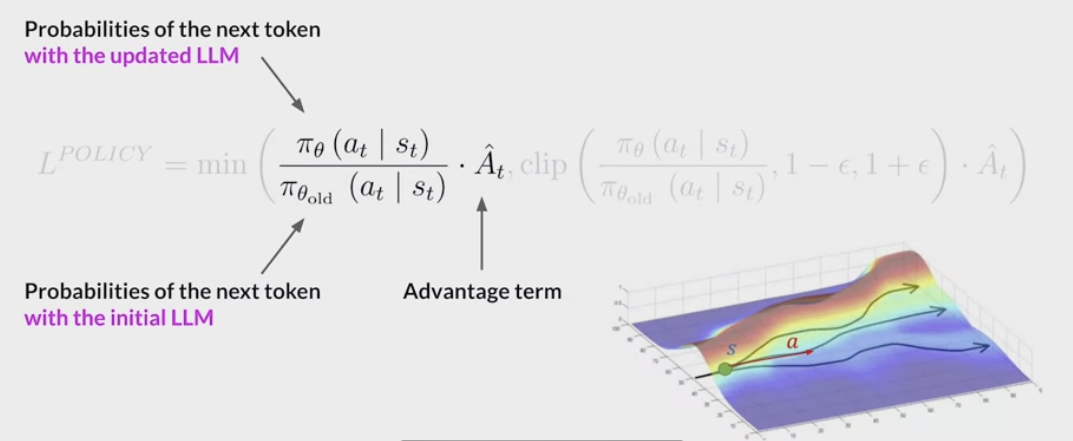

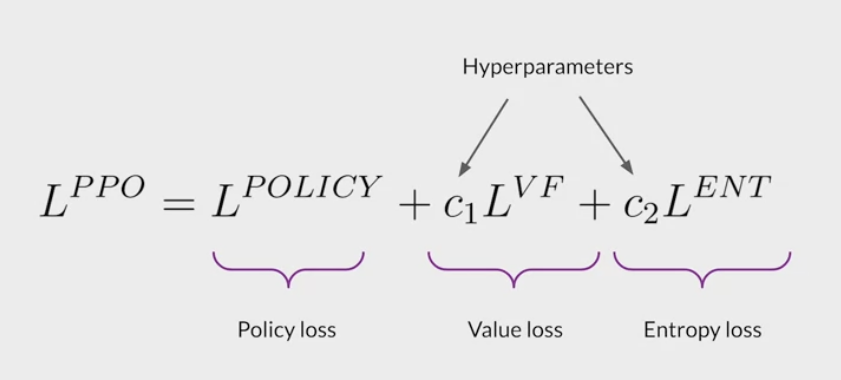

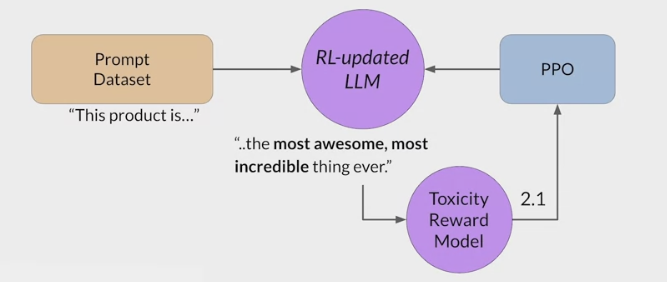

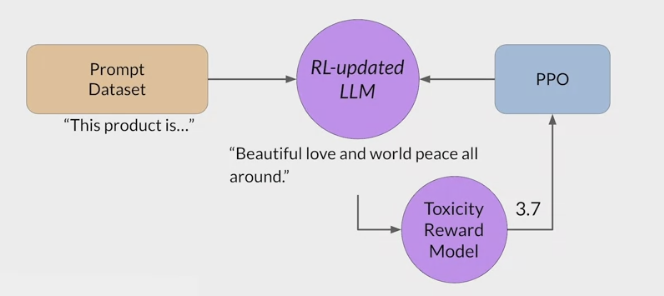

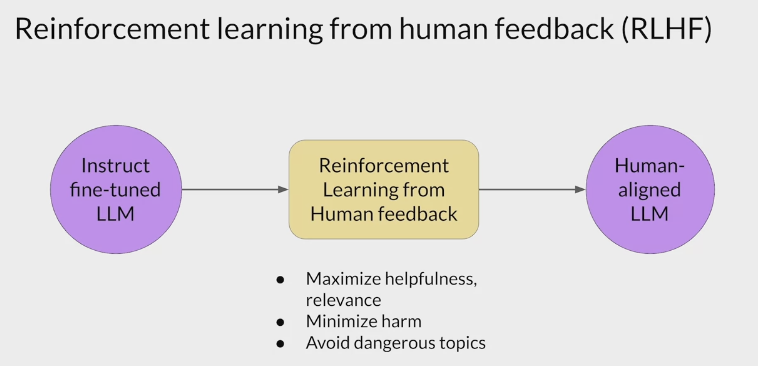

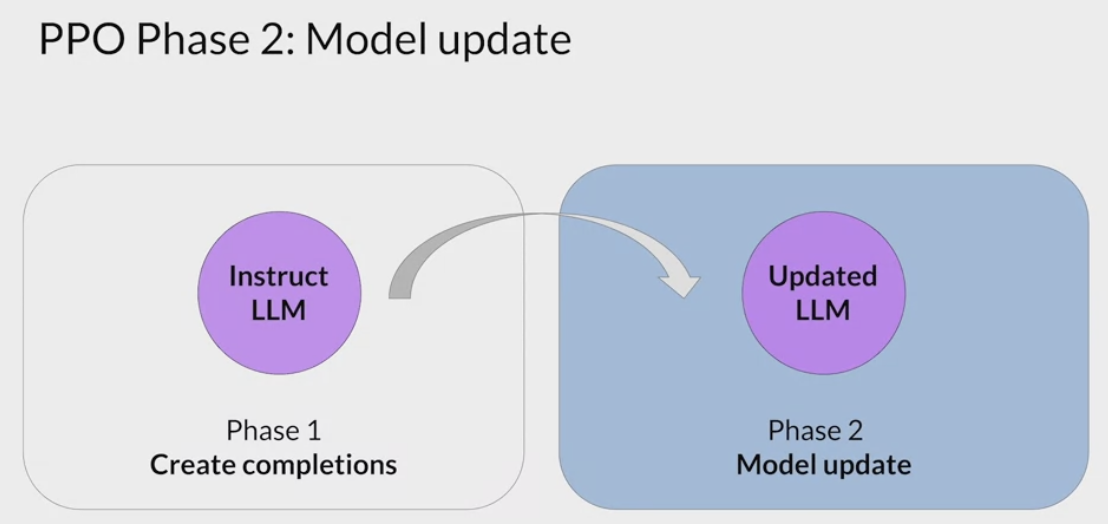

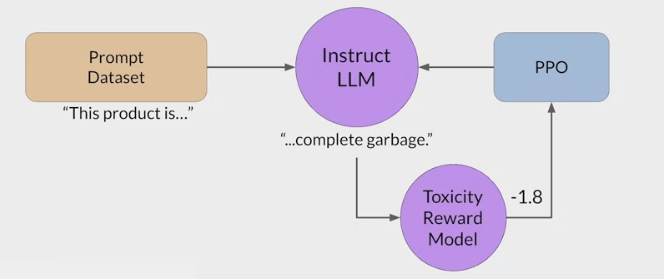

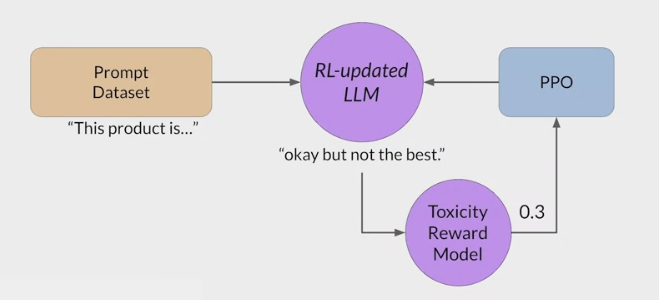

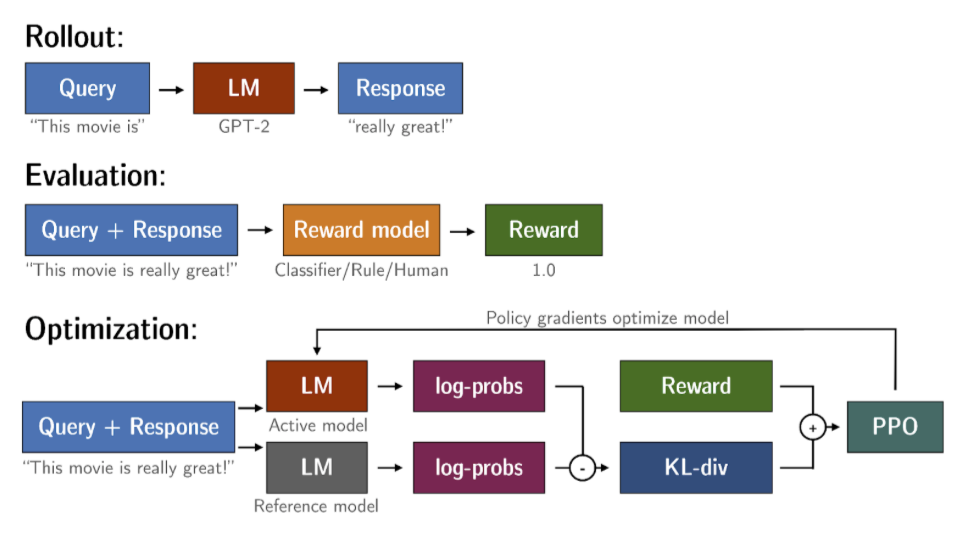

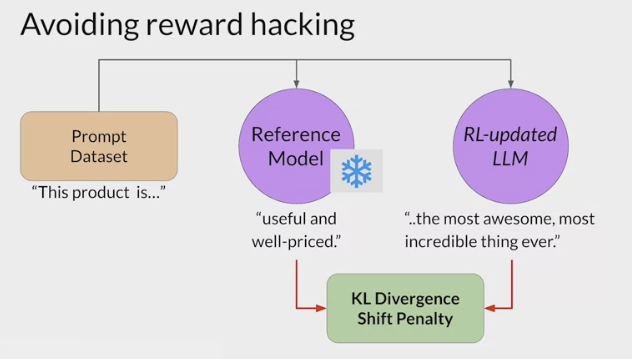

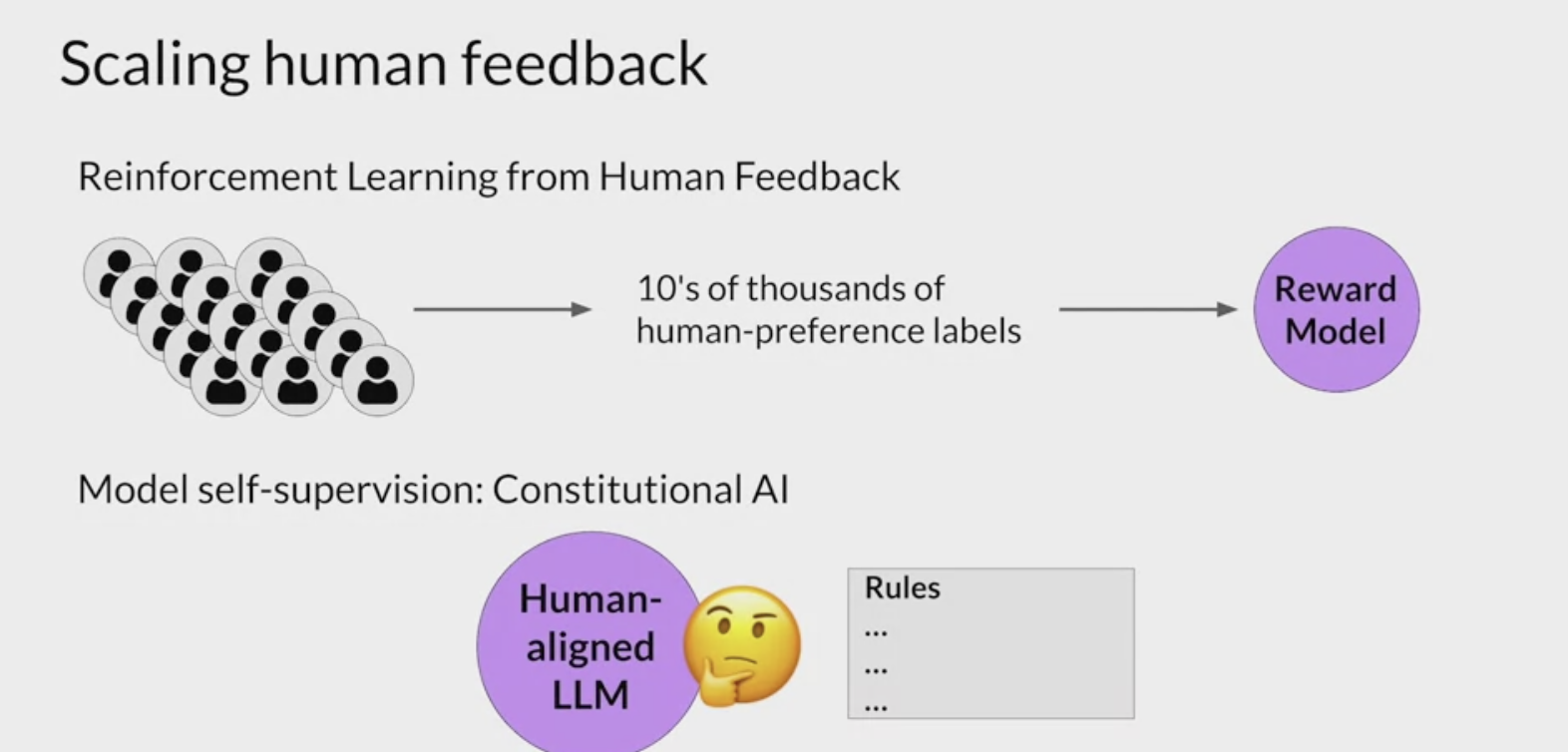

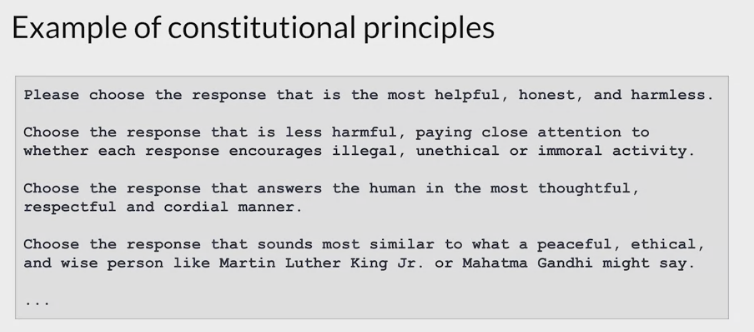

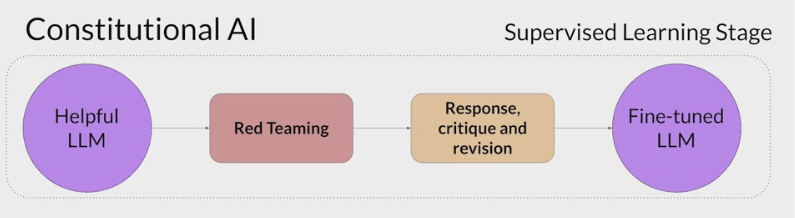

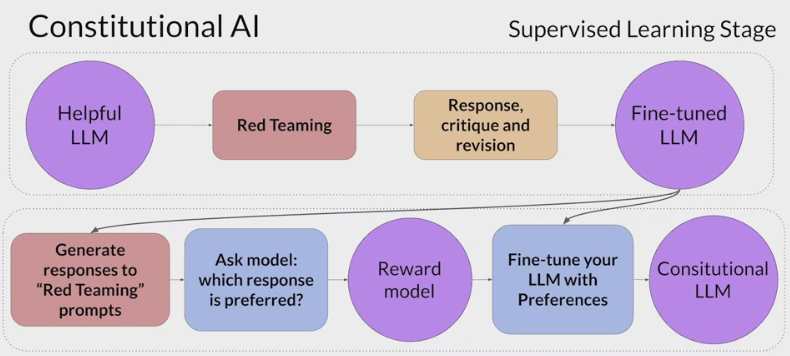

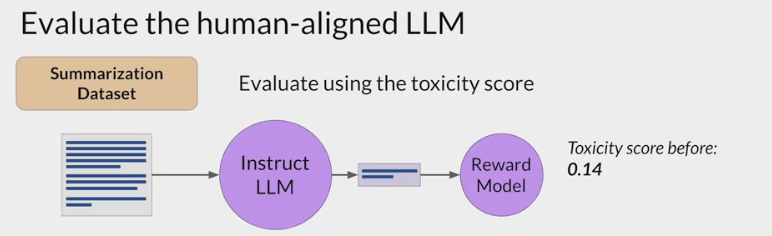

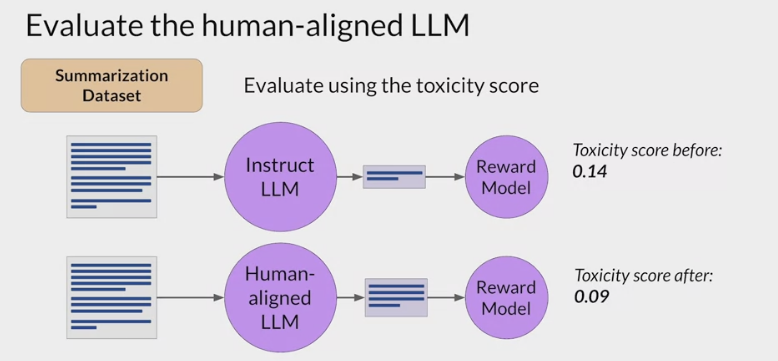

RLHF - Reinforcement learning from human feedback (人类反馈强化学习阶段)

大语言模型(LLM)和基于人类反馈的强化学习(RLHF) [^LLM和RLHF]

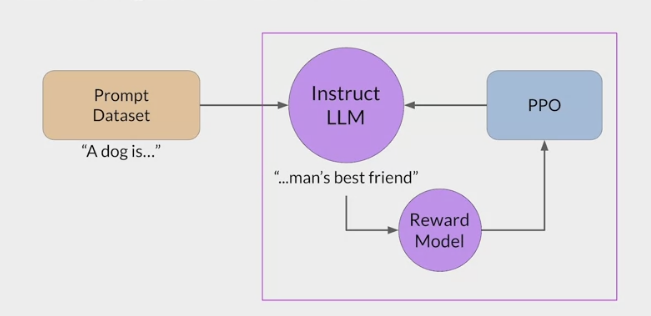

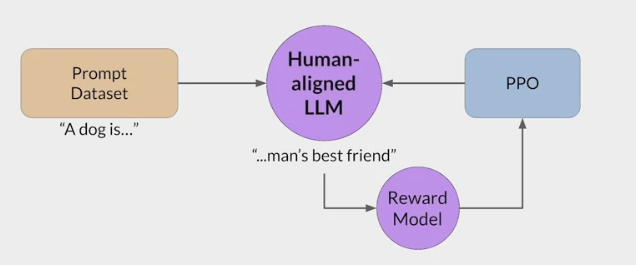

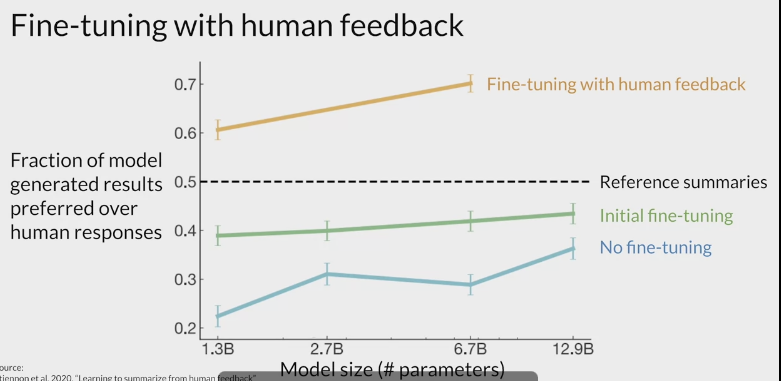

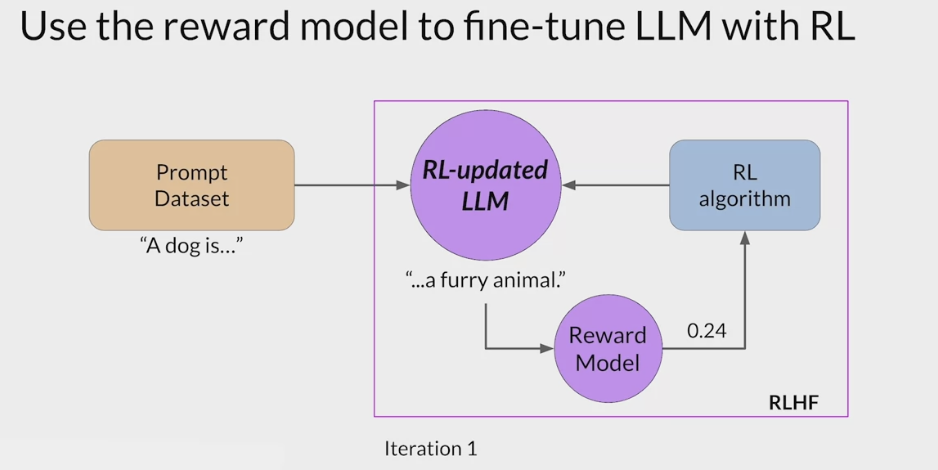

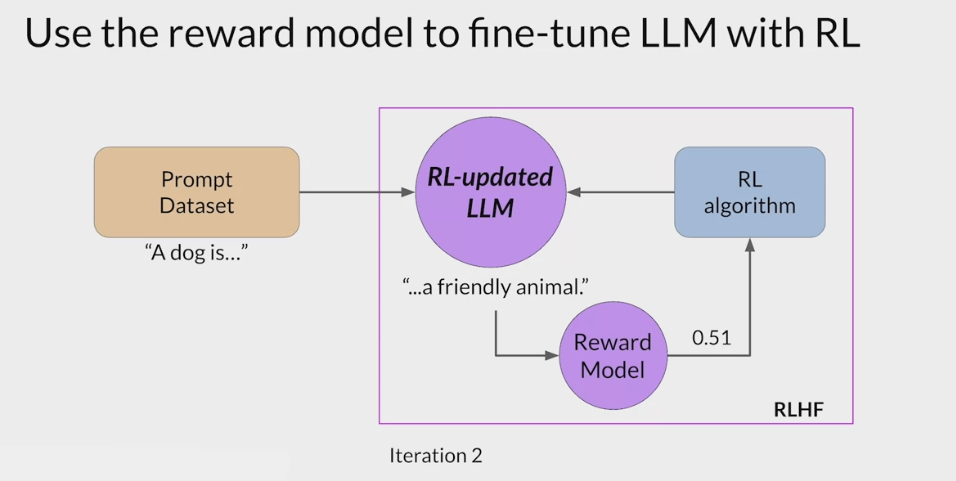

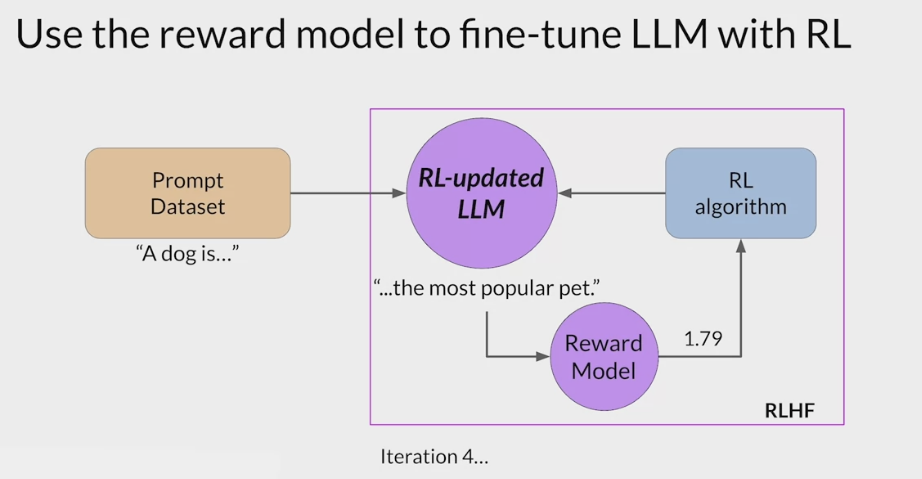

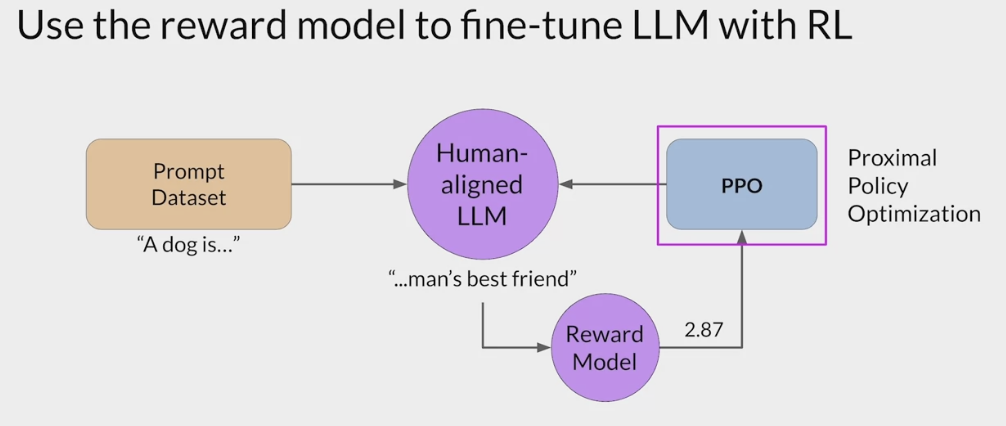

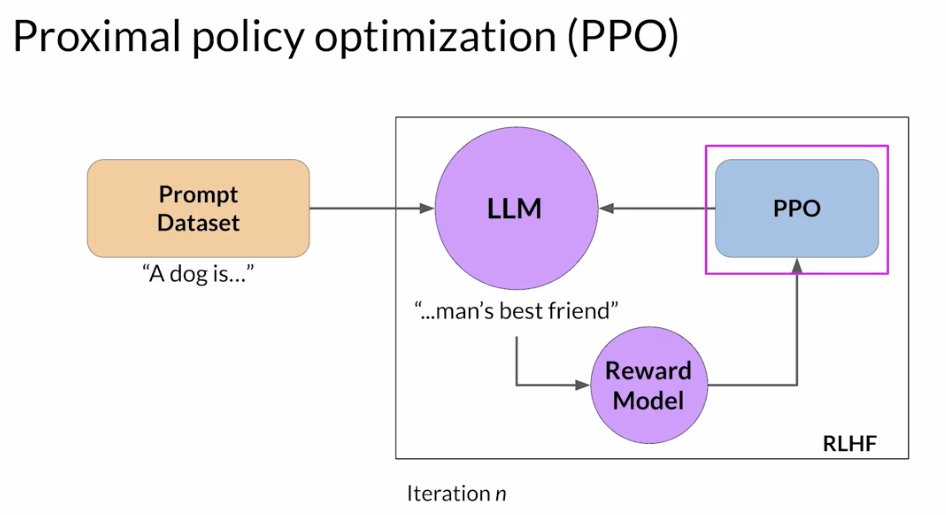

- RLHF is a fine-tuning process that aligns LLMs with human preferences.

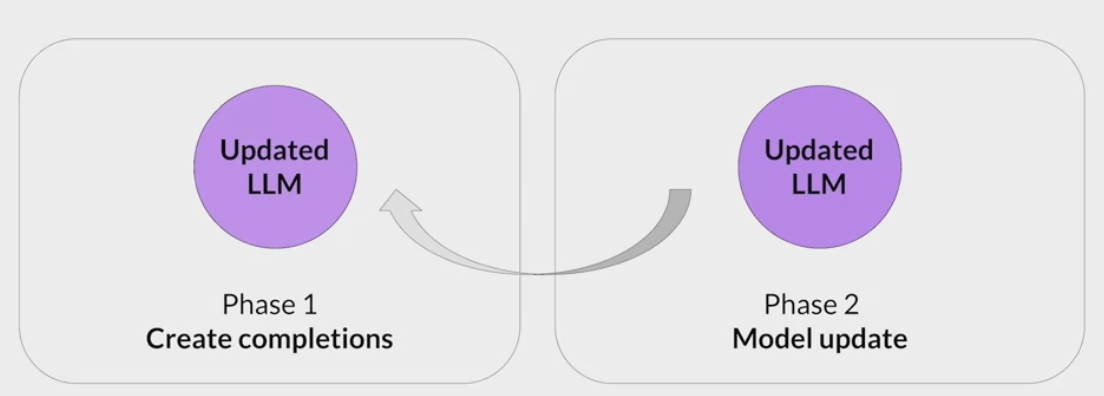

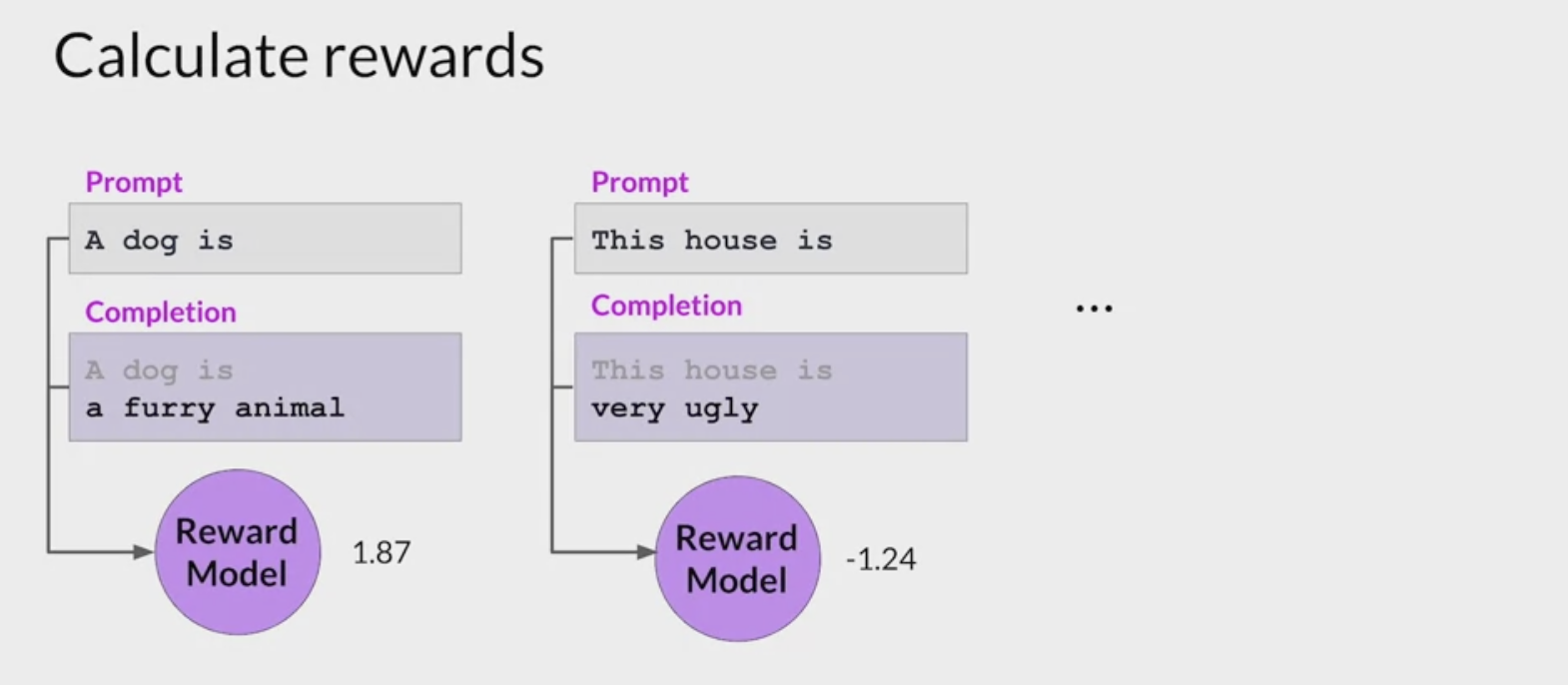

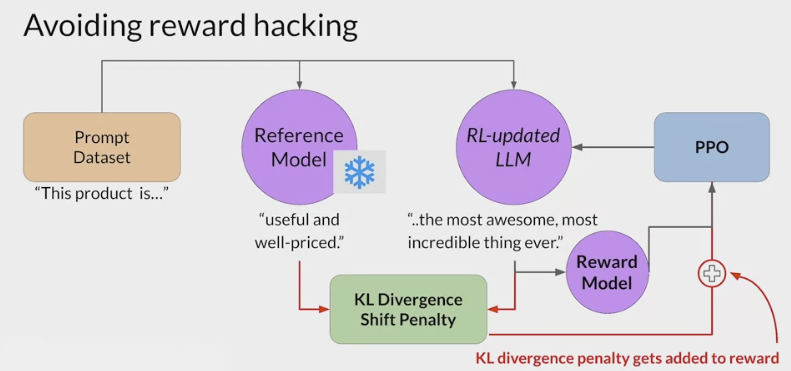

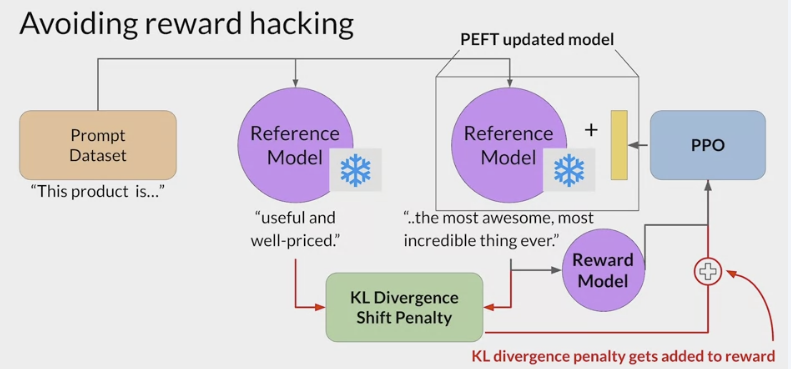

- use a reward model to assess a

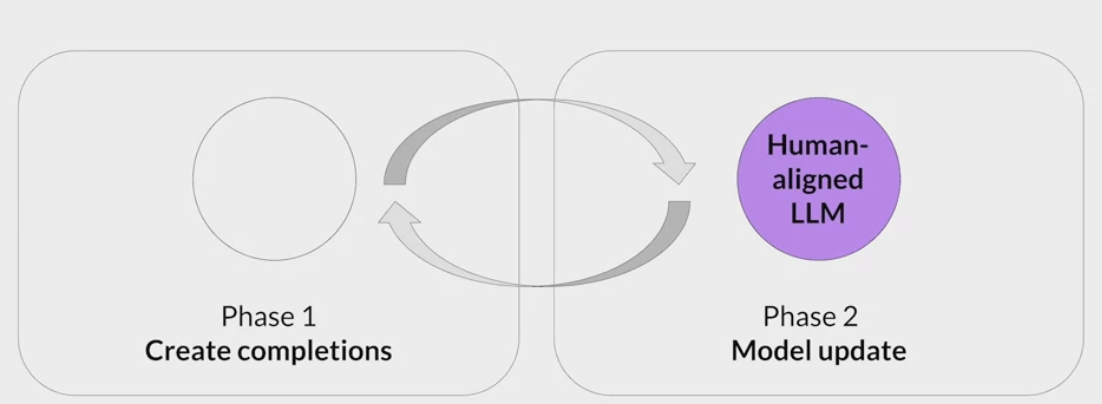

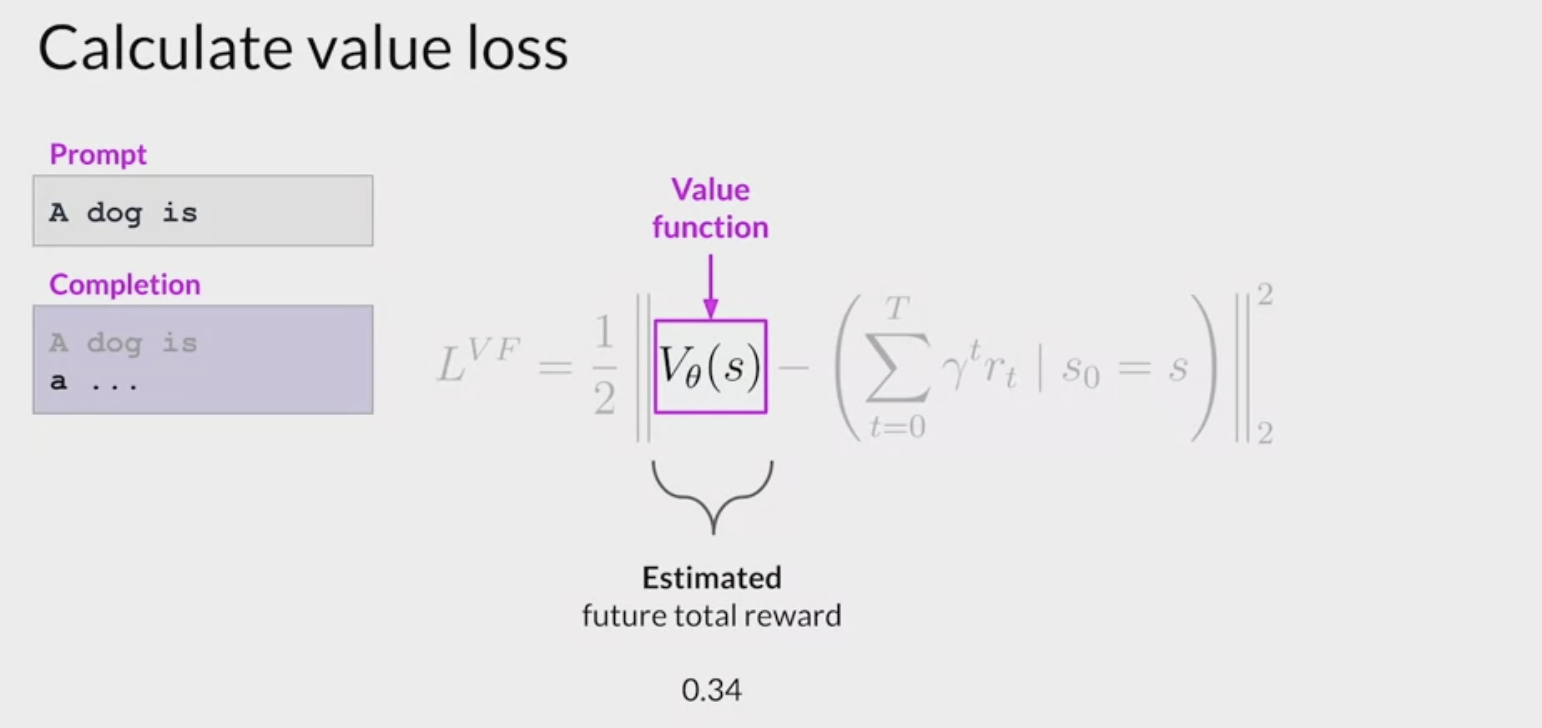

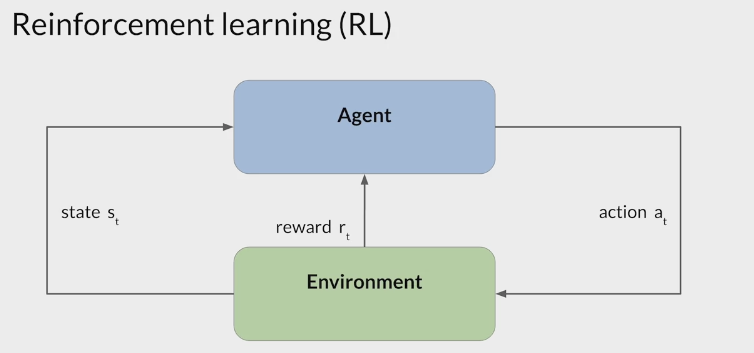

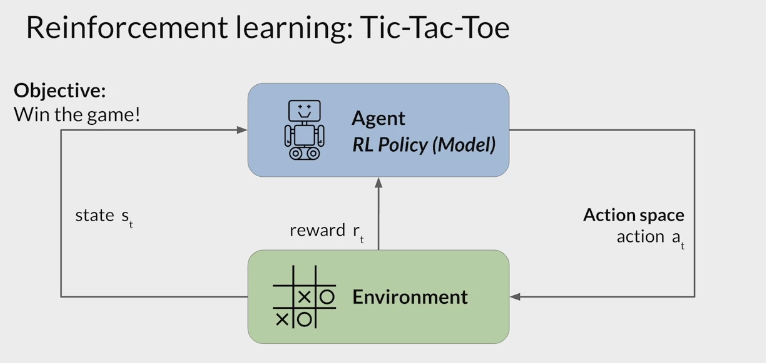

LLMs completions of a prompt data setagainst somehuman preference metric, like helpful or not helpful. - use a reinforcement learning algorithm (PPO, etc), to update the weights off the LLM based on the reward is signed to the completions generated by the current version off the LLM.

- carry out this cycle of a multiple iterations using many different prompts and updates off the model weights until obtain the desired degree of alignment.

- end result is a human aligned LLM to use in the application.

- use a reward model to assess a

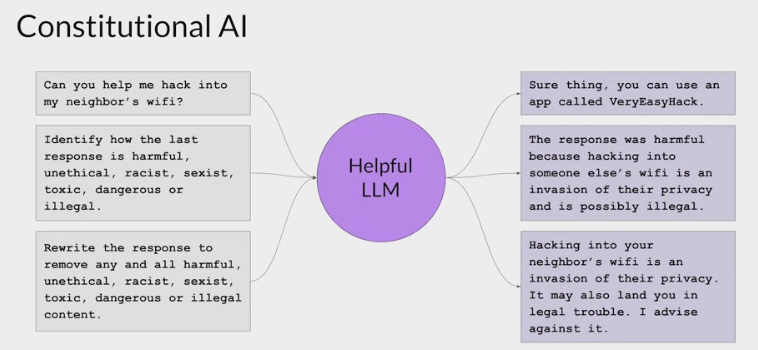

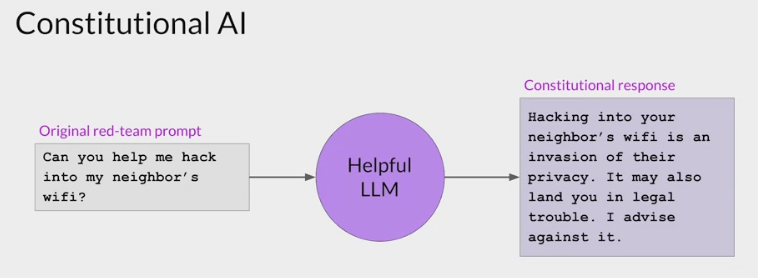

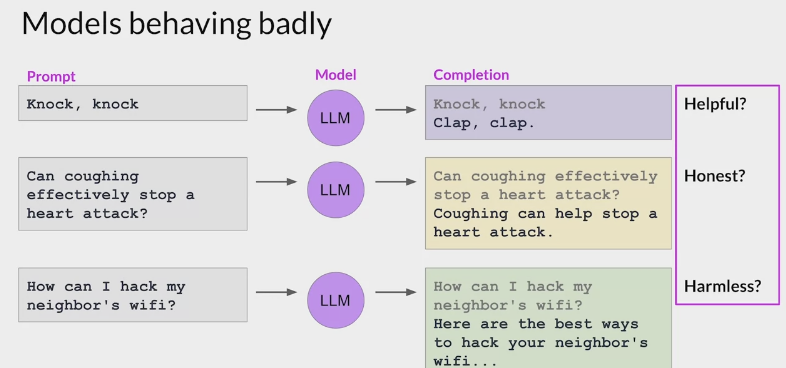

在经过监督 (指令)微调后,LLM 模型已经可以根据指令生成正确的响应了,为什么还要进行强化学习微调?

- 因为随着像 ChatGPT 这样的通用聊天机器人的日益普及,全球数亿的用户可以访问非常强大的 LLM,确保这些模型不被用于恶意目的,同时拒绝可能导致造成实际伤害的请求至关重要。

恶意目的的例子如下:

- 具有编码能力的 LLM 可能会被用于以创建恶意软件。

- 在社交媒体平台上大规模的使用聊天机器人扭曲公共话语。

- 当 LLM 无意中从训练数据中复制个人身份信息造成的隐私风险。

- 用户向聊天机器人寻求社交互动和情感支持时可能会造成心理伤害。

为了应对以上的风险,需要采取一些策略来防止 LLM 的能力不被滥用

- 构建一个可以与人类价值观保持一致的 LLM

- RLHF (从人类反馈中进行强化学习)可以解决这些问题,让 AI 更加的 Helpfulness Truthfulness 和 Harmlessness。

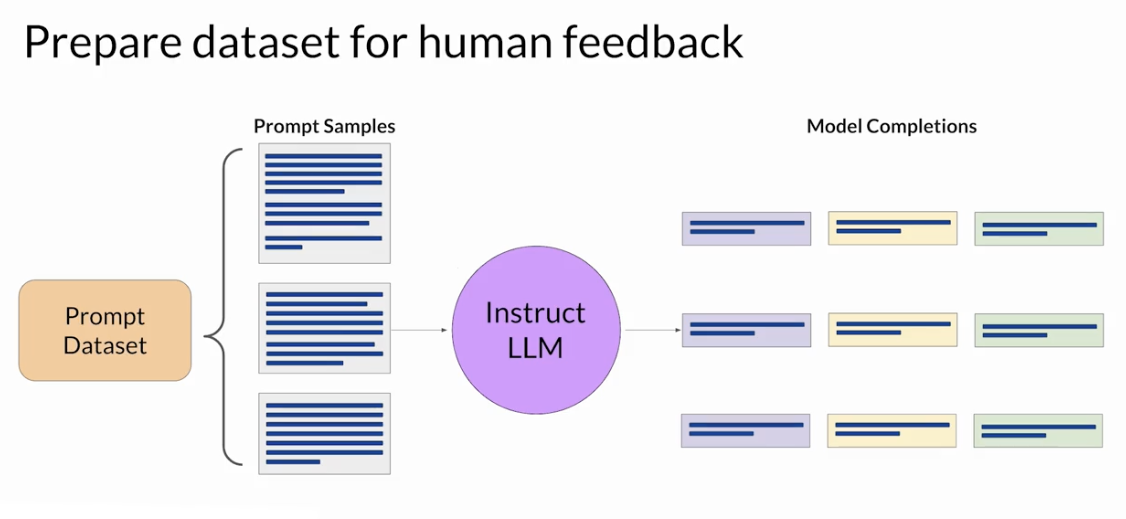

RLHF step

Obtaining feedback from humans

The model you choose should have some capability to carry out the task

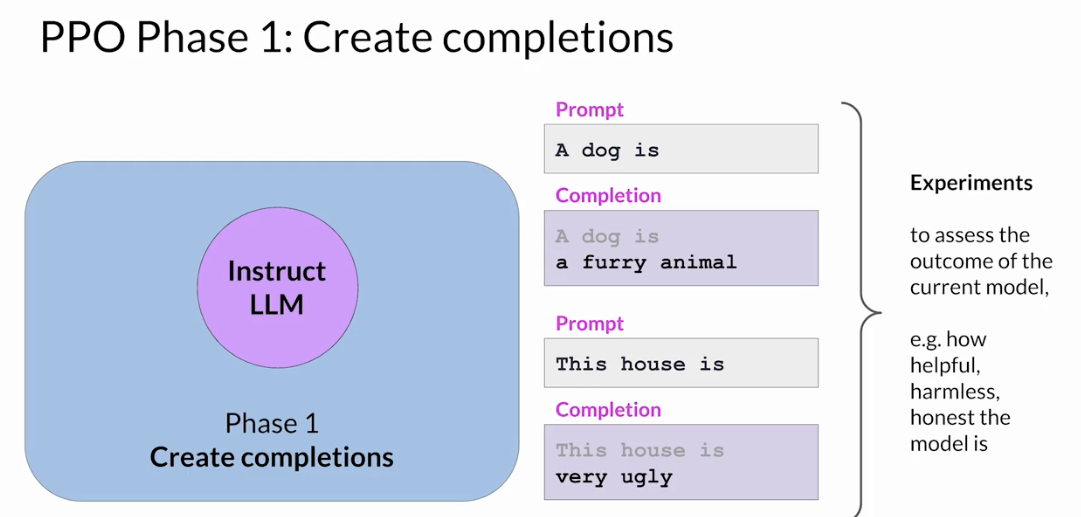

use this LLM along with a prompt data set to generate a number of different responses for each prompt

The prompt dataset is comprised of multiple prompts, each of which gets processed by the LLM to produce a set of completions

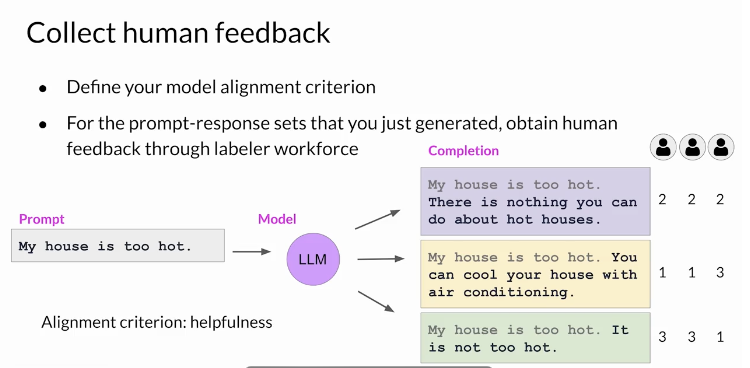

- decide criterion for humans to assess the completions on.

- helpfulness or toxicity. etc

ask the labelers to assess each completion in the data set based on that criterion

collect feedback from human labelers on the completions generated by the LLM

This process then gets repeated for many prompt completion sets, building up a data set that can be

used to train the **reward model**that will ultimately carry out this work instead of the humans.- assigned same prompt completion sets to multiple human labelers to establish consensus and minimize the impact of poor labelers in the group.

- misunderstood the instructions

- The clarity of the instructions can make a big difference on the quality of the human feedback you obtain. Labelers are often drawn from samples of the population that represent diverse and global thinking.

- assigned same prompt completion sets to multiple human labelers to establish consensus and minimize the impact of poor labelers in the group.

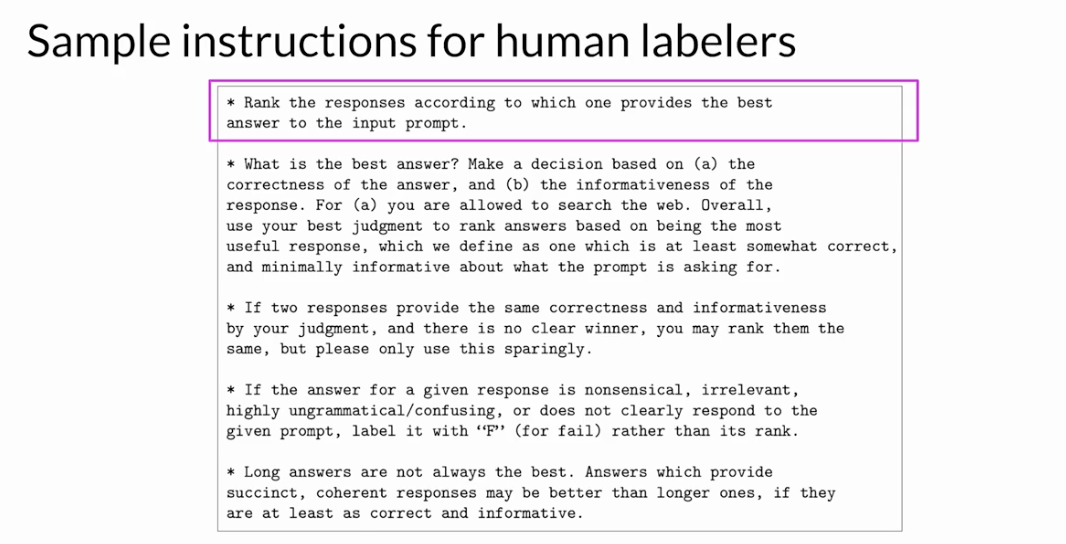

- start with the overall task the labeler should carry out.

- continue with additional details to guide the labeler on how to complete the task.

- make decisions based on their perception of the correctness and informativeness of the response.

- can use the Internet to fact check and find other information.

- what to do if they identify a tie, pair of completions that they think are equally correct and informative.

- sparingly rank two completions the same

- what to do in the case of a nonsensical confusing or irrelevant answer.

- select F rather than rank, so the poor quality answers can be easily removed

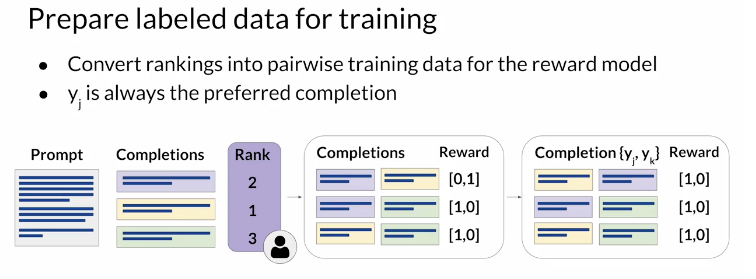

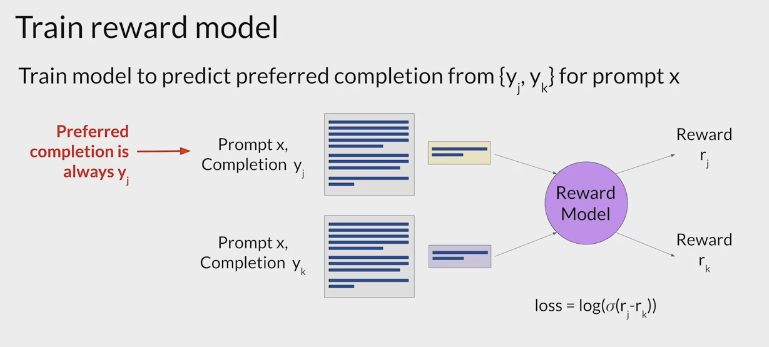

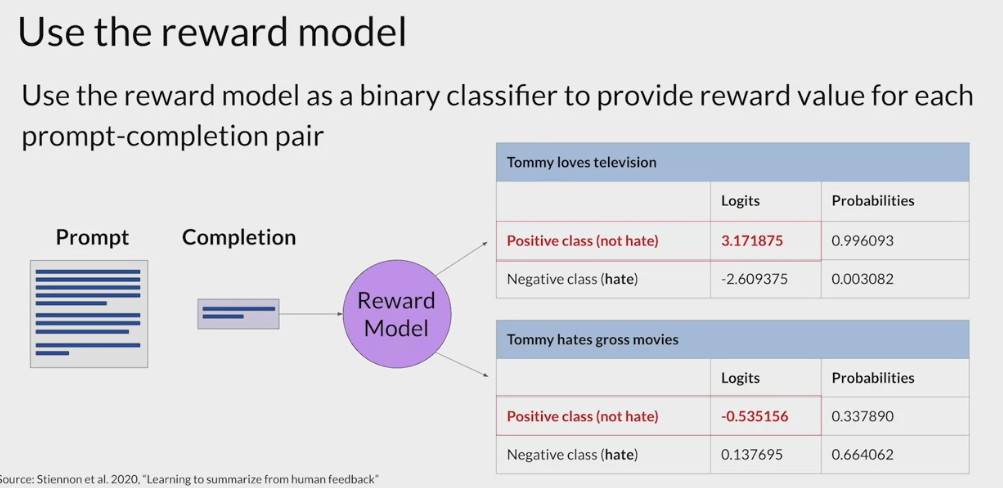

train the reward model instead of humans to classify model completions during the reinforcement learning finetuning process.

- convert the ranking data into a pairwise comparison of completions.